תרגול 10 - MLP and Back-propagation

תקציר התיאוריה

Artificial Neural Networks (ANN)

- רשתות ניורונים מלאכותיות הינן שיטה לבניה של פונקציות פרמטריות.

- במקור, השיטה הינה (כנראה) בהשראת רשתות נוירונים ביולוגיות.

- ברשתות נוירונים מלאכותיות נשלב הרבה פונקציות פרמטריות פשוטות על מנת לקבל מודל אשר יכול לייצג פונקציות מורכבות.

- לרוב, הפונקציות הפשוטות יקבלו מספר משתנים ויחזירו סקלר.

לרוב נבחר את הפונקציות הפשוטות להיות מהצורה:

h(x;w,b)=φ(w⊤x+b)- זה בעצם ״נוירון״.

- φ סקאלרית לא לינארית ומכונה פונקציית ההפעלה.

-

בחירות נפוצות של פונקציית ההפעלה הינן:

- הפונקציה הלוגיסטית (סיגמואיד): φ(x)=σ(x)=1+e−x1

- טנגנס היפרבולי: φ(x)=tanh(x/2)

- ReLU (Rectified Linear Unit): φ(x)=max(x,0)

מושגים:

- יחידות נסתרות (hidden units): הנוירונים אשר אינם מחוברים למוצא הרשת (אינם נמצאים בסוף הרשת).

- רשת עמוקה (deep network): רשת אשר מכילה מסלולים מהכניסה למוצא, אשר עוברים דרך יותר מיחידה נסתרת אחת.

- ארכיטקטורה: הצורה שבה הנוירונים מחוברים בתוך הרשת.

מוטיבציה

- רשתות נוירונים הן פונקציות פרמטריות לכל דבר ועניין.

-

נשתמש בהן בקורס למטרות הבאות:

- פתרון בעיות סיווג בגישה הדיסקרימינטיבית הסתברותית.

- פתרון בעיות רגרסיה בשיטת ERM.

-

לרוב, נפתור את בעיות האופטימיזציה של מציאת הפרמטרים בעזרת gradient descent.

- ניעזר באלגוריתם שנקרא back-propagation על מנת לחשב את הנגזרות של הרשת על פי הפרמטריים.

הערה: נשתמש בוקטור θ אשר יאגד את כל הפרמטרים של הרשת (הפרמטרים של כל הנוירונים).

הערה לגבי השם loss

- עד כה השתמשנו בשם loss בהקשר של פונקציות risk (הקנס שמקבלים על שגיאת חיזוי בודדת מסויימת).

- בהקשר של רשתות נוירונים משתמשים לרוב במושג זה על מנת לתאר את הפונקציית המטרה (ה objective) שאותו רוצים למזער בבעיית האופטימיזציה.

- בכדי למנוע בלבול, בקורס זה נשתדל להיצמד להגדרה המקורית של פונקציית ה loss (שמגדירה את פונקציית ה risk) ונמשיך להשתמש בשם פונקציית מטרה או objective בכדי לתאר את הביטוי שאותו אנו רוצים למזער.

Back-Propagation

- Back-propagation הוא אלגוריתם המשתמש בכלל השרשת על מנת לחשב את הנגזרות של רשת נוירונים.

- המטרה באלגוריתם זה היא לחשב את הנגזרת של המוצא ביחס לכל אחד מהפרמטרים ברשת, כך שלאחר מכן נוכל להפעיל את אלגוריתם gradient descent על מנת לעדכן את הפרמטרים

- תזכורת לכלל השרשרת:

דוגמא (מההרצאה)

נסתכל על הרשת הבאה:

- עבור x ו θ נתונים:

- נרצה לחשב את הנזרות של מוצא הרשת y לפי הפרמטרים θ.

נסתכל לדוגמא על הנגזרת של y1 לפי θ3. לשם הנוחות נסמן ב zi את המוצא של הניורון hi.

נוכל לפרק את ∂θ3∂y על פי כלל השרשת:

∂θ3∂y1=∂z3∂y1∂θ3∂z3=∂z3∂y1∂θ3∂h3נוכל לפרק גם את dz3dy1 על פי כלל השרשרת:

∂z3∂y1=∂z6∂y1∂z3∂z6=∂z6∂y1∂z3∂h6ונוכל להמשיך ולפרק את dz6dy1:

∂z6∂y1=∂z7∂y1∂z6∂z7=∂z7∂h8∂z6∂h7- זאת אומרת שאם נדע לחשב את הנגזרות של dzidhi ו dθidhi נוכל לחשב את הגזרות לפי כל הפרמטרים.

- נסתכל לדוגמא על הנגזרת:

- ראשית, נגזור את הפונקציה h6 ונציב את הערכים של z3, z4 ו θ6.

- בכדי לחשב את הערכים של zi עלינו להעביר את x דרך הרשת ולשמור את כל ערכי הביניים zi. חישוב זה של ערכי הביניים נקרא ה forward pass.

לאחר שחישבנו את ערכי הביניים zi, נוכל להתחיל לחשב את כל הנגזרות של הרשת מהמוצא לכיוון הכניסה. זאת אומרת:

- נחשב את: ∂θ8∂y1, ∂z7∂y1.

- נשתמש ב ∂z7∂y1 בכדי לחשב את ∂θ7∂y1, ∂z5∂y, ∂z6∂y.

- נשתמש ב ∂z6∂y1 בכדי לחשב את ∂θ6∂y1, ∂z3∂y, ∂z4∂y.

וכן הלאה. מכיוון שבשלב זה אנו מחשבים את הנגזרות מהמוצא לכיוון הכניסה, שלב זה נקרא ה backward pass ומכאן גם מקבלת השיטה את שמה.

MultiLayer Perceptron (MLP)

- ארכיטקטורה נפוצה לרשת נוירונים נקראת MLP.

- במודל זה הנוירונים מסודרים בשתייים או יותר שכבות (layers) של נוירונים.

-

השכבות ב MLP הן שכבות שמכונות Fully Connected (FC):

- כל נוירון מוזן מכל הנוריונים שבשכבה שלפניו.

הניורונים הם מהצורה:

hi,j(zi−1;wi,j,bi,j)=φ(wi,jTzi−1+bi,j)- הפרמטרים הנלמדים הינם המשקולות wi,j ואברי היסט bi,j בקומבינציה הלניארית שמכיל כל נוירון hi,j.

ה Hyperparameters של MLP הינם:

- מספר השכבות

- מספר הנוירונים בכל שכבה

- פונקציית האקטיבציה (שיכולה להשתנות משכבה לשכבה)

תרגיל 10.1 - Back propagation in MLP

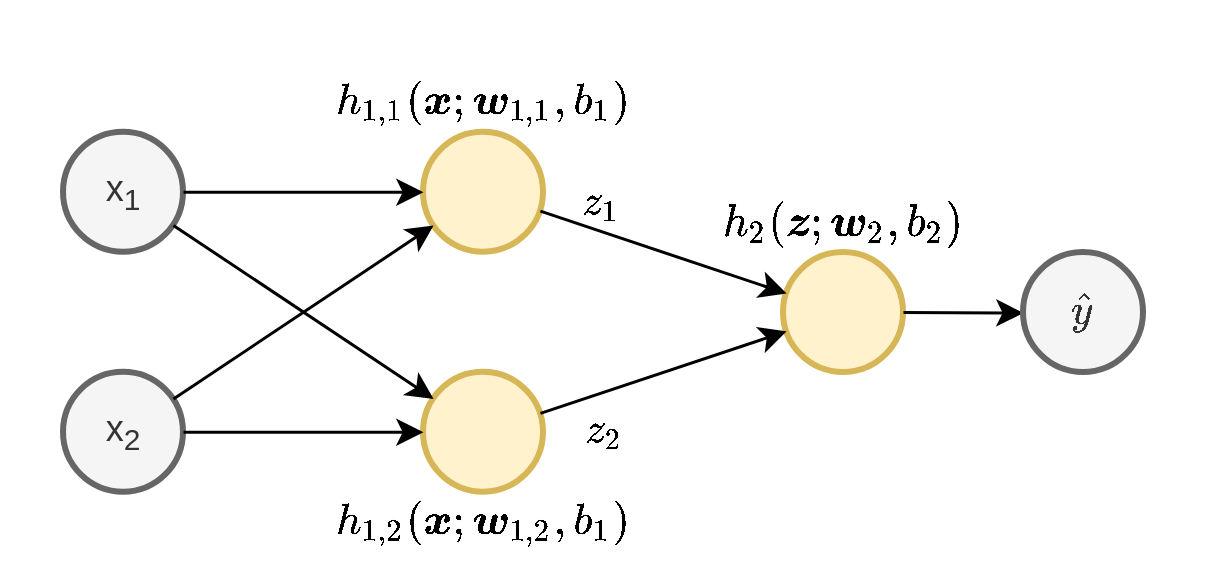

נפתור בעיית רגרסיה בעזרת ERM ורשת ה MLP הבאה:

- כניסה באורך 2

- שכבה נסתרת אחת ברוחב 2

- יציאה באורך 1 (מוצא סקלרי)

- ב- h1,1 ו h1,2 יש פונקציית אקטיבציה מסוג ReLU

- ב- h2 אין פונקציה אקטיבציה.

שימו לב: איבר ההיסט בשכבה הראשונה b1 משותף לשתי הנוירונים בשכבה זו.

נרכז את כל הפרמטרים של הרשת לוקטור פרמטרים אחד:

θ=[w1,1⊤,w1,2⊤,b1,w2⊤,b2]⊤ונסמן את הפונקציה שאותה הרשת מממשת ב y^=f(x;θ).

1) בעבור מדגם נתון D={x(i),y(i)}i=1N ופונקציית מחיר מסוג RMSE רשמו את בעיית האופטימיזציה שיש לפתור. בטאו את תשובתכם בעזרת הפונקציה f.

פתרון:

פונקציית המחיר (סיכון) של RMSE נתונה על ידי:

E[(y^−y)2]=E[(f(x;θ)−y)2]הסיכון האמפירי מתקבל על ידי החלפה של התחולת בממוצע על המדגם:

N1i∑(f(x(i);θ)−y(i))2בעיית האופטימיזציה שנרצה לפתור הינה למצוא את הפרמטרים שימזערו את הסיכון האמפירי:

θargminN1i∑(f(x(i);θ)−y(i))2=θargminN1i∑(f(x(i);θ)−y(i))22) נפתור את בעיית האופטימיזציה בעזרת gradient descent עם גודל קצב לימוד η. רשמו את כלל העדכון של הפרמטרים של המודל θ על ידי שימוש בגרדיאנט של הרשת לפי הפרמטרים, ∇θf(x;θ).

נסמן את ה objective שאותו נרצה למזער ב:

g(θ)=N1i∑(f(x(i);θ)−y(i))2כלל העדכון של הפרמטרים הינו:

θ(t+1)=θ(t)−η∇θg(x;θ(t))=θ(t)−η∇θN1i∑(f(x(i);θ(t))−y(i))2=θ(t)−N2ηi∑(f(x(i);θ(t))−y(i))∇θf(x(i);θ(t))3) נתון המדגם הבא באורך 2:

x(1)x(2)=[1,2]⊤=[0,−1]⊤y(1)=70y(2)=50כמו כן, נתון כי בצעד מסויים t הערכים של הפרמטרים הינם:

b1(t)w1,1(t)w1,2(t)b2(t)w2(t)=1=[2,3]⊤=[4,−5]⊤=6=[7,8]⊤חשבו את הערך של b1(t+1) בעבור η=0.01.

נרצה לחשב את:

b1(t+1)=b1(t)−N2ηi∑(f(x(i);θ(t))−y(i))db1df(x(i);θ(t))נחשב את db1df(x(i);θ(t)) בעזרת back-propagation.

i=1

נחשב את ה forward-pass בשביל למצוא את משתני הביניים ואת המוצא:

z1z2y=max(x(1)⊤w1,1+b1,0)=max([1,2][2,3]⊤+1,0)=max(9,0)=9=max(x(1)⊤w1,2+b1,0)=max([1,2][4,−5]⊤+1,0)=max(−5,0)=0=z⊤w2+b2=[9,0][7,8]⊤+6=69- נחשב את הנגזרות ב backward-pass.

- נתחיל בחישוב של dz1dy^ ו dz1dy^:

נשתמש בחישוב זה בכדי לחשב את db1df(x;θ)=db1dy^, נשים לב ש b1 מופיע פעמים ברשת, ב h1,1 וב h1,2:

(נשתמש בעובדה ש dxdmax(x,0)=I{x>0})

db1dy^=dz1dy^db1dz1+dz2dy^db1dz2=7⋅I{x⊤w1,1+b1>0}+8⋅I{x⊤w1,2+b1>0}=7i=2

נחשב באופן דומה את ה- Forward Pass:

z1z2y=max(x(2)⊤w1,1+b1,0)=max([0,−1][2,3]⊤+1,0)=max(−2,0)=0=max(x(2)⊤w1,2+b1,0)=max([0,−1][4,−5]⊤+1,0)=max(6,0)=6=z⊤w2+b2=[0,6][7,8]⊤+6=54Backward-pass:

dz1dy^dz2dy^=dz1d(z⊤w2+b2)=w2,1=7=dz2d(z⊤w2+b2)=w2,2=8 db1dy^=dz1dy^db1dz1+dz2dy^db1dz2=7⋅I{x⊤w1,1+b1>0}+8⋅I{x⊤w1,2+b1>0}=8חישוב צעד העדכון

נציב את התוצאות שקיבלנו ואת η=0.01:

b1(t+1)=b1(t)−N2ηi∑(f(x(i);θ(t))−y(i))db1df(x(i);θ(t))=1−0.01((f(x(1);θ(t))−y(1))db1df(x(1);θ(t))+(f(x(2);θ(t))−y(2))db1df(x(2);θ(t)))=1−0.01((69−70)⋅7+(54−50)⋅8)=1−0.01⋅25=0.75תרגיל 10.2

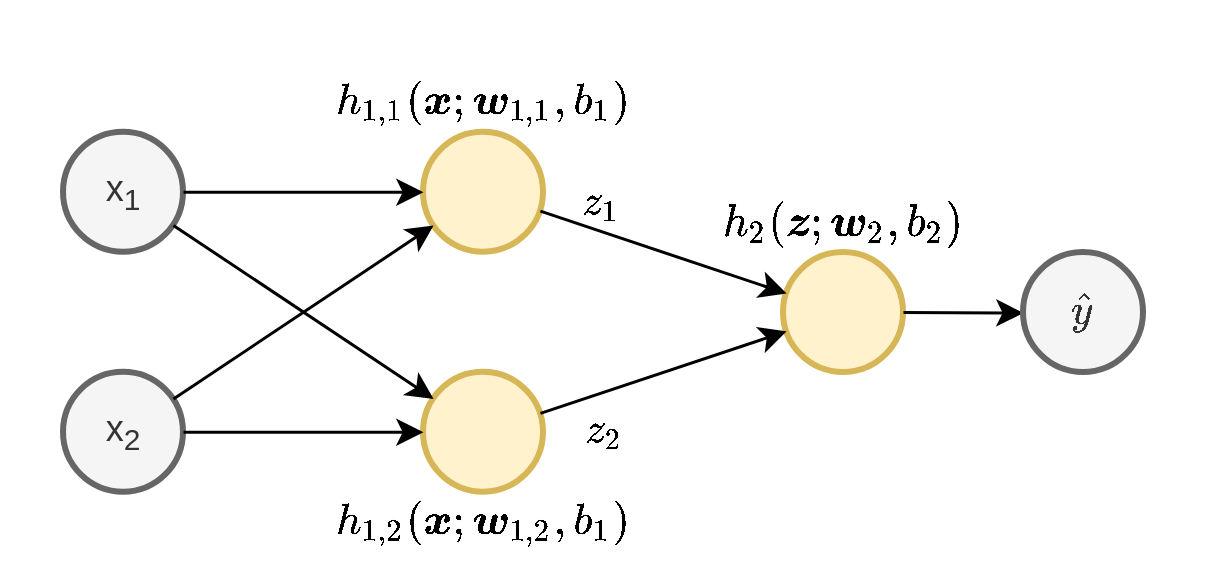

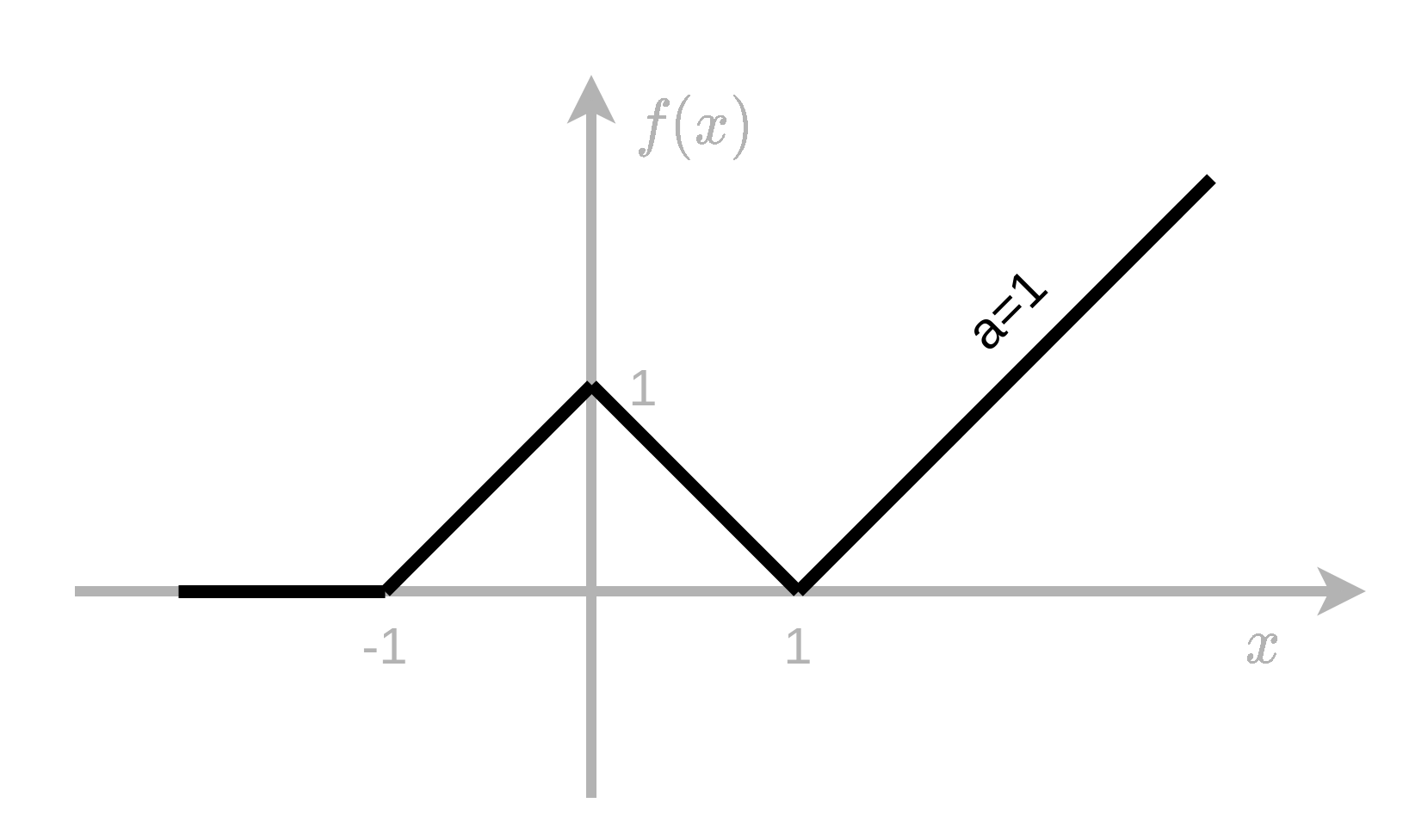

1) הראו כיצד ניתן לייצג את הפונקציה הבאה בעזרת רשת MLP עם פונקציית אקטיבציה מסוג ReLU.

שרטטו את הרשת ורשמו את הערכים של פרמטרי הרשת.

פתרון:

- נבנה פונקציות רציפות ולינאריות למקוטעין, בעלות מספר סופי של קטעים, כמו זו בשבשאלה זו.

- נשתמש בנויירונים בעלי פונקציית אקטיבציה מסוג ReLU הפועלים על קומבינציה לינארית של הכניסות.

- נבנה פונקציה זו בעזרת MLP בעל שיכבה נסתרת אחת אשר דואגת לייצג את המקטעים השונים ושיכבת מוצא אשר דואגת לשיפוע בכל מקטע.

- נקבע את קבוע הbias בכל נוירון כך שהשינוי בשיפוע של ה ReLU (ב x=0) יהיה ממוקם על נקודה בה משתנה השיפוע של הפונקציה המקורית.

כעת נדאג לשיפועים. נסתכל על מקטעים משמאל לימין.

- המקטע השמאלי ביותר הינו בעל שיפוע 0 ולכן הוא כבר מסודר, שכן כל הפונקציות אקטיבציה מתאפסות באיזור זה.

- המקטע [−1,0] מושפע רק מן הנוירון הראשון. השיפוע במקטע זה הינו 1 ולכן ניתן משקל של 1 לנירון זה.

- המקטע [0,1] מושפע משני הנוירונים הראשונים. הנוירון הראשון כבר תורם שיפוע של 1 במקטע זה ולכן עלינו להוסיף לו עוד שיפוע של −2 על מנת לקבל את השיפוע של −1 הנדרש. ולכן ניתן משקל של −2 לנירון השני.

- באופן דומה ניתן לנוירון השלישי משקל של 2.

סה"כ קיבלנו כי h2(z1,z2,z3)=z1−2z2×2z3

2) האם ניתן לייצג במדוייק את הפונקציה f(x)=x2+∣x∣ בעזרת רשת MLP עם אקטיבציה מסוג ReLU? הסבירו ו/או הדגימו.

מכיוון ש:

- נוירון בעל פונקציית הפעלה מסוג ReLU מייצג פונקציה רציפה ולינארית למקוטעין.

- כל הרכבה או סכימה של פונקציות רציפות ולינאריות למקוטעין יצרו תמיד פונקציה חדשה שגם היא רציפה ולינארית למקוטעין.

מכאן, שנוכל באמצעת נוירונים מסוג ReLU לייצג רק פונקציות רציפות ולנאריות למקוטעין.

- מכיוון שx2 אינה לינארית אנו נוכל רק לקרב אותה, אך לא לייצג אותה במדוייק.

תרגיל מעשי - איבחון סרטן שד עם MLP

נסתכל שוב על הבעיה של איבחון סרטן שד על סמך תצלום מיקרוסקופי של ריקמה.

| diagnosis | radius_mean | texture_mean | perimeter_mean | area_mean | smoothness_mean | compactness_mean | concavity_mean | |

|---|---|---|---|---|---|---|---|---|

| 0 | M | 17.99 | 10.38 | 122.8 | 1001 | 0.1184 | 0.2776 | 0.3001 |

| 1 | M | 20.57 | 17.77 | 132.9 | 1326 | 0.08474 | 0.07864 | 0.0869 |

| 2 | M | 19.69 | 21.25 | 130 | 1203 | 0.1096 | 0.1599 | 0.1974 |

| 3 | M | 11.42 | 20.38 | 77.58 | 386.1 | 0.1425 | 0.2839 | 0.2414 |

| 4 | M | 20.29 | 14.34 | 135.1 | 1297 | 0.1003 | 0.1328 | 0.198 |

| 5 | M | 12.45 | 15.7 | 82.57 | 477.1 | 0.1278 | 0.17 | 0.1578 |

| 6 | M | 18.25 | 19.98 | 119.6 | 1040 | 0.09463 | 0.109 | 0.1127 |

| 7 | M | 13.71 | 20.83 | 90.2 | 577.9 | 0.1189 | 0.1645 | 0.09366 |

| 8 | M | 13 | 21.82 | 87.5 | 519.8 | 0.1273 | 0.1932 | 0.1859 |

| 9 | M | 12.46 | 24.04 | 83.97 | 475.9 | 0.1186 | 0.2396 | 0.2273 |

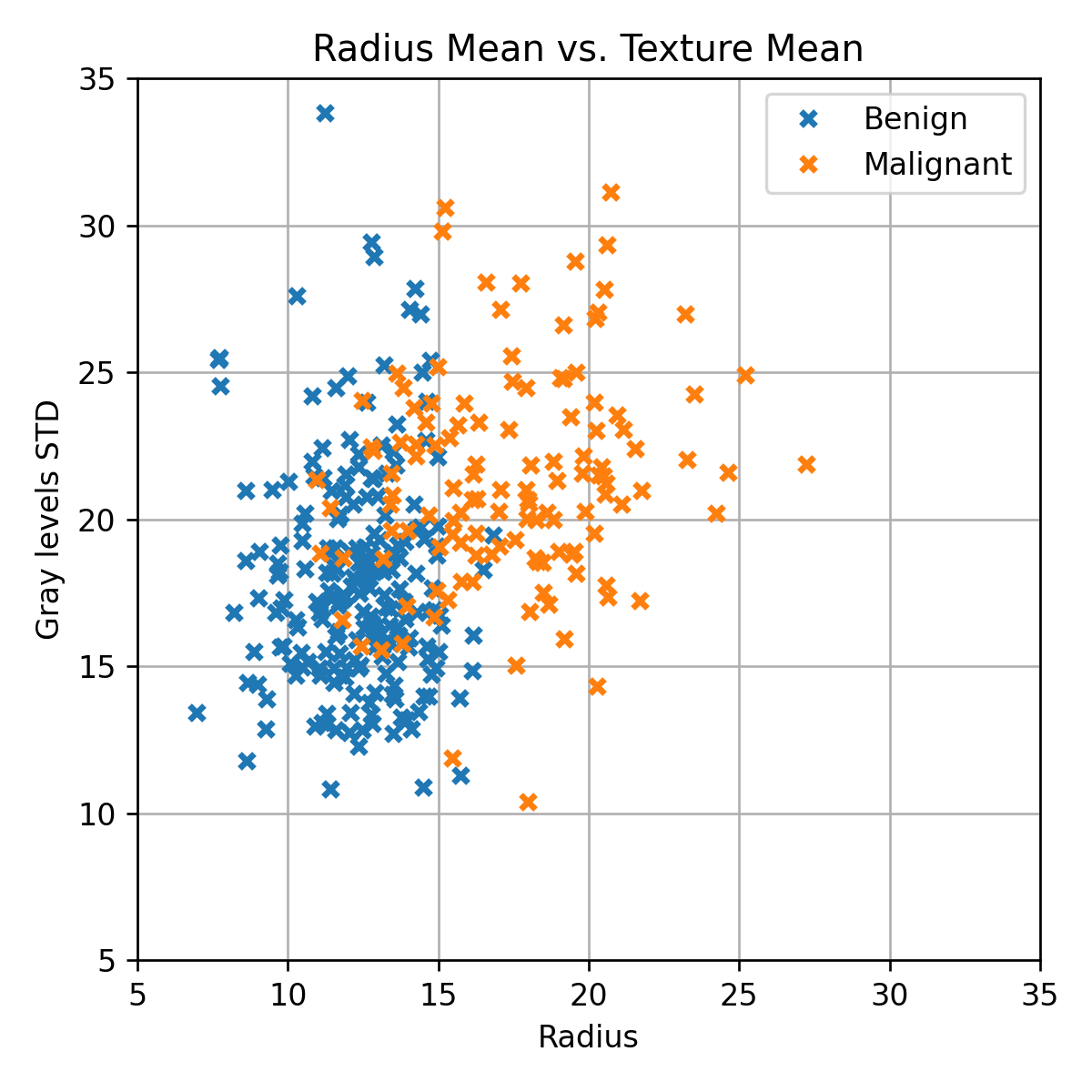

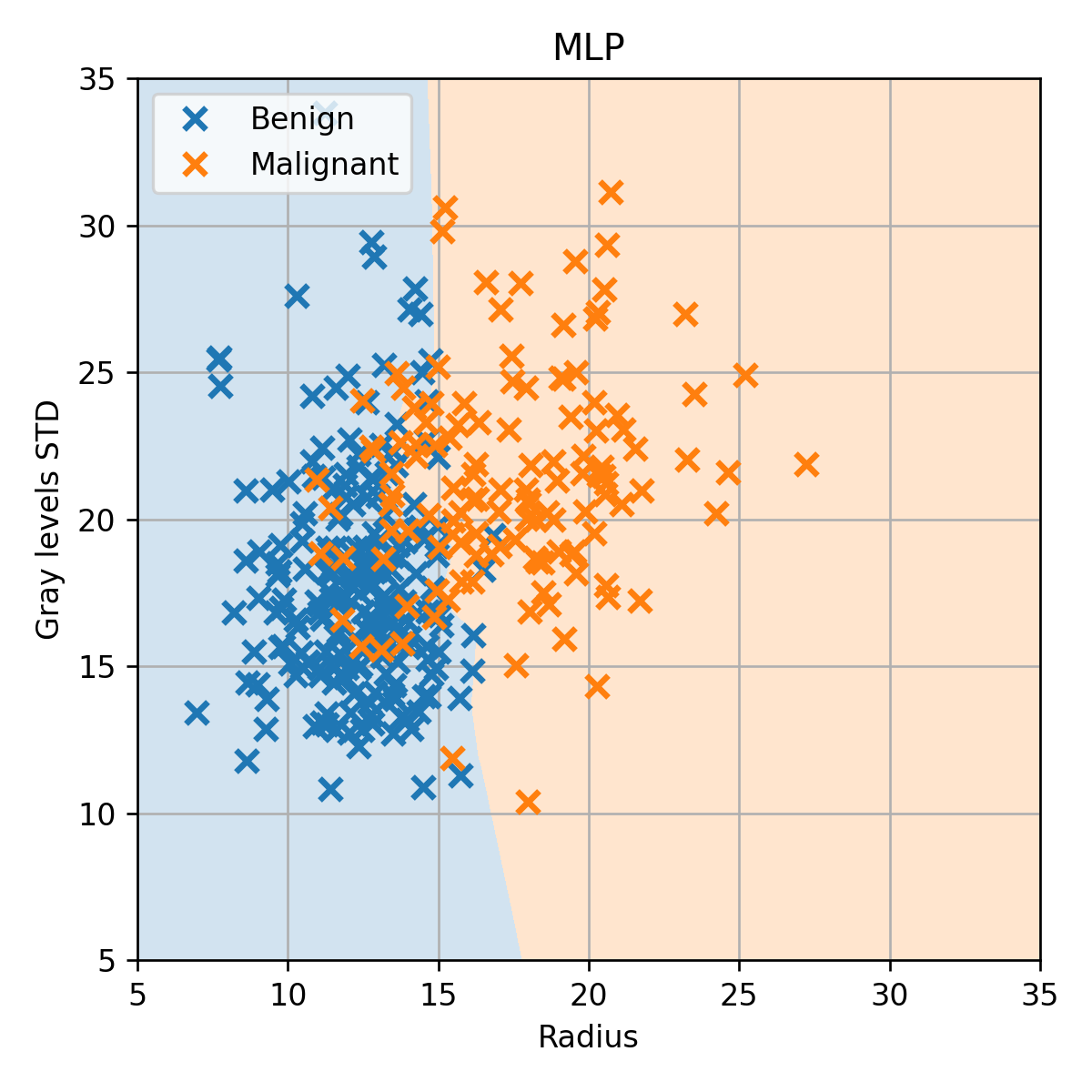

נתחיל שוב בביצוע איבחון על סמך שתי העמודות הראשונות בלבד. אנו עושים זאת כמובן רק בכדי שנוכל להציג את הבעיה בגרף דו מימדי.

- נפצל אותו שוב ל 60% train / 20% validation / 20% test.

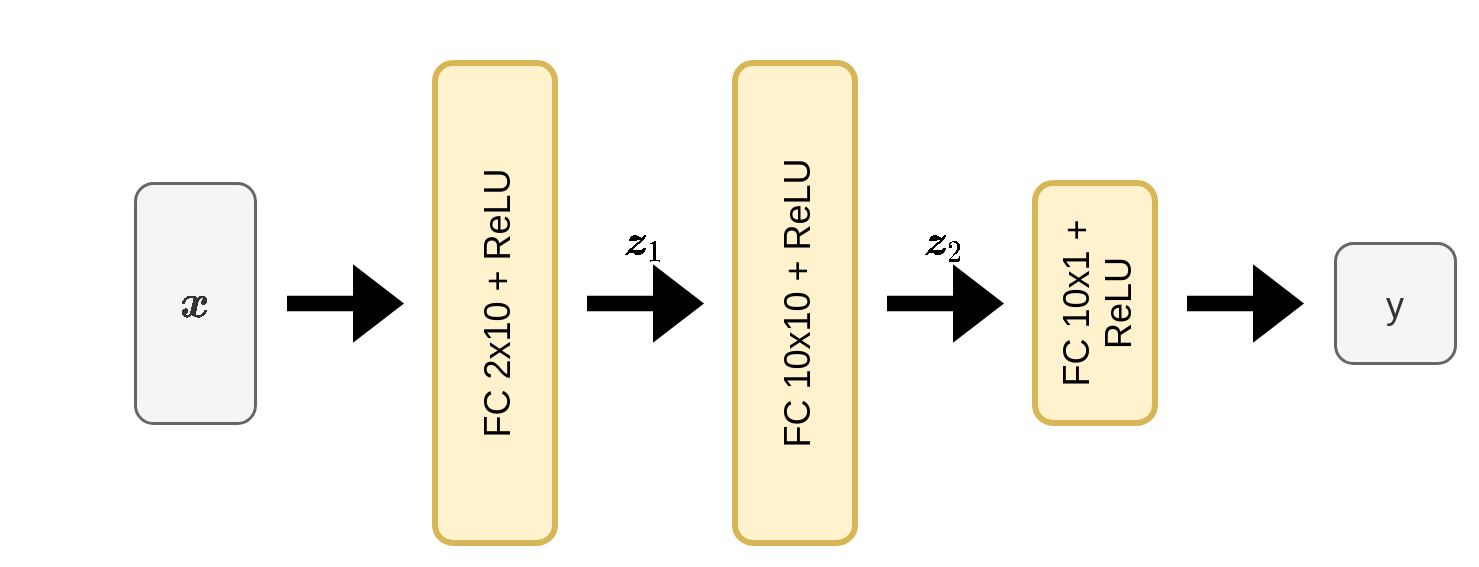

- וננסה להתאים לו את המודל הבא:

- FC 2x10 מציין שכבה של fully connected שבכניסה אליה יש וקטור באורך 2 וביציאה יש וקטור ברוחב 10

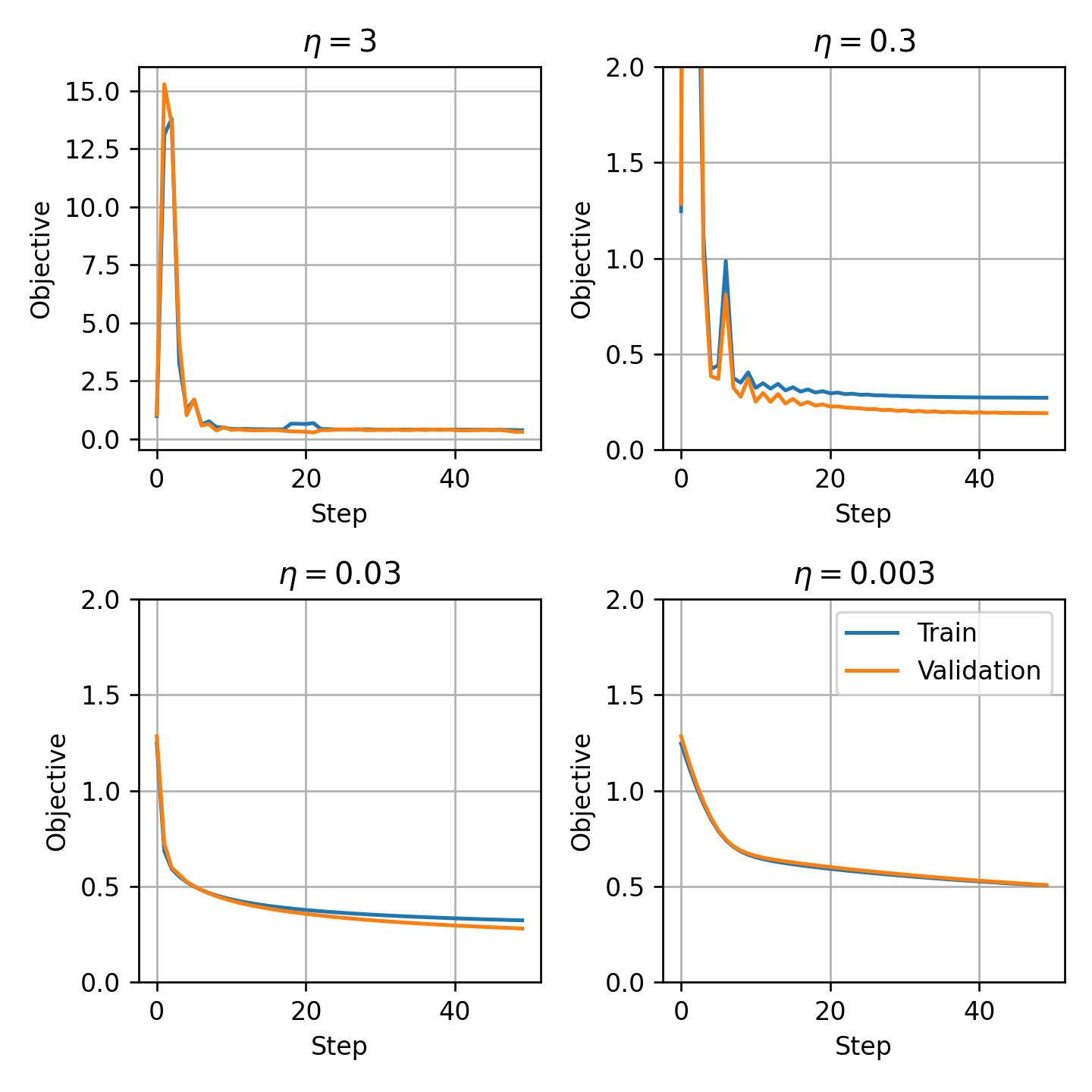

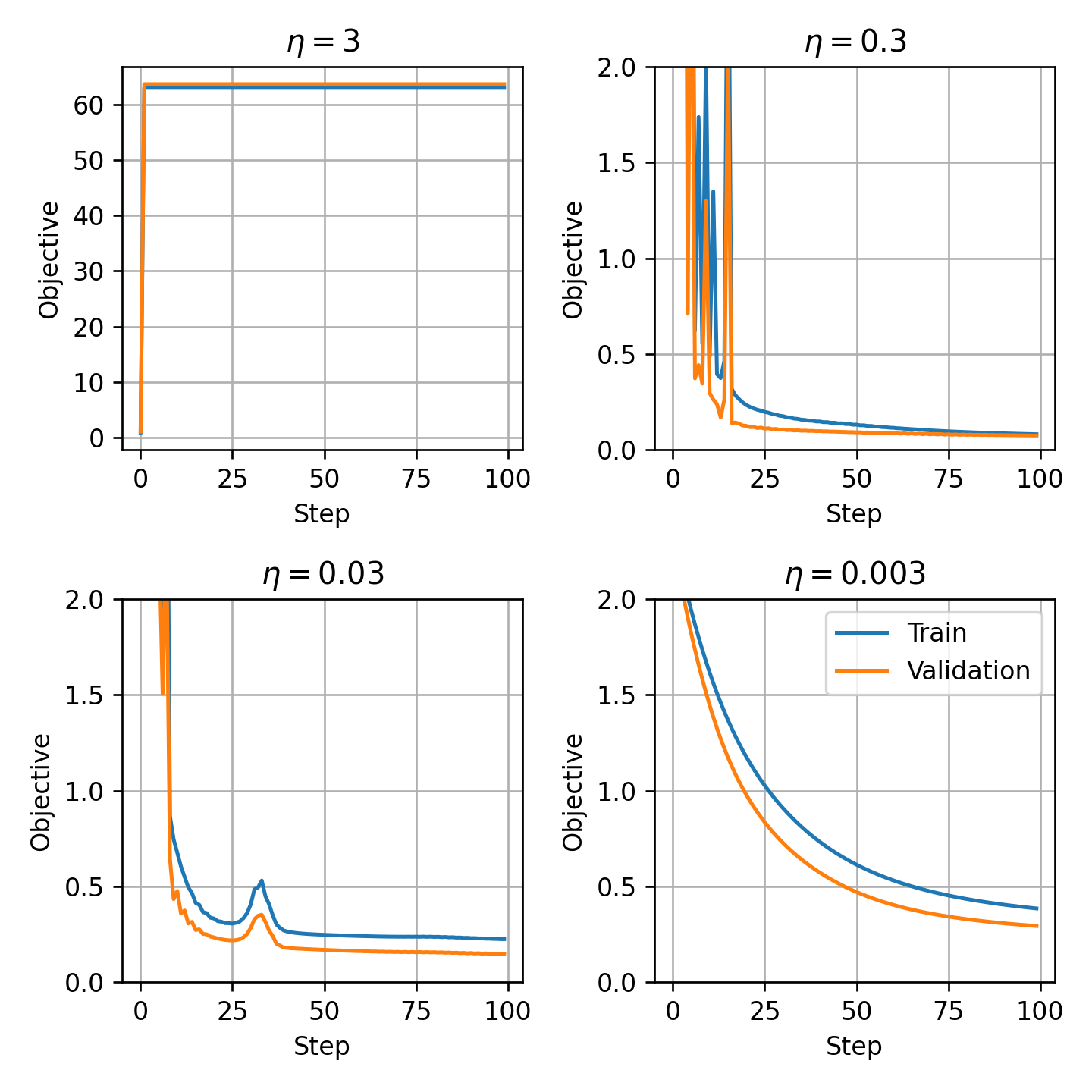

נריץ את אלגוריתם ה gradient descent למספר קטן של צעדים כדי לבחור את קצב הלימוד η

בדומה לתרגול הקודם, אנו נבחר את הערך הגדול ביותר שבו הגרף יורד בצורה מונוטונית שבמקרה זה הינו η=0.03.

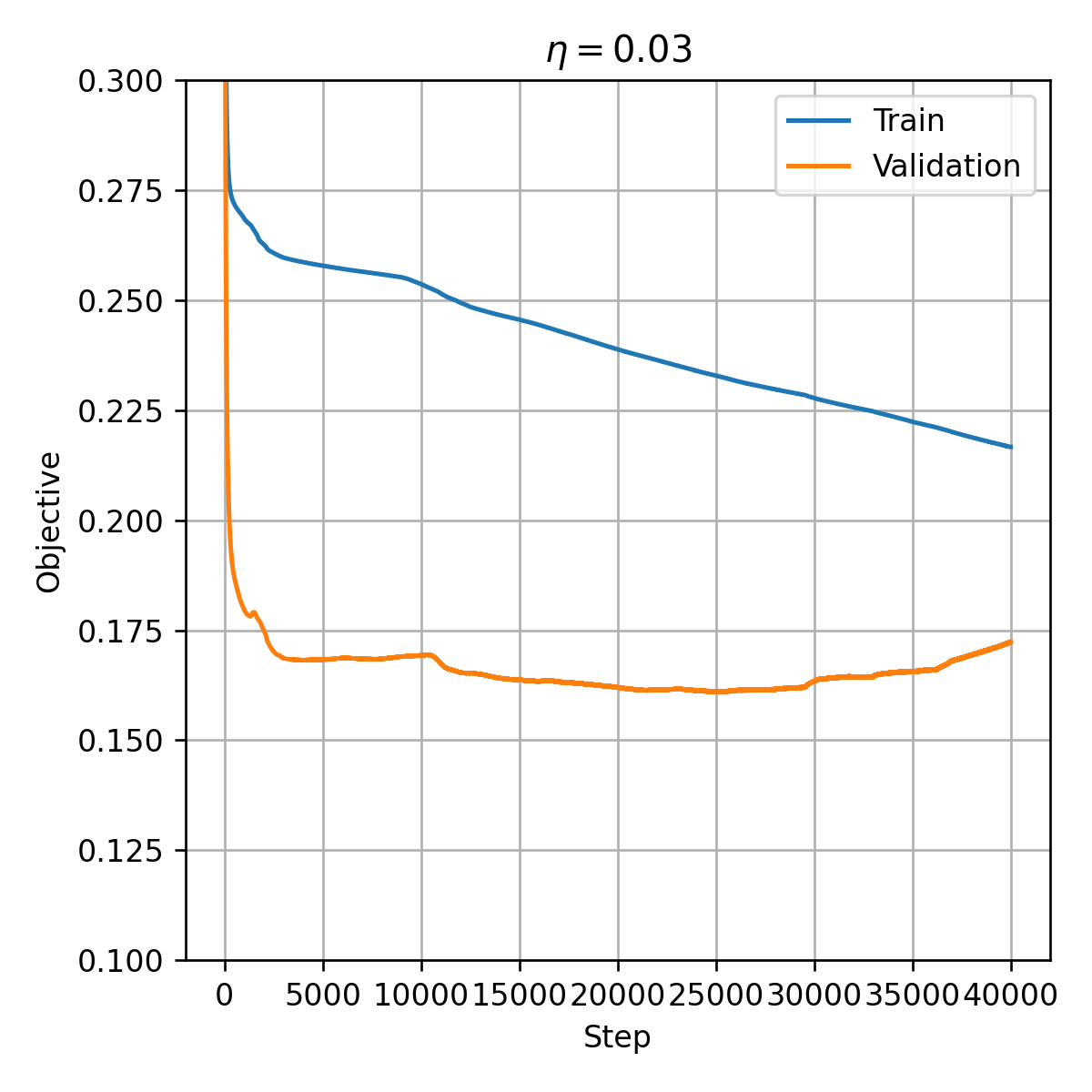

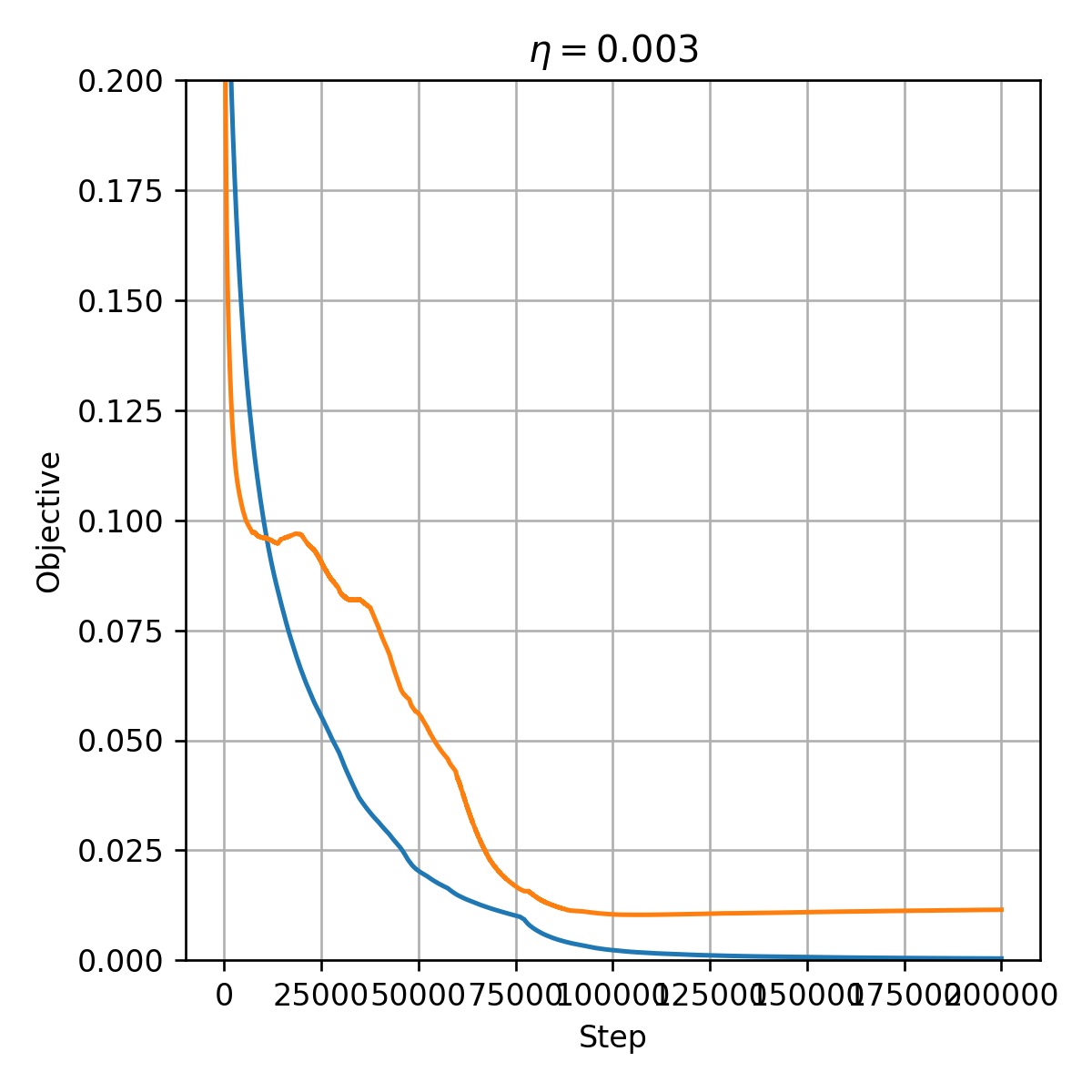

נריץ כעת האלגוריתם למספר גדול של צעדים:

- החל מנקודה מסויימת, ה- objective על ה validation set מתחיל לעלות.

- הסיבה לכך היא תופעת ה- overfitting.

- ניתן להימנע מכך על ידי עצירת האלגוריתם לפני שהוא מתכנס. פעולה זו מכונה early stopping.

- נשתמש בפרמטרים מהצעד עם הערך של ה objective הנמוך ביותר על ה validation, במקרה זה זהו הצעד ה 25236.

החזאי המתקבל ממודל זה הינו:

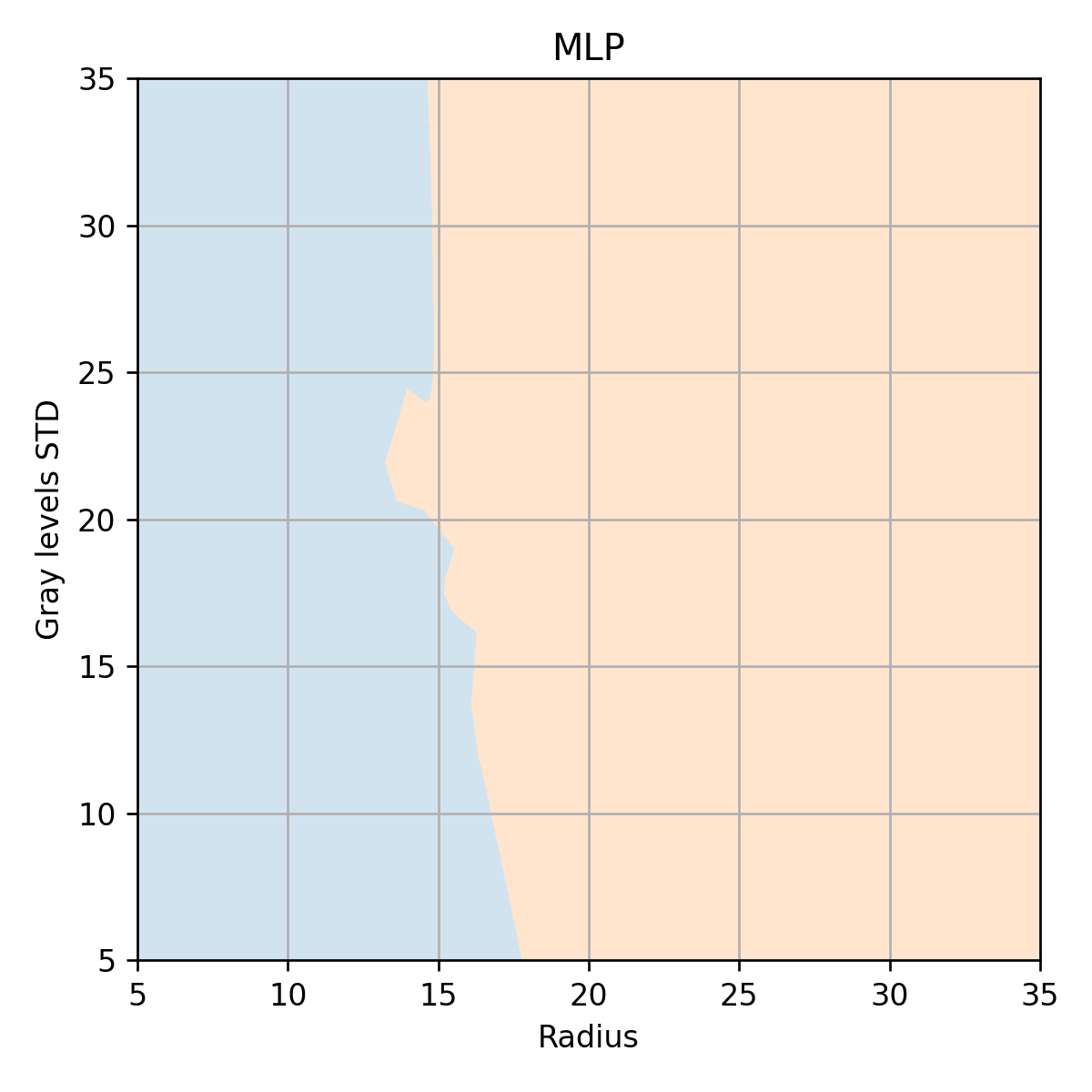

נשרטט גרף זה ללא הדגימות על מנת לראות את קו ההפרדה בין שני השטחים

- הרשת מצליחה לייצר חזאי עם קו הפרדה מורכב בהשוואה ל LDA, QDA ו- linear logistic regression.

- ביצועי חזאי זה על ה valudation set הינם: 0.08. ביצועים אלו דומים לביצועים של QDA ו linear logistic regresssion.

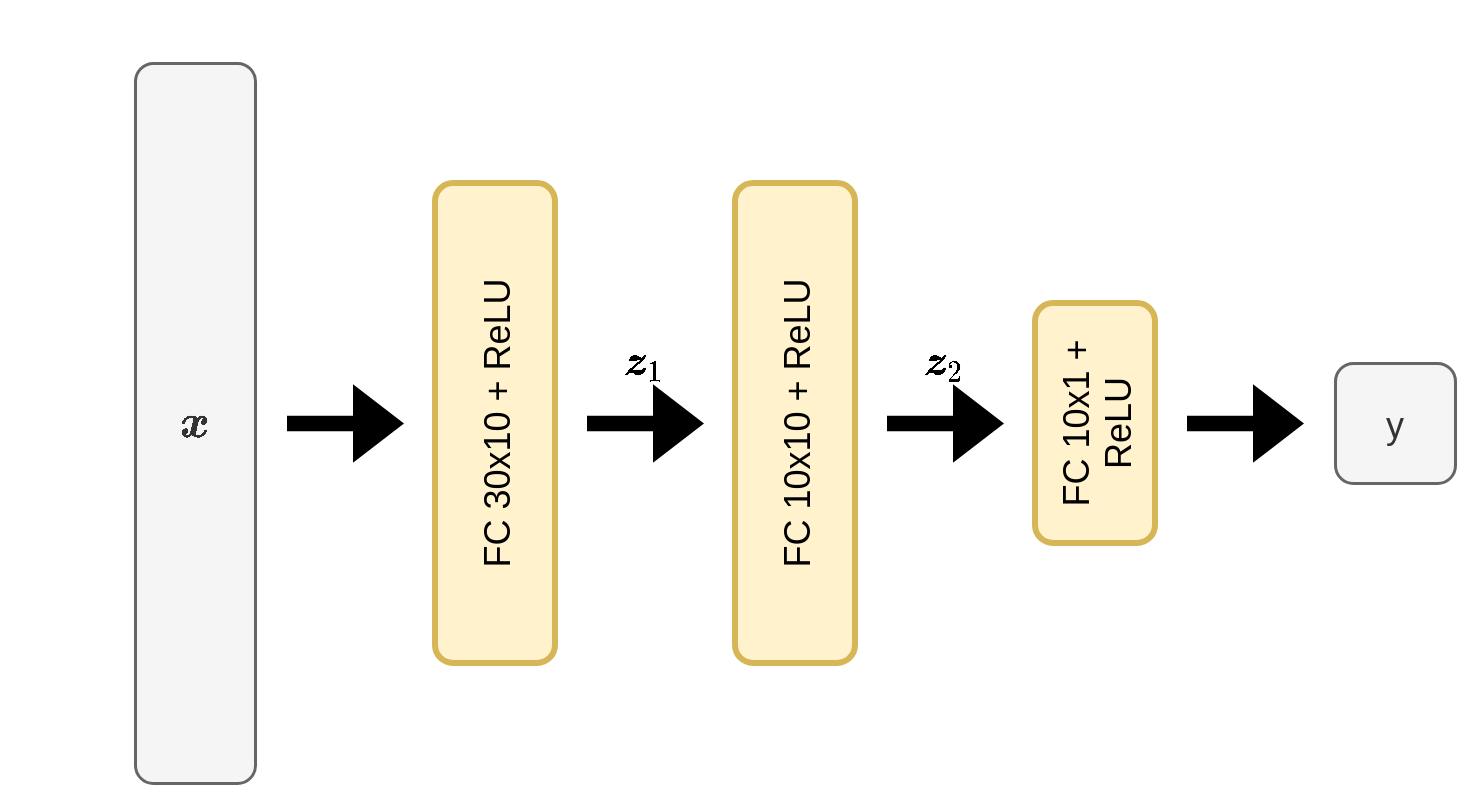

שימוש בכל 30 העמודות במדגם

נעבור כעת להשתמש בכל 30 העמודות במדגם. לשם כך נשתמש ברשת הבאה:

נחפש שוב את הערך המתאים ביותר של η:

במקרה זה נבחר את η=0.003.

האימון המלא נראה כך:

- הביצועים הטובים ביותר על ה validation set מתקבלים בצעד ה 107056.

- החזאי המתקבל בצעד זה מניב miscalssifiaction rate של 0.01 על ה validation set.

-

ביצועי המודל על ה test set הינם 0.03

- לעומת 0.04 ב linear logistic regression.