תרגול 8 - שיערוך פילוג בשיטות פרמטריות וסיווג גנרטיבי

תקציר התיאוריה

הבעיה בגישה הלא פרמטרית

-

Curse of dimensionality:

- שיטות לא פרמטריות לומדות את הפילוג בכל איזור על פי הדגימות שנמצאות באותו איזור באופן בלתי תלוי באיזורים האחרים במרחב.

- לכן, נדרש מספר רב של דוגמאות לכסות את מרחב הדגימות האפשריות.

- הגודל האפקטיבי של מרחב הדגימות גדל מעריכית עם המימד של הדגימות (האורך של הוקטור x)

-

המודלים המתקבלים אינם פונקציות שנוח לעבוד איתן.

- לדוגמא: חישוב הצפיפות בנקודה מסויימת ב- KDE נעשה באמצעות סכימה על כל הנקודות שנמצאות ב train set.

הגישה הפרמטרית

- נעשה שימוש במודלים פרמטרים בדומה לאופן שבו הדבר נעשה בגישה הדיסקרימינטיבית:

-

נחפש פילוג בתוך משפחה פרמטרית מסויימת, על ידי מציאת הפרמטרים האופטימליים.

- לרוב ננסה למדל את צפיפות הפילוג (הPDF).

-

באופן כללי ישנן 2 דרכים להתייחס לפרמטרי המודל: הגישה הבייסיאנית, והגישה התדירותית (לא בייסיאנית).

- בגישה הבייסיאנית אנו מתייחסים לפרמטרים כאל משתנים אקראיים.

- בגישה התדירותית אנו מתייחסים לפרמטרים כקבועים.

הגישה הלא-בייסיאנית (קלאסית או תדירותית (Frequintist))

- בגישה זו אנו נתייחס לפרמטרים באופן דומה לשיטות הדיסקרימינטיביות.

- תחת גישה זו אין כל העדפה של ערך מסויים של הפרמטרים על פני ערך אחר. את המודל הפרמטרי להסתברות / צפיפות הסתברות של משתנה אקראי x נסמן ב:

משערך Maximum Likelihood Estimator (MLE)

-

הדרך הנפוצה ביותר לבחור את הערך של θ תחת הגישה הלא בייסאנית היא בעזרת MLE.

- נחפש את הערך של θ אשר מסביר בצורה הכי טובה את המדגם הנתון.

- נסמן ב pD(D;θ) את ההסתברות לקבלת מדגם D={x(i)}.

- גודל זה מכונה הסבירות (likelihood) של המדגם כפונקציה של θ.

- כדי להדגיש שהמדגם הוא ״גודל״ ידוע ואילו הגודל הלא ידוע שאותו נרצה לבדוק הינו θ, מקובל לסמן את פונקציית ה likelihood באופן הבא:

- משערך ה MLE של θ הוא הערך שממקסם את ה- likelihood:

- כאשר הדגימות במדגם הן i.i.d נוכל להסיק כי:

ולכן:

θ^MLE=θargmin −L(θ;D)=θargmin −i∏px(x(i);θ)- נוכל להחליף את המכפלה על כל הדגימות בסכום (Maximum Log-Likelihood Estimator):

הגישה הבייסיאנית

- וקטור הפרמטרים θ הינו ריאליזציה של וקטור אקראי בעל פילוג כלשהוא pθ(θ).

- פילוג זה מכונה הא-פריורי (a priori distribution), הפילוג של θ לפני שראינו את המדגם.

- תחת גישה זו, המודל שלנו יהיה הפילוג של x בהינתן θ:

משערך Maximum A-posteriori Probability (MAP)

- בגישה זו נבחר את הערך של θ ע"י משערך MAP.

- בשיטה זו נחפש את הערך הכי סביר של θ בהינתן המדגם pθ∣D(θ∣D).

- פילוג זה מכונה הפילוג א-פוסטריורי (a posteriori distribution) (או הפילוג בדיעבד) - הפילוג אחרי שראינו את המדגם.

אם כן, משערך ה MAP הוא וקטור הפרמטרים אשר ממקסמים את ההסתברות ה א-פוסטריורית:

θ^MAP=θargmax pθ∣D(θ∣D)=θargmin −pθ∣D(θ∣D)על פי חוק בייס, נוכל לכתוב זאת כ:

θ^MAP=θargmin −pD(D)pD∣θ(D∣θ)pθ(θ)=θargmin −pD∣θ(D∣θ)pθ(θ)כאשר הדגימות במדגם בהינתן θ הן i.i.d מתקיים כי:

pD∣θ(D∣θ)=i∏px∣θ(x(i)∣θ)ולכן:

θ^MAP=θargmin −pθ(θ)i∏px∣θ(x(i)∣θ)גם כאן נוכל להפוך את המכפלה לסכום על ידי מזעור מינוס הלוג של הפונקציה:

θ^MAP=θargmin −log(pθ(θ))−i∑log(px∣θ(x(i)∣θ))Linear Discriminant Analysis (LDA)

LDA הינו אלגוריתם לפתרון בעיות סיווג בגישה גנרטיבית פרמטרית (לא בייסיאנית).

המודל הפרמטרי:

- את הפילוג של py(y) נשערך ישירות מתוך התווית (זה פילוג דיסקרטי).

- את הפילוג של px∣y(x∣y) נמדל כפילוג נורמאלי.

- אנו נניח כי מטריצת ה covariance של הפילוג הנורמאלי אינה תלויה בערך של y.

- נסמן את מטריצת הקווריאנס של הפילוגים הנורמאליים (אותה נרצה לשערך) ב- Σ.

-

בנוסף, בעבור כל מחלקה c של y נסמן:

- Ic={i: y(i)=c} - זאת אומרת, אוסף האינדקסים של הדגמים במדגם שמקיימים y(i)=c.

- ∣Ic∣ - מספר האינדקסים ב Ic

- μc - וקטורי התוחלת של הפילוג הנורמאלי px∣y(x∣c).

שיערוך של הפרמטריים בעזרת משערך MLE נותן את הפתרון הבא:

μc=∣Ic∣1i∈Ic∑x(i) Σ=N1i∑(x(i)−μy(i))(x(i)−μy(i))Tהפרדה לינארית

בעבור המקרה של סיווג בינארי (סיווג לשתי מחלקות) ופונקציית מחיר misclassification rate מתקבל החזאי הבא:

h(x)={1aTx+b>00otherwiseכאשר:

a=Σ−1(μ1−μ0) b=21(μ0TΣ−1μ0−μ1TΣ−1μ1)+log(py(0)py(1))- נשים לב כי תנאי ההחלטה שבין שני התחומים הינו לינארי, ומכאן מקבל האלגוריתם את שמו.

תרגיל 8.1 - שיערוך MLE

נתון מדגם D={x(i)}i=1N של דגימות בלתי תלויות של משתנה אקראי x. מצאו את משערך ה MLE של המודלים הבאים:

1) פילוג נורמלי: x∼N(μ,σ2) עם פרמטרים μ וσ2 לא ידועים.

2) פילוג אחיד: x∼U[0,θ], עם פרמטר θ לא יודע.

3) פילוג אקספוננציאלי (לקריאה עצמית): x∼exp(θ). עם פרמטר θ לא ידוע.

פיתרון 8.1

1)

המודל של פונקציית ה PDF יהיה:

p(x;θ)=2πσ21exp(−2σ21(x−μ)2)נסמן את וקטור הפרמטרים: θ=[μ,σ2]T. המשערך הינו:

נפתור על ידי גזירה והשוואה ל 0 (נסמן ב f(θ) את פונקציית המטרה אותה יש למזער):

⇔⇔{∂θ1∂f(θ)=0∂θ2∂f(θ)=0{∑i=1Nθ21(x(i)−θ1)=02θ2N−∑i=1N2θ221(x(i)−θ1)2=0{θ1=N1∑i=1Nx(i)θ2=N1∑i=1N(x(i)−θ1)2מכאן ש:

μ^MLE=θ^1=N1i=1∑Nx(i) σ2^MLE=θ^2=N1i=1∑N(x(i)−μ^MLE)22)

המודל של פונקציית ה PDF יהיה:

p(x;θ))={θ10θ≥xi≥0elseולכן:

θ^MLE=θargmax i=1∏Np(x(i);θ)={θN10θ≥x(i)∀ielseהתנאי θ≥x(i) לכל i שקול ל θ≥maxi{x(i)}. מצד אחד נרצה לקיים תנאי זה בכדי שה likelihood לא יתאפס, מצד שני נרצה ש θ יהיה כמה שיותר קטן בכדי למקסם את 1/θN. לכן,

θ^MLE=imax{x(i)}3)

המודל של פונקציית ה PDF יהיה:

p(x;θ))=θexp(−θx)משערך ה MLE נתון על ידי:

θ^MLE=θargmin −i=1∑Nlog(p(x(i);θ))=θargmin −Nlog(θ)+θi=1∑Nx(i)נפתור על ידי גזירה והשוואה ל 0 (נסמן ב f(θ) את פונקציית המטרה אותה יש למזער):

⇔⇔∂θ∂f(θ)=0−θN+i=1∑Nx(i)=0θ=N1∑i=1Nx(i)1מכאן ש:

θ^MLE=N1∑i=1Nx(i)1תרגיל 8.2 - MAP

ביום טוב, עומרי כספי קולע בהסתברות p מהקו. ביום רע, הוא קולע בהסתברות q מהקו. α מהימים הם ימים טובים עבור עומרי.

ביום מסויים זרק עומרי N זריקות וקלע m מתוכם. מאמנו של עומרי צריך לזהות האם מדובר ביום טוב או רע של השחקן (ולהשאיר אותו או להחליף אותו בהתאמה).

מהו חוק ההחלטה אשר ממקסם את סיכויי המאמן לצדוק?

- הניחו כי בהינתן המידע של האם יום מסויים הוא טוב או לא, ההסברות לקלוע זריקות שונות הינה הסתברות בלתי תלויה.

פתרון 8.2

- x(i) - משתנה אקראי בינארי של האם עומרי קלע בזריקה ה i. (0-החטיא, 1-קלע)

- y - משתנה אקראי בינארי של האם היום הינו יום טוב. (0-יום לא טוב, 1-יום טוב).

על פי הנתונים בשאלה:

px∣y(x∣0)={1−qqx=0x=1 px∣y(x∣1)={1−ppx=0x=1 py(y)={1−ααy=0y=1- בכדי למקסם את הסיכוי לחזות האם היום הוא יום טוב בהינתן המדגם נרצה למצוא איזה ערך יותר סביר בהינתן המדגם (יום טוב או רע).

- במילים אחרות אנו רוצים את ה y הכי סביר בהינתן D={x(i)}

- זוהי למעשה בעיית MAP קלאסית, כאשר y משמש למעשה כפרמטר בפילוג של x∣y.

- בכדי לשמור על אחידות עם הסימונים שהגדרנו קודם לבעיות שיערוך נסמן את y ב θ.

מכיוון ש θ יכול לקבל רק שני ערכים נוכל לבדוק את שניהם ולקבוע מי מהם סביר יותר.

בעבור θ=0 נקבל:

pθ(0)i∏px∣θ(x(i)∣0)=(1−α)qm(1−q)N−mבעבור θ=1 נקבל:

pθ(1)i∏px∣θ(x(i)∣1)=αpm(1−p)N−mלכן החיזוי האופטימאלי יהיה:

θ^={01(1−α)qm(1−q)N−m>αpm(1−p)N−motherwise=⎩⎪⎨⎪⎧01α1−α(pq)m(1−p1−q)N−m>1otherwiseתרגיל 8.3 - LDA

- בסוואנה חיים שלושה זני פילים אשר נמצאים בסכנת הכחדה. ידוע כי כל אחד משלושת הזנים ניזון מצמחיה מעט שונה, ועל מנת לשמר את אוכלוסיית הפילים מעוניינים לפזר להם אוכל ברחבי הסוואנה.

-

בכדי למקסם את האפקטיביות של פעולה זו מעוניינים לשערך בכל נקודת חלוקה מהו הזן שהכי סביר להמצא באותה נקודה על מנת להתאים את סוג המזון לזן זה.

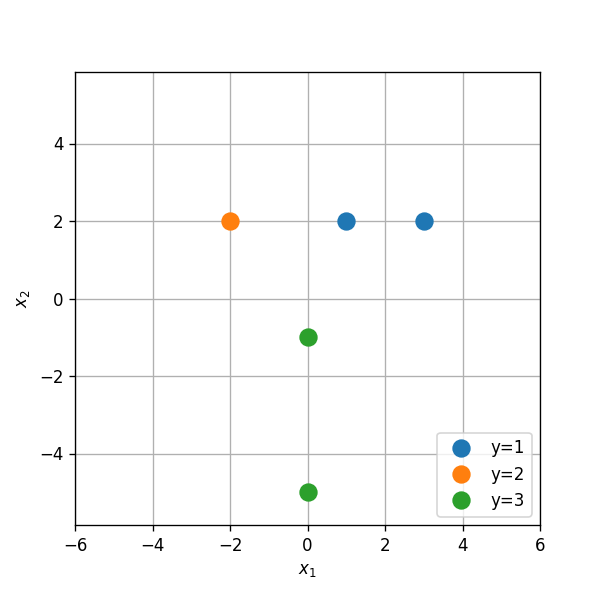

- הפילוג של זני הפילים על פני הסוואנה אינו ידוע אך נתונות לנו התצפית הבאה של הקואורדינטות בהן נצפו הפילים:

| Type | x1 | x2 |

|---|---|---|

| 1 | 1 | 2 |

| 1 | 3 | 2 |

| 2 | -2 | 2 |

| 3 | 0 | -1 |

| 3 | 0 | -5 |

השתמשו במסווג LDA על מנת לבנות חזאי אשר ישערך את הזן הנפוץ ביותר בכל קואורדינטה.

פתרון 8.3

נחשב את הפרמטרים של המודל הפרמטרי של LDA.

נסמן ב Ic את אוסף כל התצפיות שבהם הזן הוא c:

I1={1,2} I2={3} I3={4,5}נשערך את py(y):

py(y)=⎩⎪⎪⎨⎪⎪⎧N∣I1∣=52N∣I2∣=51N∣I3∣=52123נחשב את התוחלות של כל אחת משלושת הפילוגים px∣y(x∣c):

μ1=∣I1∣1i∈I1∑x(i)=21((12)+(32))=(22) μ2=∣I2∣1i∈I2∑x(i)=(−22) μ3=∣I3∣1i∈I3∑x(i)=21((0−1)+(0−5))=(0−3)נחשב את מטריצת covariance המשותפת של הפילוגים:

Σ=N1i∑(x(i)−μy(i))(x(i)−μy(i))Tדרך נוחה לחשב את הסכום בביטוי זה הינה באופן הבא: נגדיר את המטריצה של התצפיות לאחר חיסור של התוחלת המתאימה לכל זן:

X~=⎝⎜⎜⎜⎜⎜⎛−x1−−x2−−x3−−x4−−x5−⎠⎟⎟⎟⎟⎟⎞−⎝⎜⎜⎜⎜⎜⎛−μy1−−μy2−−μy3−−μy4−−μy5−⎠⎟⎟⎟⎟⎟⎞=⎝⎜⎜⎜⎜⎜⎛13−200222−1−5⎠⎟⎟⎟⎟⎟⎞−⎝⎜⎜⎜⎜⎜⎛22−200222−3−3⎠⎟⎟⎟⎟⎟⎞=⎝⎜⎜⎜⎜⎜⎛−110000002−2⎠⎟⎟⎟⎟⎟⎞ניתן להראות כי ניתן לכתוב את הסכום בביטוי ל Σ באופן הבא:

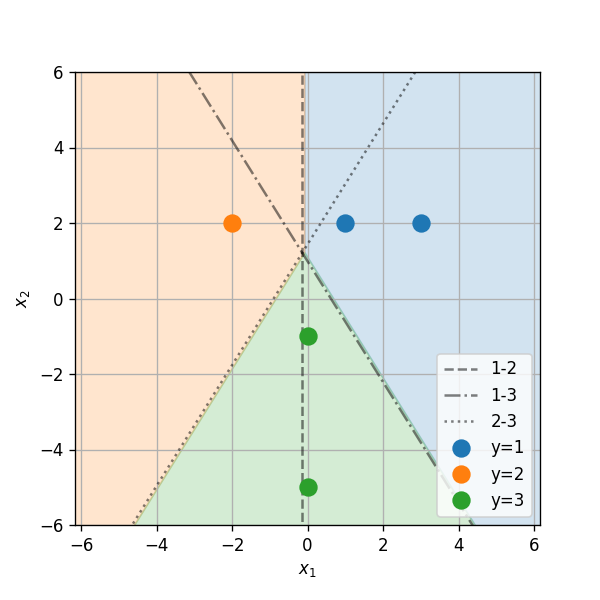

Σ=N1i∑(x(i)−μy(i))(x(i)−μy(i))T=N1X~TX~=51(−101000020−2)⎝⎜⎜⎜⎜⎜⎛−110000002−2⎠⎟⎟⎟⎟⎟⎞=51(2008)- נשתמש כעת בפילוגים שאותם שיערכנו על מנת לבנות את החזאי.

- האיזור שבו זן 1 הינו הזן הסביר ביותר הינו האיזור שבו מתקיים:

נחשב את התנאי הראשון

py∣x(1∣x)⇔px∣y(x∣1)py(1)⇔4π2∣Σ∣1e−21(x−μ1)TΣ−1(x−μ1)py(1)⇔−21(x−μ1)TΣ−1(x−μ1)+log(py(1))⇔xTΣ−1(μ1−μ2)+21(μ2TΣ−1μ2>py∣x(2∣x)>px∣y(x∣2)py(2)>4π2∣Σ∣1e−21(x−μ2)TΣ−1(x−μ2)py(2)>−21(x−μ2)TΣ−1(x−μ2)+log(py(2))−μ1TΣ−1μ1)+log(py(2)py(1))>0זוהי למעשה הפרדה לשני תחומים על ידי הקו הבא:

aTx+b=0כאשר:

a=Σ−1(μ1−μ2)=(100)b=21(μ2TΣ−1μ2−μ1TΣ−1μ1)+log(py(2)py(1))=log(2)- זוהי כמובן התוצאה עבור מסווג LDA בינארי בין שני הזנים של y=1 ו y=2.

- מכאן שהקו המפריד בין זן 1 ל זן 2 נתון על ידי:

- באופן דומה ניתן לחשב גם את שני קווי ההפרדה האחרים (בין 1 ל 3 ובין 2 ל 3):

תרגיל מעשי - שיערוך הפילוג של זמני נסיעה בניו יורק

נחזור לבעיה מהתרגול הקודם של שיערוך הפילוג של זמן הנסיעה של מונית מתוך המדגם הבא:

| passenger count | trip distance | payment type | fare amount | tip amount | pickup easting | pickup northing | dropoff easting | dropoff northing | duration | day of week | day of month | time of day | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 2 | 2.76806 | 2 | 9.5 | 0 | 586.997 | 4512.98 | 588.155 | 4515.18 | 11.5167 | 3 | 13 | 12.8019 |

| 1 | 1 | 3.21868 | 2 | 10 | 0 | 587.152 | 4512.92 | 584.85 | 4512.63 | 12.6667 | 6 | 16 | 20.9614 |

| 2 | 1 | 2.57494 | 1 | 7 | 2.49 | 587.005 | 4513.36 | 585.434 | 4513.17 | 5.51667 | 0 | 31 | 20.4128 |

| 3 | 1 | 0.965604 | 1 | 7.5 | 1.65 | 586.649 | 4511.73 | 586.672 | 4512.55 | 9.88333 | 1 | 25 | 13.0314 |

| 4 | 1 | 2.46229 | 1 | 7.5 | 1.66 | 586.967 | 4511.89 | 585.262 | 4511.76 | 8.68333 | 2 | 5 | 7.70333 |

| 5 | 5 | 1.56106 | 1 | 7.5 | 2.2 | 585.926 | 4512.88 | 585.169 | 4511.54 | 9.43333 | 3 | 20 | 20.6672 |

| 6 | 1 | 2.57494 | 1 | 8 | 1 | 586.731 | 4515.08 | 588.71 | 4514.21 | 7.95 | 5 | 8 | 23.8419 |

| 7 | 1 | 0.80467 | 2 | 5 | 0 | 585.345 | 4509.71 | 585.844 | 4509.55 | 4.95 | 5 | 29 | 15.8314 |

| 8 | 1 | 3.6532 | 1 | 10 | 1.1 | 585.422 | 4509.48 | 583.671 | 4507.74 | 11.0667 | 5 | 8 | 2.09833 |

| 9 | 6 | 1.62543 | 1 | 5.5 | 1.36 | 587.875 | 4514.93 | 587.701 | 4513.71 | 4.21667 | 3 | 13 | 21.7831 |

ננסה להתאים מודל פרמטרי בעזרת שיערוך MLE.

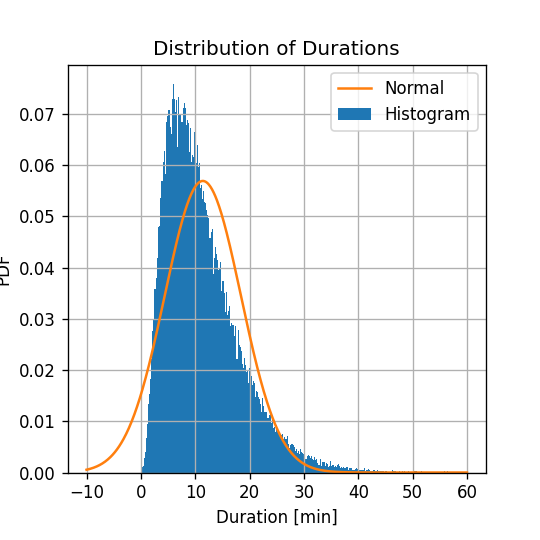

ניסיון 1: פילוג גאוסי

- נשתמש במודל של פילוג נורמלי לתיאור הפילוג של משך הנסיעה. למודל זה שני פרמטרים, התוחלת μ והשונות σ .

סימונים והנחות:

- N - מספר הדגמים במדגם.

- θ=[μ,σ]T - וקטור הפרמטרים של המודל

- pnormal(x(i);θ)=2πσ21exp(−2σ2(x(i)−μ)2),i=1,...,N - המודל

ראינו כי בעבור המודל הנורמלי, ניתן למצוא את הפרמטרים של משערך הMLE באופן מפורש (אנליטית), והפתרון נתון על ידי:

μ=N1i∑x(i)σ=N1i∑(x(i)−μ)2בעבור המדגם הנתון נקבל:

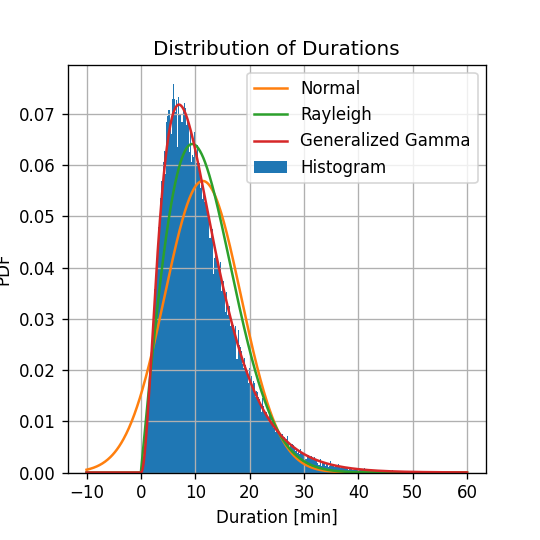

μ^=11.4 min σ^=7.0 minההיסטוגרמה של של משכי הנסיעה יחד עם הפילוג המשוערך:

- הפילוג הנורמלי נותן קירוב מאד גס לפילוג האמיתי.

- עובדה אחת שמאד מטרידה לגבי הפילוג שקיבלנו הינה שישנו סיכוי לא אפסי לקבל נסיעות עם משך נסיעה שלילי.

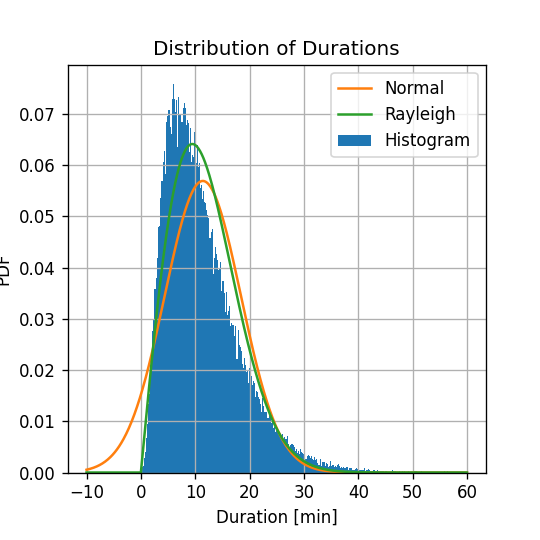

נסיון 2: פילוג Rayleigh

- פילוג Rayleigh מתאר את הפילוג של האורך האוקלידי (l2 norm) של וקטור גאוסי דו מימדי עם תוחלת 0 וחוסר קורלציה ופילוג זהה לשני רכיבי הוקטור.

- במלים אחרות, עבור וקטור בעל הפילוג הבא:

- פילוג Rayleigh מתאר את הגודל ∥Z∥2=Zx2+Zy2.

פונקציית צפיפות ההסתברות של פילוג Reyleigh נתונה על ידי:

pRayleigh(z;σ)=σ2zexp(−2σ2z2),z≥0פונקציית צפיפות ההסתברות של פילוג Reyligh נתונה על ידי:

pRayleigh(z;σ)=σ2zexp(−2σ2z2),z≥0- שימו לב: הפילוג מוגדר רק בעבור ערכים חיוביים.

- לפילוג זה פרמטר יחיד σ שנקרא פרמטר סקאלה (scale parameter). בניגוד לפילוג הנורמלי, פה σ אינה שווה לסטיית התקן של הפילוג.

מוטיבציה לשימוש בפילוג Rayleigh

- נניח שוקטור המחבר את נקודת תחילת הנסיעה עם נקודת סיום הנסיעה הינו וקטור דו מימדי אשר מפולג נרמלית, ולשם הפשטות נניח כי רכיביו מפולגים עם פילוג זהה וחסר קורלציה.

- נניח כי המונית נוסעת בקירוב בקו ישר בין נקודת ההתחלה והסיום. לכן, המרחק אותו נוסעת המכונית יהיה מפולג על פי פילוג Reyleigh.

- נניח בנוסף כי מהירות הנסיעה קבועה ולכן משך הנסיעה פורפורציוני למרחק ולכן גם הוא יהיה מפולג על פי פילוג Reyleigh.

חישוב

לשם השלמות נסמן את וקטור הפרמטרים ב: θ=[σ]

במקרה זה המודל נתון על ידי:

prayleigh(x;θ)=i=1∏Nθ2x(i)exp(−2θ2(x(i))2)ופונקציית ה log likelihood תהיה:

lrayleigh(θ)=i∑log(prayleigh(x(i);θ))=i∑log(x(i))−2Nlog(θ)−2θ21i∑(x(i))2בעיית האופטימיזציה הינה:

θ^=θargmin−i∑log(x(i))+2Nlog(θ)+2θ21i∑(x(i))2גם בעבור המקרה הזה נוכל לפתור את בעיית האופטימיזציה באופן אנליטי על ידי גזירה והשוואה לאפס:

⇔⇔∂θ∂lrayleigh(θ)=0−θ2N+θ3∑i(x(i))2=0σ^=θ=2N1i∑(x(i))2בעבור המדגם הנתון נקבל:

σ^=9.5נוסיף את השיערוך החדש שקיבלנו לגרף ממקודם:

- המודל של פילוג Rayleigh טוב יותר מהמודל הנורמלי.

- אין הסתברות שונה מ0 לקבל משך נסיעה שלילי.

נסיון 3: Generalized Gamma Distribution

- פילוג Rayleigh הינו מקרה פרטי של משפחה כללית יותר של פונקציות פילוג המכונה Generalized Gamma Distribution.

- פונקציית צפיפות ההסתברות של משפחה זו נתונה על ידי:

- כש- Γ היא פונקציה המוכנה פונקציית גמא (gamma function)

- למודל זה 3 פרמטרים: θ=[σ,a,c]T.

- בעבור c=2 ו a=1 נקבל את פילוג Rayleigh כאשר σgamma=2σrayleigh .

- בשונה מהמקרים של פילוג נורמלי ופילוג Rayleigh, לא נוכל למצוא בקלות את הפרמטרים האופטימאלים של המשערך באופן אנליטי.

- לכן, לשם מציאת הפרמטרים נאלץ להעזר בפתרון נומרי.

- נעשה שימוש באחת החבילה של Python הנקראת SciPy. חבילה זו מכילה מודלים הסברותיים רבים ומכילה מספר רב של כלים הקשורים למודלים אלו, כגון מציאת הפרמטרים האופטימאלים בשיטת MLE על סמך מדגם נתון. את הפונקציות הקשורות למודל הGeneralized Gamma Distribution ניתן למצוא כאן. אתם תעשו שימוש בפונקציות אלו בתרגיל הבית הרטוב.

- שימוש בפונקציה הנ"ל, מניב את התוצאות הבאות:

נוסיף את השיערוך החדש שקיבלנו לגרף הקודם:

- המודל של Generalized Gamma Distribution אכן מניב תוצאה אשר דומה מאד לצורת ההיסטוגרמה.