תרגול 6 - SVM ופונקציות גרעין (Kernels)

תקציר התיאוריה

הערה: בפרק זה נעסוק בסיווג בינארי ונסמן את התוויות של שתי המחלקות ב 1 ו −1.

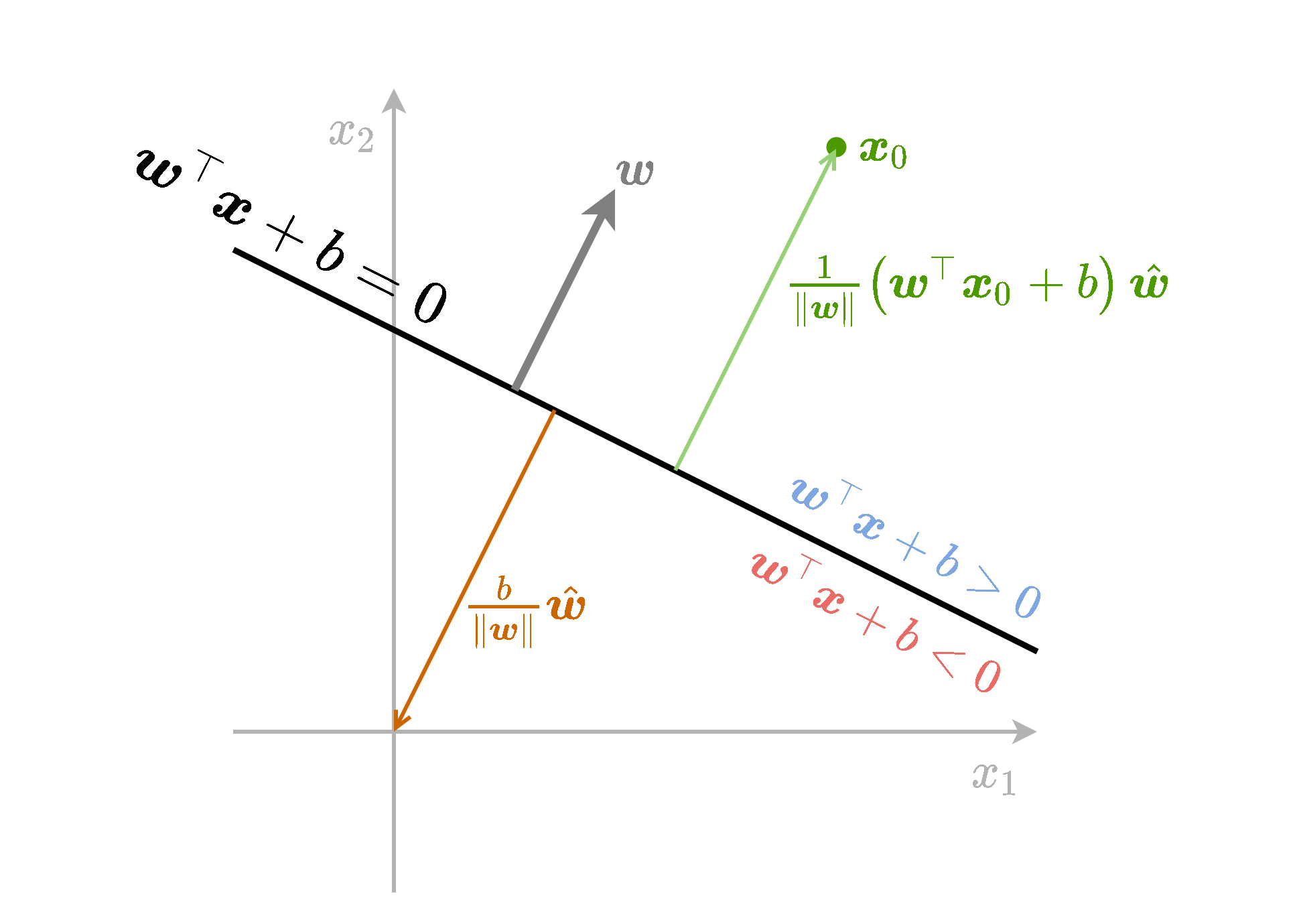

תזכורת - גאומטריה של המישור

- מישור מתואר באופן הבא w⊤x+b=0.

- המישור מחלק את המרחב ומגדיר צד חיובי וצד שלילי.

- w הינו הנורמל למישור.

- המרחק של המישור מהראשית הינו ∥w∥b.

- המרחק של נקודה x0 מהמישור הינה ∥w∥1(w⊤x0+b).

- w ו b מוגדרים עד כדי קבוע.

מסווג לינארי

מסווג לינארי הוא מסווג מהצורה של

h(x)=sign(w⊤x+b)={1−1w⊤x+b>0elseעם w ו- b כל שהם.

-

המסווג מחלק את המרחב לשני צידיו של המישור:

- w⊤x+b=0

- מישור זה מכונה מישור ההפרדה.

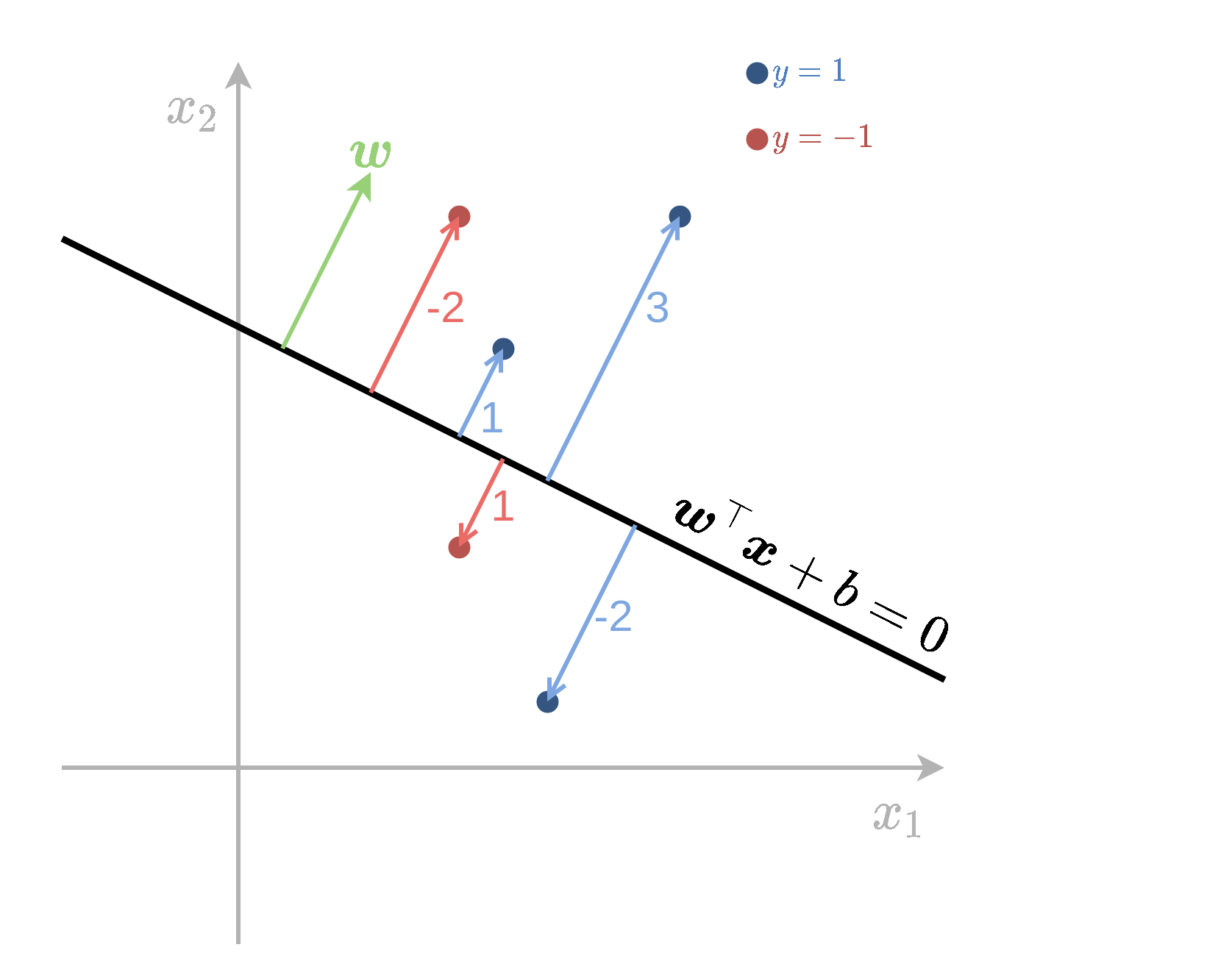

Signed distance (מרחק מסומן)

נסתכל על בעיית סיווג בינארית עם תוויות y=±1.

- נגדיר את ה- signed distance של דגימה כל שהיא ממשטח ההפרדה באופן הבא:

- זהו המרחק של נקודה מהמישור.

- כאשר y תואם למיקום הנקודה x ביחס למישור, הערך חיובי.

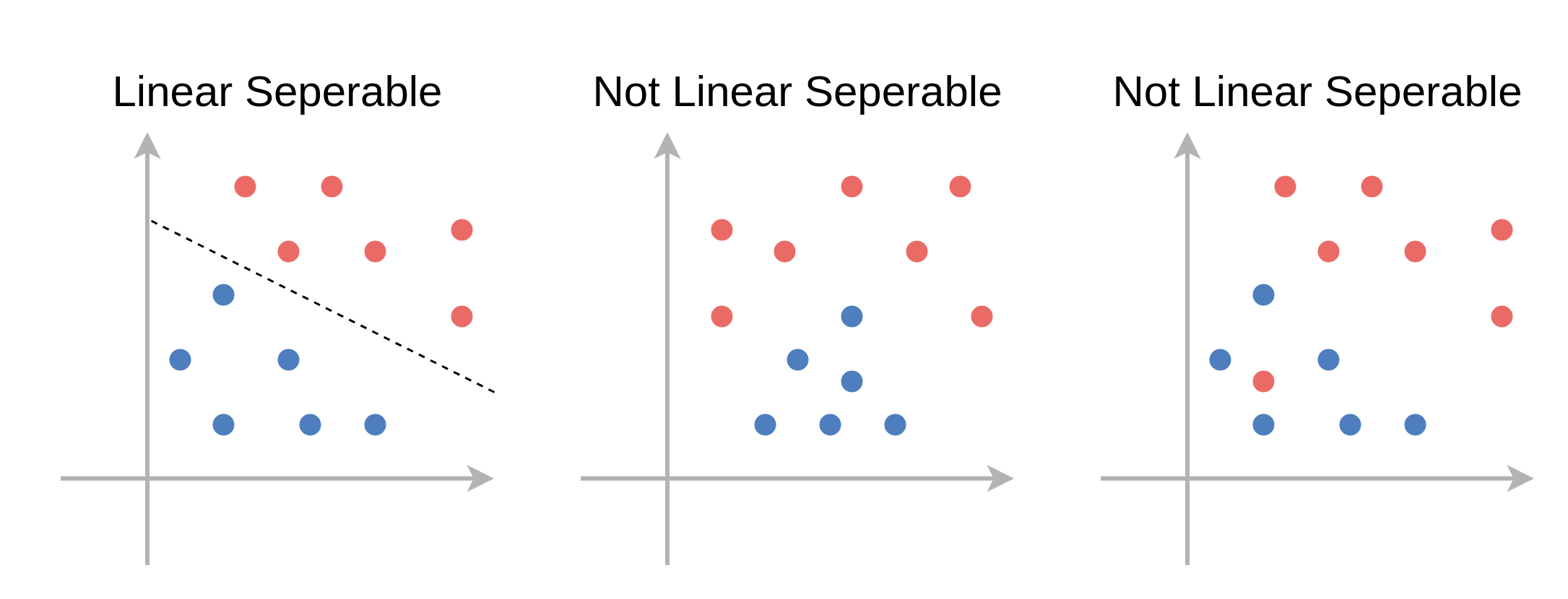

פרידות לינארית (linear separability)

- בבעיות סיווג בינארי, נאמר על המדגם שהוא פריד לינארית אם קיים מסווג לינארי אשר מסווג את המדגם בצורה מושלמת (בלי טעויות סיווג).

- כאשר המדגם פריד לינארית יהיו יותר ממסווג לינארי אחד אשר יכול לסווג בצורה מושלמת את המדגם.

Support Vector Machine (SVM)

- אלגוריתם דיסקרימינטיבי לסיווג בינארי אשר מחפש מסווג לינארי אשר יסווג בצורה טובה את המדגם.

- אלגוריתם זה יבחר את המסווג בעל השוליים המירביות מכל המסווגים שמצליחים לסווג את המדגם.

Hard SVM

- ניתן לשימוש אך ורק כאשר המדגם פריד לינארית.

- נחפש את המסווג הלינארי אשר בעבורו ה signed distance המינימאלי על ה train set הוא המקסימאלי:

- בעיה זו שקולה לבעיית האופטימיזציה הבאה:

בעיית אופטימיזציה זו מכונה הבעיה הפרימאלית.

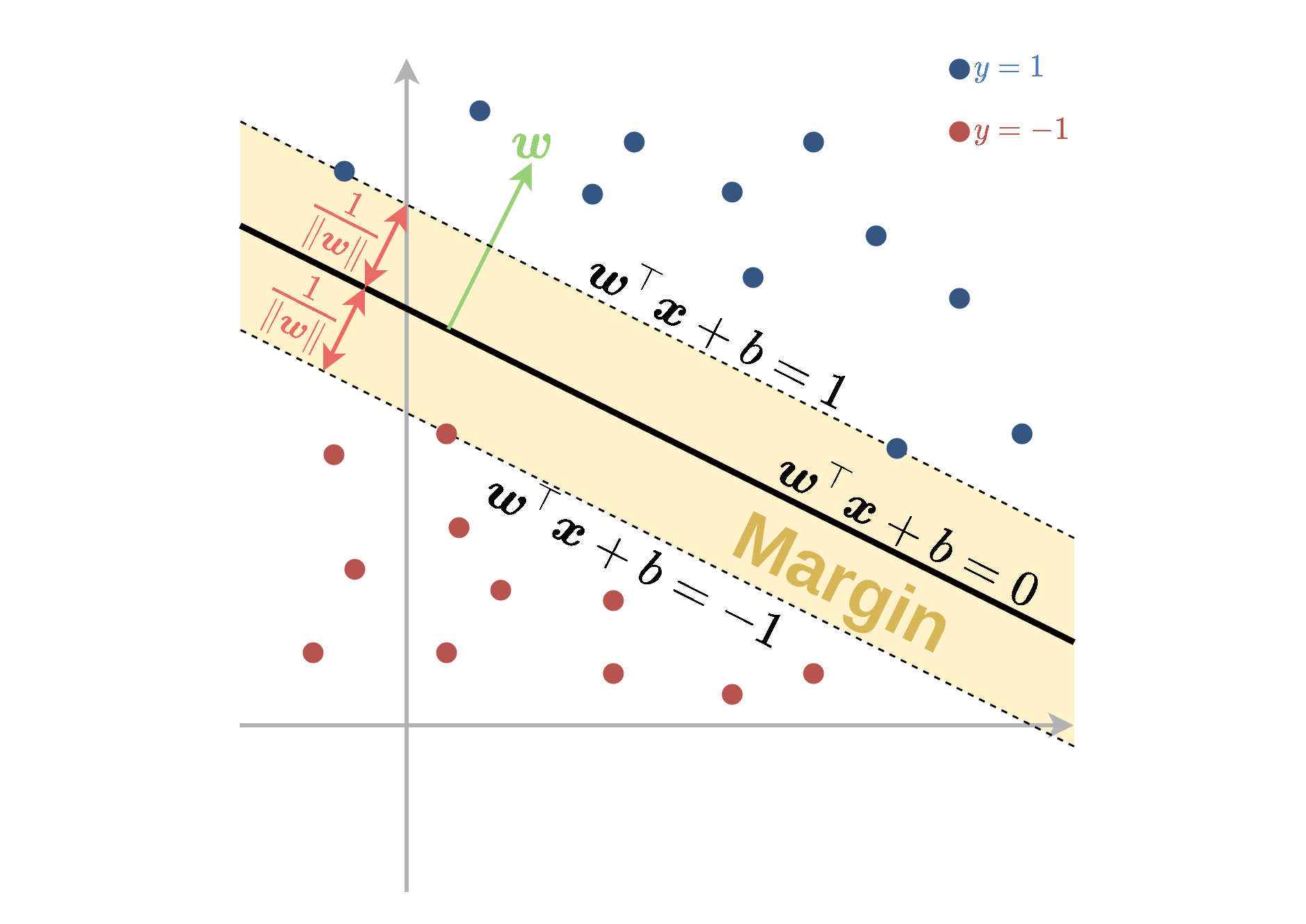

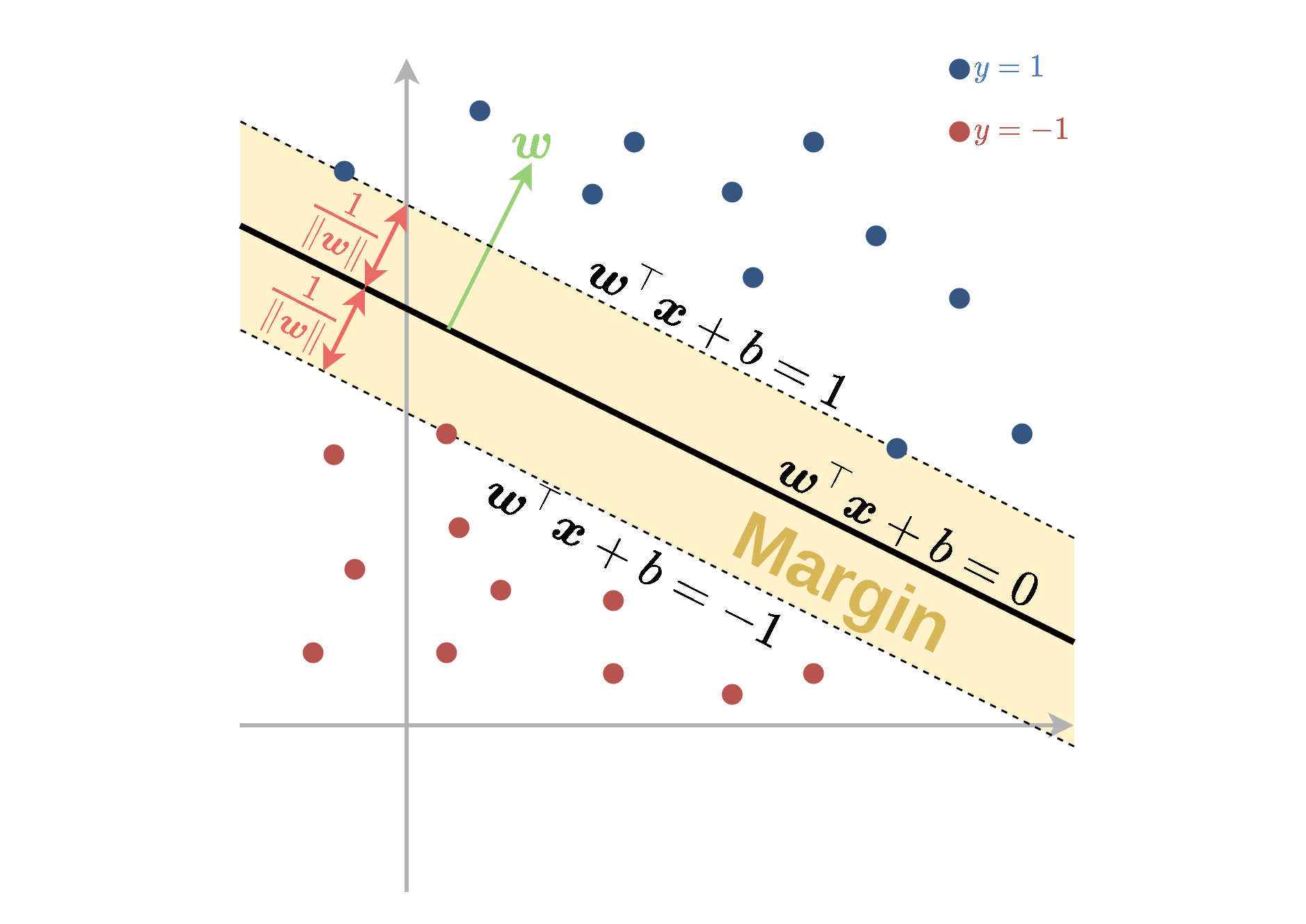

Margin - שוליים

- בכדי להבין את המשמעות של בעיית האופטימיזציה שקיבלנו נגדיר את המושג שוליים (margin) של המסווג.

- האיזור של ה margin מוגדר כאיזור סביב משטח ההפרדה אשר נמצא בתחום:

- רוחב איזור זה נקבע על פי הגודל של הוקטור w ושווה ל ∥w∥2.

- האילוץ y(i)(w⊤x(i)+b)≥1, אשר מופיע בבעיית האופטימיזציה הפרימאלית, דורש למעשה שכל הנקודות יסווגו נכונה וימצאו מחוץ ל margin.

- בעיית האופטימיזציה מחפשת את הפרמטרים של המישור בעל ה margin הגדול ביותר אשר מקיים תנאי זה.

Support Vectors

- ה- support vectors מוגדרים כנקודות אשר יושבות על השפה של ה margin, עבור פתרון של בעיית האופטימיזציה.

- נקודות אלו מקיימות y(i)(w⊤x(i)+b)=1.

- אלו הנקודות אשר ישפיעו על הפתרון של בעיית האופטימיזציה.

- לכן, הסרה או הזזה קטנה של נקודות שאינן support vectors לא תשנה את הפתרון.

הבעיה הדואלית

- דרך שקולה לרישום בעיית האופטימיזציה הינה על ידי הגדרת N משתני עזר נוספים {αi}i=1N.

- בעזרת משתנים אלו ניתן לרשום את בעיית האופטימיזציה באופן הבא:

מתוך המשתנים {αi}i=1N ניתן לשחזר את w אופן הבא:

w=i∑αiy(i)x(i)קשר בין הבעיה הדואלית והפרימאלית:

| . | . | . |

|---|---|---|

| נקודות רחוקות מה margin | y(i)(w⊤x(i)+b)>1 | αi=0 |

| נקודות על ה margin (שהם support vectors) | y(i)(w⊤x(i)+b)=1 | αi≥0 |

- אם αi>0 אז y(i)(w⊤x(i)+b)=1 (אבל לא להיפך)

- אם y(i)(w⊤x(i)+b)>1 אז αi=0 (אבל לא להיפך)

- את b נחשב על ידי בחירת SV ונחלץ אותו מתוך y(i)(w⊤x(i)+b)=1.

Soft SVM

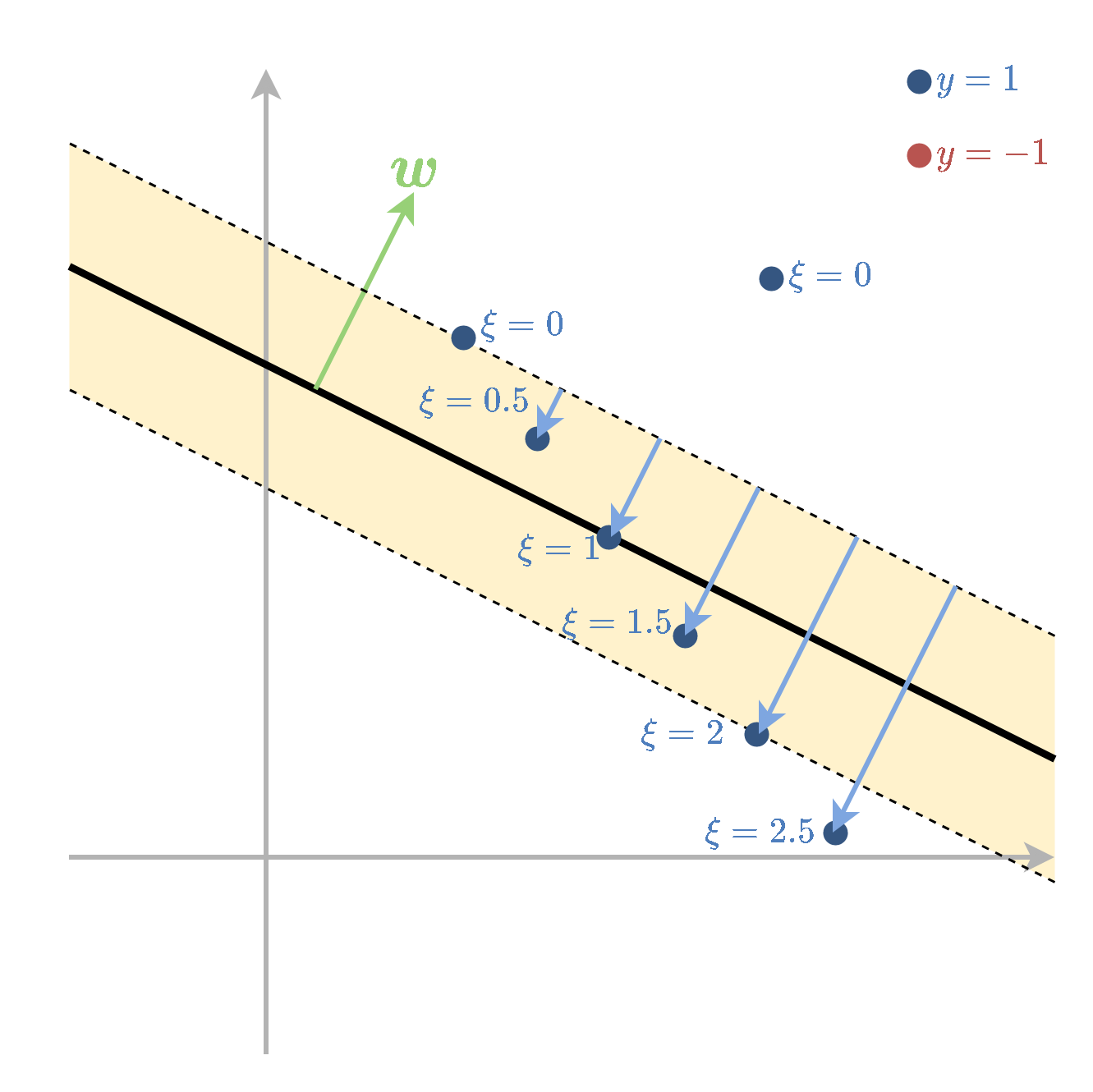

- Soft SVM מתייחס למקרה שבו המדגם אינו פריד לינארית.

- במקרה זה עדיין מגדירים את ה margin בצורה דומה אך מאפשרים למשתנים להיכנס לתוך ה margin ואף לחצות אותה לצד הלא נכון של מישור ההפרדה.

- על כל חריגה כזו משלמים קנס ב objective שאותו מנסים למזער.

- את החריגה של הדגימה ה i נסמן ב ∥w∥1ξi. לנקודות שהן בצד הנכון של המישור ומחוץ ל margin יהיה ξi=0

- המשתנים ξi נקראים slack variables.

- בעיית האופטימיזציה הפרימאלית תהיה:

- C הוא hyper-parameter שקובע את גודל הקנס על חריגה.

- הבעיה הדואלית הינה:

- ה support vectors מוגדרים להיות הנקודות שמקיימות y(i)(w⊤x(i)+b)=1−ξi

תכונות:

| . | . | . |

|---|---|---|

| נקודות שמסווגות נכון ורחוקות מה margin | y(i)(w⊤x(i)+b)>1 | αi=0 |

| נקודות על ה margin (שהם support vectors) | y(i)(w⊤x(i)+b)=1 | 0≤αi≤C |

| נקודות שחורגות מה margin (גם support vectors) | y(i)(w⊤x(i)+b)=1−ξi | αi=C |

פונקציות גרעין

מאפיינים: תזכורת

- נוכל תמיד לחליף את וקטור המשתנים x שעליו פועל האלגוריתם בוקטור חדש xnew=Φ(x).

- Φ היא פונקציה אשר נבחרה מראש ונקראת פונקציית המאפיינים.

פונקציות גרעין

- החישוב של Φ(x) יכול להיות יקר.

-

לעיתים, קיימת דרך לחשב בצורה יעילה את הפונקציה K(x1,x2)=Φ(x1)⊤Φ(x2) אשר נקראת פונקציית גרעין

- ישנם אפילו מקרים שבהם וקטור המאפיינים אינסופי!

- ישנם קריטריונים תחתם פונקציה מסויימת K(x1,x2) היא פונקציית גרעין בעבור וקטור מאפיינים מסויים. בקורס לא נכנס לכך.

נציג שתי פונקציות גרעין נפוצות:

- גרעין גאוסי:

- K(x1,x2)=exp(−2σ2∥x1−x2∥22)

- כאשר σ פרמטר שיש לקבוע.

-

גרעין פולינומיאלי: K(x1,x2)=(1+x1⊤x2)p

- כאשר p≥1 פרמטר שיש לקבוע.

פונקציית המאפיינים שמתאימות לגרעינים אלו מסורבלות לכתיבה ולא נציג אותן כאן.

Kernel Trick in SVM

- טריק זה מאפשר להשתמש ב SVM עם מאפיינים מבלי לחשב את Φ באופן ישיר באמצעות פונקציית גרעין.

- עבור פונקציית מאפיינים Φ עם פונקציית גרעין K הבעיה הדואלית של SVM הינה:

- בעיית זו מגדירה את המשתנים {αi} בלי צורך לחשב את Φ באופן מפורש בשום שלב.

Kernel Trick in SVM

- הפרמטר w נתון על ידי:

- כדי לחשב את w באופן מפורש יש לחשב את Φ.

- עם זאת, ניתן להמנע מכך

Kernel Trick in SVM

- נציב את הנוסחא של w ישירות למסווג ובכך נוכל להינמע מלחשב את Φ:

- כך בעצם נוכל להשתמש במסווג מבלי לחשב את Φ מפורשות

תרגיל 6.1 - 2 Support Vectors

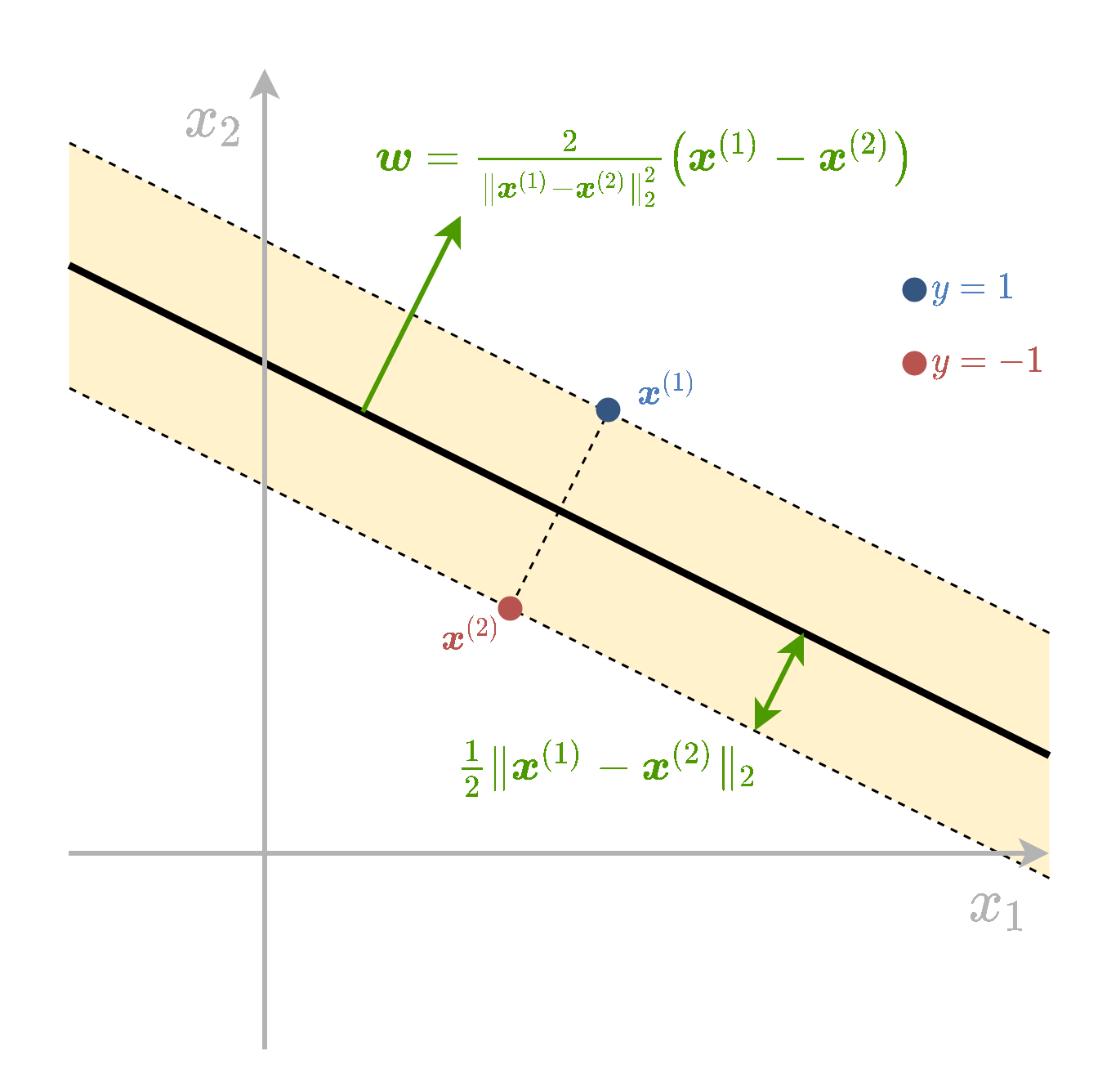

בשאלה זו נראה שבעבור מדגם המכיל 2 נקודות, אחת מכל מחלקה, הפתרון של בעיית hard SVM יהיה מישור הפרדה שיעבור בדיוק במרכז בין 2 הנקודות, ויהיה ניצב לוקטור המחבר את הנקודות

w=∥x(1)−x(2)∥222(x(1)−x(2)),b=−21(x(1)+x(2))⊤w

1) הראו זאת על ידי פתרון הבעיה הדואלית.

פתרון:

הבעיה הדואלית הינה:

{αi}∗={αi}argmaxs.t.i∑αi−21i,j∑y(i)y(j)αiαjx(i)⊤x(j)αi≥0∀ii∑αiy(i)=0- נניח בלי הגבלת הכלליות ש y(1)=1 ו y(2)=−1.

נסתכל על האילוץ בשורה האחרונה:

i=1∑2αiy(i)=0⇔α1−α2=0⇔α1=α2=α- מכאן שהמשתנה היחד בבעיה הינו α.

- בעיית האופטימיזציה (ללא האילוצים) תהיה:

ניתן לפתור את הבעיה על ידי גזירה והשוואה ל0:

⇔⇔dαd2α−2α2∥x(1)−x(2)∥22=02=α∥x(1)−x(2)∥22α=∥x(1)−x(2)∥222את w נמצא על ידי:

w=i∑αiy(i)x(i)=α(x(1)−x(2))=∥x(1)−x(2)∥222(x(1)−x(2))את b מוצאים על ידי בחירת support vector אחד מתוך המשוואה y(i)(w⊤x(i)+b)=1.

- נסתכל על הנקודה הראשונה:

2) הראו זאת על ידי פתרון הבעיה הפרימאלית.

הבעיה הפרימלית הינה:

w∗,b∗=w,bargmins.t.21∥w∥2y(i)(w⊤x(i)+b)≥1∀i- במקרה שבו יש רק נקודה אחת מכל מחלקה, שתי הנקודות בהכרח יהיו support vectors ויקיימו y(i)(w⊤x(i)+b)=1.

- נניח בלי הגבלת הכלליות ש y(1)=1 ו y(2)=−1.

שני האילוצים שהנקודות אלו מגדירות הם:

⇔⇔⇔{y(1)(w⊤x(1)+b)=1y(2)(w⊤x(2)+b)=1{(w⊤x(1)+b)=1−(w⊤x(2)+b)=1{w⊤x(1)+b=1w⊤x(2)+b=−1{b=−21(x(1)+x(2))⊤ww⊤(x(1)−x(2))=2נוכל להשתמש באילוץ השני ולכתוב בעזרתו את בעיית האופטימיזציה רק על w:

w∗=wargmins.t.21∥w∥2w⊤(x(1)−x(2))=2- בעיה זו מחפשת את ה w בעל האורך המינימאלי כך שהמכפלה הסקלרית שלו עם (x(1)−x(2)) היא 2. הוקטור הזה יהיה וקטור בכיוון של (x(1)−x(2)) ובאורך של 2/∥x(1)−x(2)∥2

- מכאן:

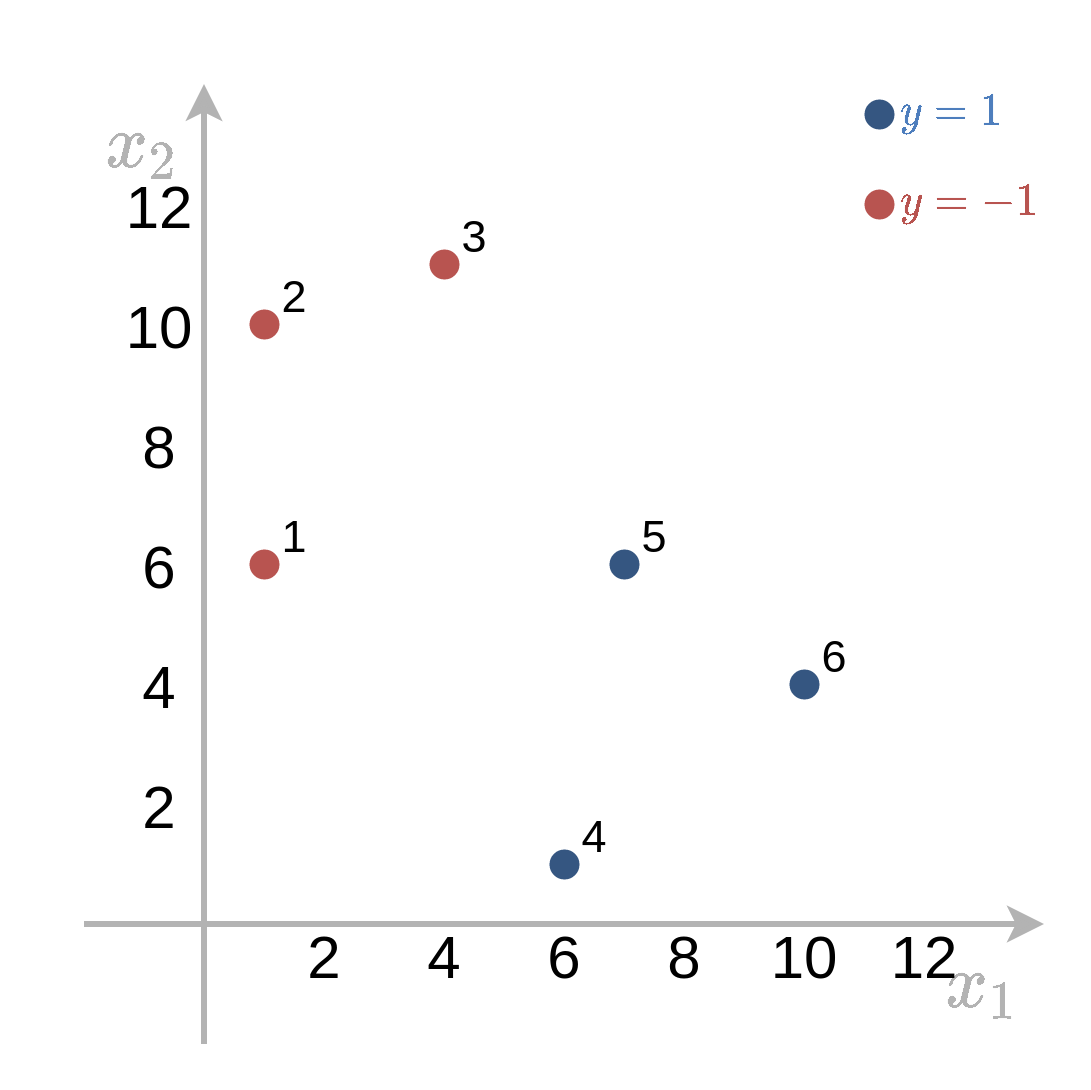

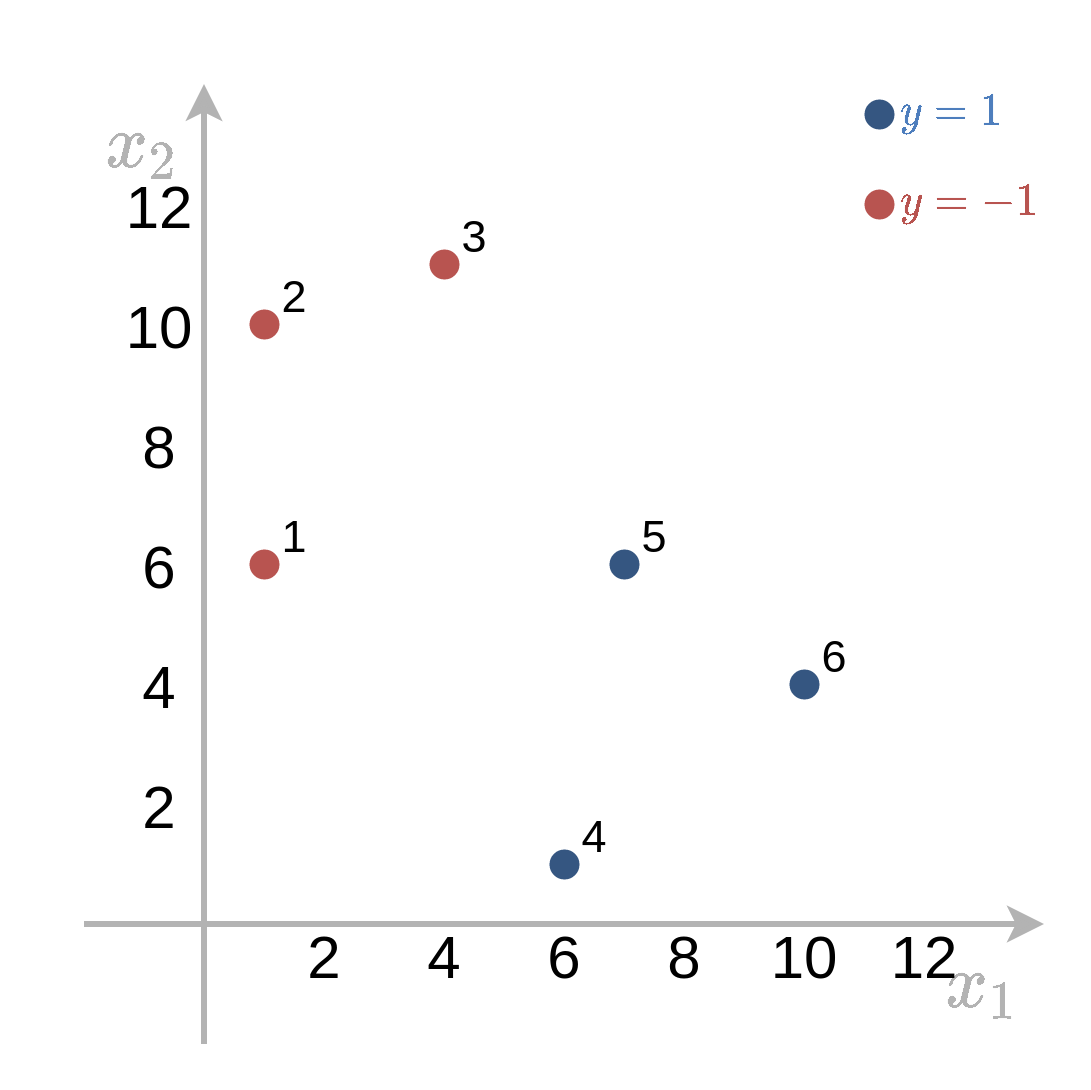

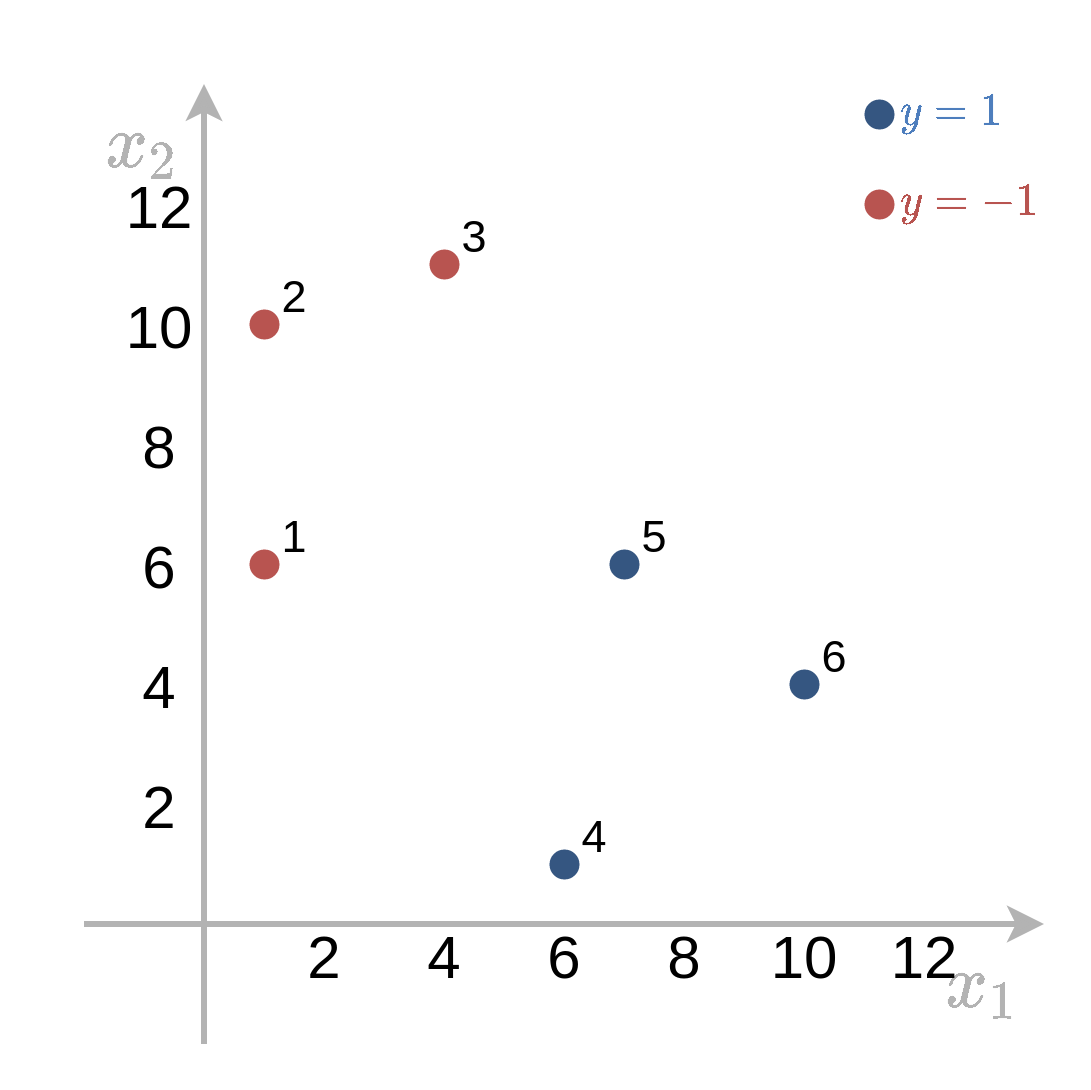

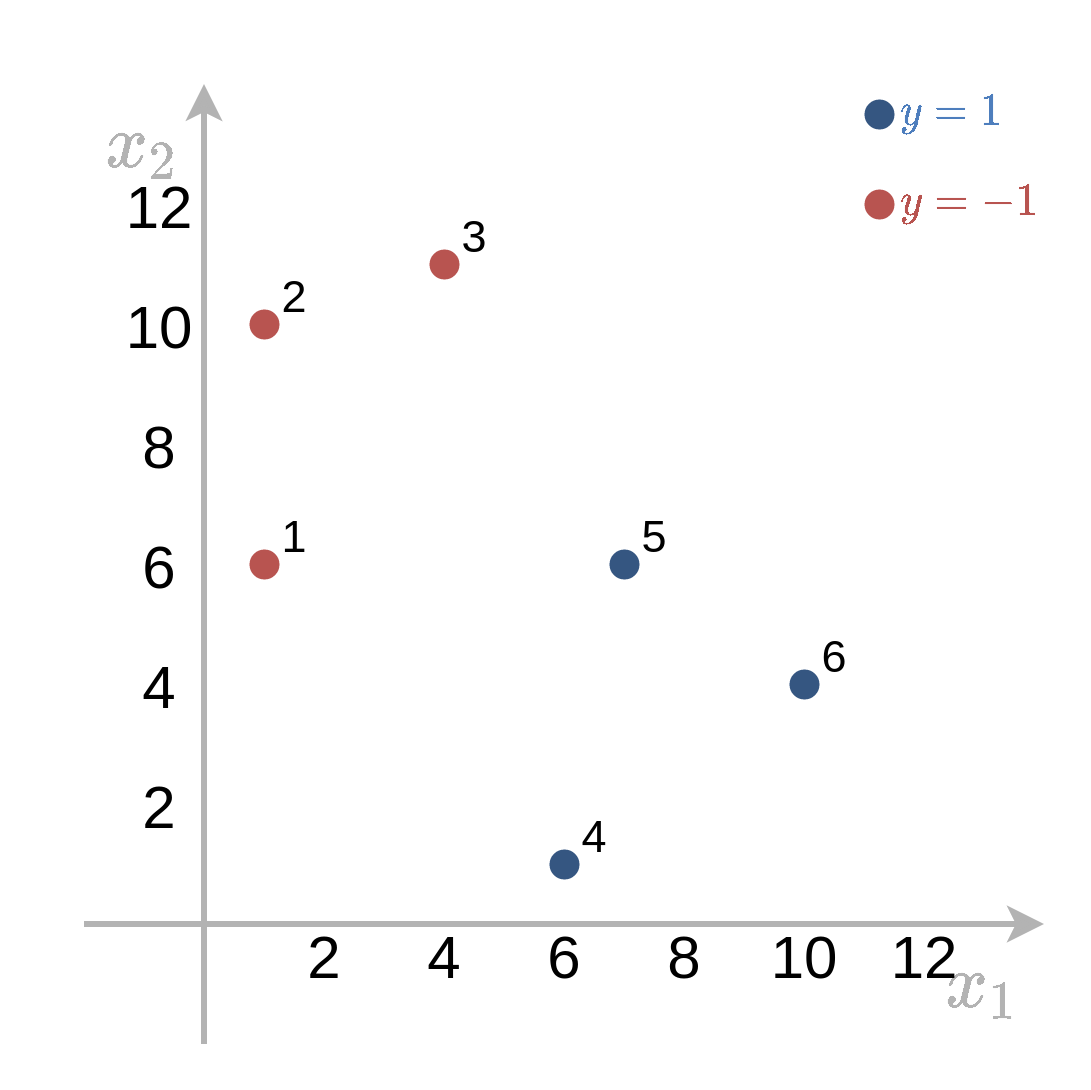

תרגיל 6.2 - Hard SVM

נתון המדגם הבא:

| . | 1 | 2 | 3 | 4 | 5 | 6 |

|---|---|---|---|---|---|---|

| y | -1 | -1 | -1 | 1 | 1 | 1 |

| x1 | 1 | 1 | 4 | 6 | 7 | 10 |

| x2 | 6 | 10 | 11 | 1 | 6 | 4 |

1) מצא את מסווג ה hard SVM המתאים למדגם זה. מי הם וקטורי התמיכה?

- בעיית האופטימיזציה הפרימאלית אותה נרצה לפתור הינה:

-

באופן כללי פתרון בעיות מסוג זה באופן ידני הוא קשה, אך בעבור מקרים פשוטים נוכל לפתור זאת תוך שימוש בעיקרון הבא:

- במידה ומצאנו את הפיתרון האופטימאלי על תת מדגם מתוך המדגם המלא, ומתקיים שבעבור הפתרון שמצאנו, הנקודות שאינן חלק מתת המדגם נמצאות מחוץ ל margin, אז הפתרון הוא בהכרח הפתרון האופטימאלי בעבור המדגם כולו.

- עקרון זה נכון בגלל העובדה שהוספה של אילוצים לבעיית מינימיזציה יכולה רק להגדיל את ה objective המינימאלי.

- המשמעות היא שניתן לנחש את ה support vectors ולפתור את הבעיה רק בעבור נקודות אלו תוך התעלמות משאר הנקודות.

- לאחר שנפתור את הבעיה על הנקודות שניחשנו יהיה עלינו לבדוק אם שאר נקודות במדגם מחוץ ל margin.

- אם אכן שאר הנקודות מחוץ ל margin אז פתרנו את הבעיה ואם לא אז עלינו לנחש נקודות אחרות.

- בעבור ה support vectors האילוצים של y(i)(w⊤x(i)+b)≥1 הופכים להיות אילוצי שיוון שאיתם הרבה יותר קל לעבוד.

ננסה לנחש מהם ה support vectors. נתחיל ב 0 ונגדיל בהדרגה את כמות ה support vectors.

0 or 1 Support Vectors

- באופן כללי בעבור מדגם "נורמלי" אשר מכיל נקודות משני המחלקות שאותן יש לסווג, מקרים אלו לא יוכלו להתקיים.

- באופן תיאורטי במקרה המנוון שבו המדגם מכיל רק תוויות מסוג אחד אז ניתן להגדיר בצורות שונות את כמות ה support vectors, אך מקרים אלו לא מאד רלוונטיים

2 Support Vectors

- על פי התרגיל הקודם בעבור שני support vectors שמישור ההפרדה יעבור בדיוק במרכז בין 2 הנקודות, יהיה ניצב לוקטור המחבר את שתי הנקודות והשוליים של ה- margin יעברו דרך הנקודות.

- ננסה לחפש 2 נקודות שיכולות להיות support vectors.

- נראה שכל בחירה של זוג נקודות יצור איזור של margin שמכיל נקודה אחרת ולכן לא מקיים את האילוצים.

- לכן הפתרון לא יכול להכיל רק שני support vectors.

3 Support Vectors

ישנן שתי שלשות שיתכן שיהיו ה support vectors של הפתרון:

- {1,3,5}

- {3,4,5}

- נסתכל ראשית על תת המדגם {3,4,5}.

- נשים לב שכאן הפתרון עבור תת המדגם {3,5} מקיים את האילוץ שגם נקודה 4 מסווגת נכון.

- אולם ראינו שפתרון כזה אינו מקיים את שאר האילוצים!

- השלשה {1,3,5} מגדירה איזור margin שאינו מכיל נקודות אחרות ולכן מקיים את האילוצים:

- נקודות אלו יהיו שלושת ה support vectors שיגדיר את הפתרון לבעיה. נחשב את הפתרון המתקבל משלושת הנקודות האלה.

מתוך האילוצים נקבל 3 משוואות ב3 נעלמים. בעבור הנקודות {1,3,5} משוואות אלו יהיו:

⎩⎪⎪⎨⎪⎪⎧−((1,6)w+b)=1−((4,11)w+b)=1((7,6)w+b)=1⇔⎩⎪⎪⎨⎪⎪⎧w1+6w2+b=−14w1+11w2+b=−17w1+6w2+b=1הפתרון של מערכת המשוואות הזו הינה w=151(5,−3)⊤ ו b=−152

2) מבלי לפתור את הבעיה הדואלית. אלו ערכים של {αi} בהכרח יתאפסו?

- בעבור נקודות שאינן support vectors, נקבל ש-αi בהכרח יתאפס

- בבעיה זו הנקודות שאינן support vectors הן {2,4,6} ולכן α2=α4=α6=0.

3) מהו הרוחב של ה margin של הפתרון?

ה margin תלוי בגודל של הוקטור w והוא שווה ל:

∥w∥2=52+322⋅15=5.145תרגיל 6.3 - גרעין גאוסי

נתון מדגם המכיל 2 נקודות אחת מכל מחלקה:

x(1)=(1,1)⊤,x(2)=(−1,−1)⊤,y(1)=+1y(2)=−1חשבו את המסווג המתקבל מ hard SVM עם גרעין גאוסי מהצורה K(x1,x2)=exp(−∥x1−x2∥2).

פתרון 6.3

הבעיה הדואלית עם הגרעין הגאוסי הינה:

{αi}∗={αi}argmaxs.t.i∑αi−21i,j∑y(i)y(j)αiαjK(x(i),x(j))αi≥0∀ii∑αiy(i)=0בדומה לתרגיל הראשון נקבל ש:

α1=α2=αנחשב את הערכים של K(x(i),x(j)):

K(x(1),x(1))=exp(0)=1K(x(2),x(2))=exp(0)=1K(x(1),x(2))=exp(−(22+22))=e−8בעיית האופטימיזציה הינה:

α∗=αargmaxs.t.=αargmaxs.t.2α−2α2(K(x(1),x(1))−2K(x(1),x(2))+K(x(2),x(2)))α≥02α−α2(1−e−8)α≥0נגזור ונשווה ל-0:

⇔⇔dαd2α−α2(1−e−8)=01=α(1−e−8)α=1−e−82הוקטור w נתון על ידי: w=∑iαiy(i)Φ(x(i)). נכתוב את הביטוי w⊤Φ(x) בעבור נקודה כל שהיא x:

w⊤Φ(x)=i∑αiy(i)Φ(x(i))⊤Φ(x)=i∑αiy(i)K(x(i),x)=1−e−81(K(x(1),x)−K(x(2),x))נחשב את b על ידי שימוש בנקודה הראשונה:

1⇔b⇔b⇔b=y(1)(w⊤Φ(x(1))+b)=1−w⊤Φ(x(1))=1−1−e−81(K(x(1),x(1))−K(x(2),x(1)))=1−1−e−81(1−e−8)=0המסווג הינו:

h(x)=sign(w⊤Φ(x)+b)=sign(1−e−81(K(x(1),x)−K(x(2),x)))=sign(K(x(1),x)−K(x(2),x))=sign(exp(−∥x(1)−x∥2)−exp(−∥x(2)−x∥2))=sign(∥x(2)−x∥2−∥x(1)−x∥2)=sign((x1+1)2+(x2+1)2−(x1−1)2−(x2−1)2)=sign(2x1+2x2)=sign(x1+x2)חלק מעשי: זיהוי מין הדובר

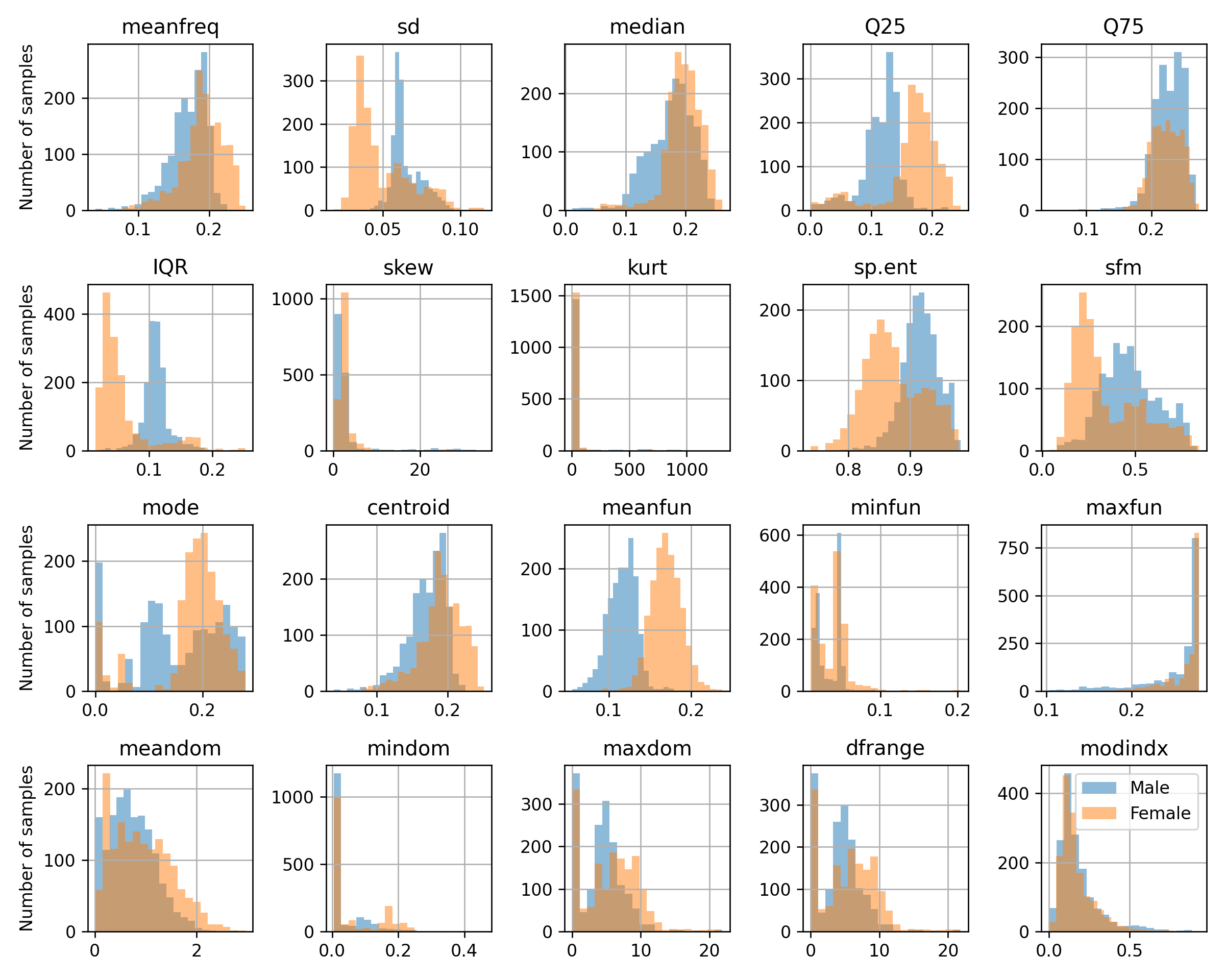

בחלק זה, ננסה להשתמש ב- SVM כדי לזהות את מינו של הדובר באמצעות קולו. מוטיבציה למערכת כזאת יכולה להיות עוזר וירטואלי שרוצה לפנות לדובר לפי מינו. הרחבה לניסיון זה יכולה להיות זיהוי דובר על סמך קולו וכו'.

הרעיון וה- DATA נלקחו מ- Dataset והערכת ביצועים של קורי בקר, אשר נמצאים באתר הבא. בפרוייקט זה נאספו 3168 דגימות קול מתוייגות מהמקורות הבאים:

כל רצועת קול עברה עיבוד באמצעות כלי בשם WarbleR בכדי לייצר 20 Features לכל דגימה:

- label: The label of each track: male/female

- meanfreq: mean frequency (in kHz)

- sd: standard deviation of frequency

- median: median frequency (in kHz)

- Q25: first quantile (in kHz)

- Q75: third quantile (in kHz)

- IQR: interquantile range (in kHz)

- skew: skewness (see note in specprop description)

- kurt: kurtosis (see note in specprop description)

- sp.ent: spectral entropy

- sfm: spectral flatness

- mode: mode frequency

- centroid: frequency centroid (see specprop)

- meanfun: average of fundamental frequency measured across acoustic signal

- minfun: minimum fundamental frequency measured across acoustic signal

- maxfun: maximum fundamental frequency measured across acoustic signal

- meandom: average of dominant frequency measured across acoustic signal

- mindom: minimum of dominant frequency measured across acoustic signal

- maxdom: maximum of dominant frequency measured across acoustic signal

- dfrange: range of dominant frequency measured across acoustic signal

- modindx: modulation index. Calculated as the accumulated absolute difference between

נציג מספר עמודות ושורות מן המדגם:

| label | meanfreq | sd | median | Q25 | Q75 | IQR | skew | kurt | |

|---|---|---|---|---|---|---|---|---|---|

| 0 | male | 0.059781 | 0.0642413 | 0.0320269 | 0.0150715 | 0.0901934 | 0.075122 | 12.8635 | 274.403 |

| 1 | male | 0.0660087 | 0.06731 | 0.0402287 | 0.0194139 | 0.0926662 | 0.0732523 | 22.4233 | 634.614 |

| 2 | male | 0.0773155 | 0.0838294 | 0.0367185 | 0.00870106 | 0.131908 | 0.123207 | 30.7572 | 1024.93 |

| 3 | male | 0.151228 | 0.0721106 | 0.158011 | 0.0965817 | 0.207955 | 0.111374 | 1.23283 | 4.1773 |

| 4 | male | 0.13512 | 0.0791461 | 0.124656 | 0.0787202 | 0.206045 | 0.127325 | 1.10117 | 4.33371 |

| 5 | male | 0.132786 | 0.0795569 | 0.11909 | 0.067958 | 0.209592 | 0.141634 | 1.93256 | 8.3089 |

| 6 | male | 0.150762 | 0.0744632 | 0.160106 | 0.0928989 | 0.205718 | 0.112819 | 1.53064 | 5.9875 |

| 7 | male | 0.160514 | 0.0767669 | 0.144337 | 0.110532 | 0.231962 | 0.12143 | 1.39716 | 4.76661 |

| 8 | male | 0.142239 | 0.0780185 | 0.138587 | 0.0882063 | 0.208587 | 0.120381 | 1.09975 | 4.07028 |

| 9 | male | 0.134329 | 0.08035 | 0.121451 | 0.07558 | 0.201957 | 0.126377 | 1.19037 | 4.78731 |

הפילוג של התוויות (גברים נשים) במדגם הינו:

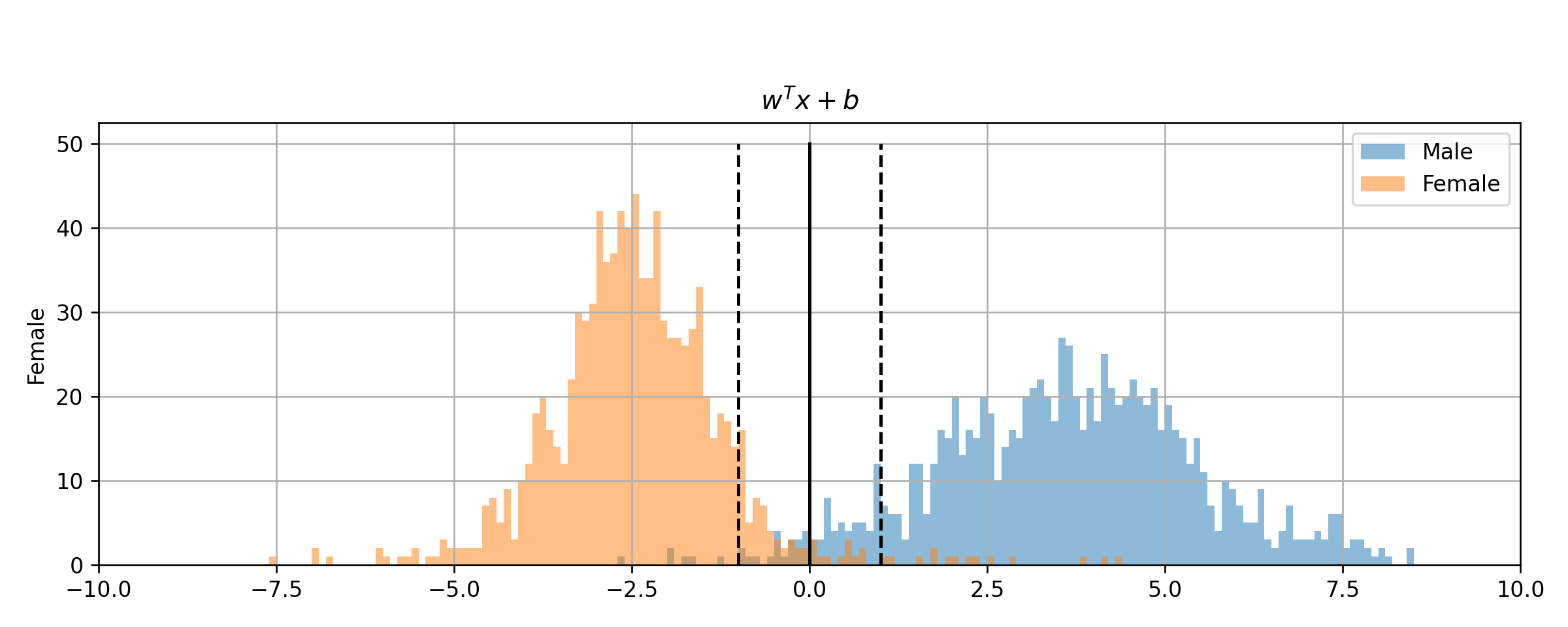

נציג את ההיסטוגרמה של כל אחד מהמאפיינים בעבור כל אחד מתוויות:

Soft SVM

ננסה לפתור את בעיית הסיווג של מין הדובר בעזרת soft SVM. נרצה לשם כך לפתור את בעיית האופטימיזציה הבאה (הבעיה הדואלית):

{αi}∗={αi}argmaxs.t.i∑αi−21i,j∑y(i)y(j)αiαjx(i)⊤x(j)0≤αi≤C∀ii∑αiy(i)=0- נמצא את w בעזרת:

- ניתן לחשב את b על ידי בחירה של נקודה שעבורה 0<αi ולהשתמש במשוואה: yi(wTxi+b)=1−ξi.

- בכדי לפתור את הבעיה נצטרך לבחור פרמטר משקל C אשר קובע את גודל הקנס לנקודות שחורגות מה margin. נתחיל ב C=1 ואחר כך ננסה למצוא את הערך המיטבי.

חלוקת המדגם

כרגיל נחלק את המדגם ל 60%-20%-20% שהם train-validation-test.

נרמול

חשוב לנרמל את העמודות של המדגם לפני הרצת האלגוריתם משתי סיבות עיקריות:

- המדגם מכיל מאפיינים ביחידות וסקלות שונות.

- האלגוריתם מנסה למזער objective אשר מבוסס מרחק, מה שהופך אותו לרגיש לגודל של כל מאפיין. לדוגמא, אם נכפיל מאפיין מסויים בקבוע גדול מ-1 אנו ניתן לו חשיבות יתרה ב objective.

תוצאות

נשתמש באופטימיזציה נומרית על מנת למצוא את הפרמטרים של משטח ההפרדה. לשם המחשה נשרטט את הפילוג של ה signed distance של הנקודות בכל אחת מהמחלקות

ניתן לראות כי המשטח באמת מצליח לחלק את המדגם, עד כדי כמה נקודות שחורגות.

ה miscalssification rate שמתקבל על ה test set הינו 0.028.

מציאת ה C האופטימאלי

נבחן סדרה של ערכי C בתחום 10−3 עד 103. כרגיל, בעבור כל ערך נבנה מסווג ונבחן אותו על ה validation set. נקבל את התוצאה הבאה:

קיבלנו כי הערך שאיתו התחלנו של C=1 הוא האופטימאלי מבין הערכים שבחרנו.