הרצאה 13 - סיכום

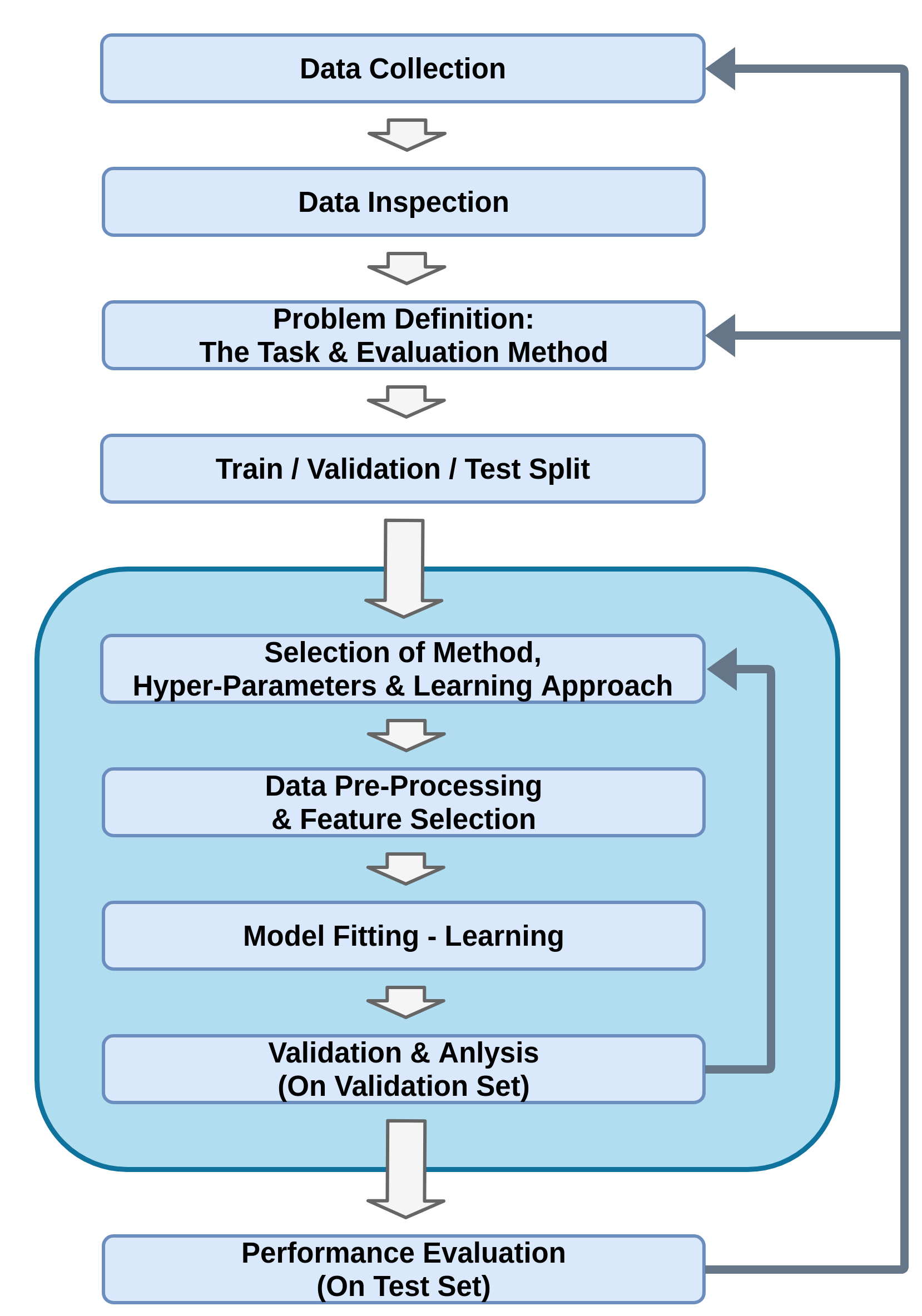

תהליך פתרון בעיה בלמידה מונחית

הגדרת הבעיה

ב supervised learning תמיד ננסה למצוא חזאי y^=h(x).

הפרדנו בין שתי מקרים:

- בעיות סיווג (classification): y דיסקרטי וסופי.

- בעיות רגרסיה (regression): y רציף.

קיימים מקרים בהם מספר התיוגים המותרים לכל קלט גדול מאחד. דוגמה? Multi label problem.

הערכת ביצועים

נגדיר את פונקציית המחיר (cost) שבה נרצה להשתמש בכדי להעריך את החזאי. לרוב נבחר פונקציית מחיר מהצורה:

C(h)=E[l(h(x),y)]פונקציות מסוג זה מכונות פונקציות סיכון (risk).

הפונקציה l מוכנה פונקציית ההפסד (loss)

- מכיוון שהפילוג של y ו x לא באמת ידוע לנו אנו נשתמש ב test set ובתוחלת בכדי להעריך את הביצועים.

פונקציות הפסד (פונקציות סיכון) נפוצות

| Common For | Loss Name | Risk Name | Loss Function | Optimal Predictor |

|---|---|---|---|---|

| Classification | Zero-One Loss | Misclassification Rate | l(y1,y2)=I{y1=y2} | h∗(x)=yargmax py∣x(y∣x) |

| Regression | L1 | Mean Absolute Error | l(y1,y2)=∣y1−y2∣ | Median: h∗(x)=y^ s.t. Fy∣x(y^∣x)=0.5 |

| Regression | L2 | Mean Squared Error (MSE) | l(y1,y2)=(y1−y2)2 | h∗(x)=E[y∣x] |

שאלה: מתי יש מוטיבציה לפונקציית הפסד שאינה 0-1 במקרה של סיווג? דוגמה?

Discriminative vs. Generative

אנו מבחינים בין 3 גישות אשר משמשות לפתרון בעיות supervised learning:

- גישה דיסקרימינטיבית: D -> h(x).

- גישה גנרטיבית: D -> px,y(x,y) -> py∣x(y∣x) -> h(x).

- גישה דיסקרימינטיבית הסתברותית: D -> py∣x(y∣x) -> h(x).

שאלה: מתי יש יתרונות יחסיים לגישות השונות?

פירמול הבעיה

במרבית השיטות נשתמש במודל פרמטרי (לחזאי או לפילוג) ונרשום את הבעיה כבעיית אופטימיזציה על הפרמטרים θ של המודל:

θ∗=θargminf(θ;D)- לרוב לא נדע לפתור את הבעיה באופן אנליטי ונשתמש בשיטות אלטרנטיביות למציאת פתרון "סביר".

- בדרך כלל משתמשים בגישות מקומיות מבוססות גרדיאנט. גישות אלה מוגבלות בגלל המקומיות של החיפוש. יש דרכים לשפרן, אך אין פתרון אוניברסלי.

Cross-Validation

למרבית השיטות יש מספר hyper-parameters שאינם חלק מבעיית האופטימיזציה שאותם יש לקבוע מראש.

הדרך הנפוצה לבחור hyper-parameters הינה על ידי שימוש ב validation set על מנת לבדוק מספר ערכים שונים ולבחור את אלו אשר נותים את הביצועים הטובים ביותר.

עיבוד מקדים (preprocessing)

במרבית המקרים אנו נרצה לבצע פעולות שונות על המדגם לפני הזנתו לאלגוריתם על מנת להקל על עבודת האלגוריתם.

דוגמאות:

- חילוץ מאפיינים שנבחרו באופן ידני: xnew=Φ(x).

- הורדת מימד (על ידי שימוש באלגוריתם כגון PCA).

- נרמול: xnew=σx1(x−μx)

- אוגמנטציה (לא נלמד בקורס)

התפקיד של ידע מוקדם בלמידה

- מושג טכני = inductive bias

- ידע מוקדם – כל מה שיודעים על הבעיה לפני קבלת הנתונים

- מימוש – הגבלות על מבנה מרחב ההשערות, פונקציית המחיר, אלגוריתם האופטימיזציה

- מוטיבציה – שיפור יכולת ההכללה (מניעת התאמת יתר), חסינות לרעש, האצת למידה, "פרשנות" פשוטה יותר של הפתרון

התפקיד של ידע מוקדם בלמידה

דוגמאות

- בחירת מאפיינים מושכלת

- מבנה הרשת – למשל CNN משקף מבנה של תמונות

- רגולריזציה – העדפת מודלים "פשוטים"

- העברת ידע מבעיות קודמות (transfer learning) - לא למדנו

- הרחבת הנתונים (data augmentation) - לא למדנו

היום – הרבה ידע מוקדם "מסתובב" מפתרונות טובים של בעיות קודמות וניתן להעברה למטלות חדשות. למשל, בנושאים של עיבוד תמונה, עיבוד שפה, חיזוי מבנה חלבונים ועוד הרבה

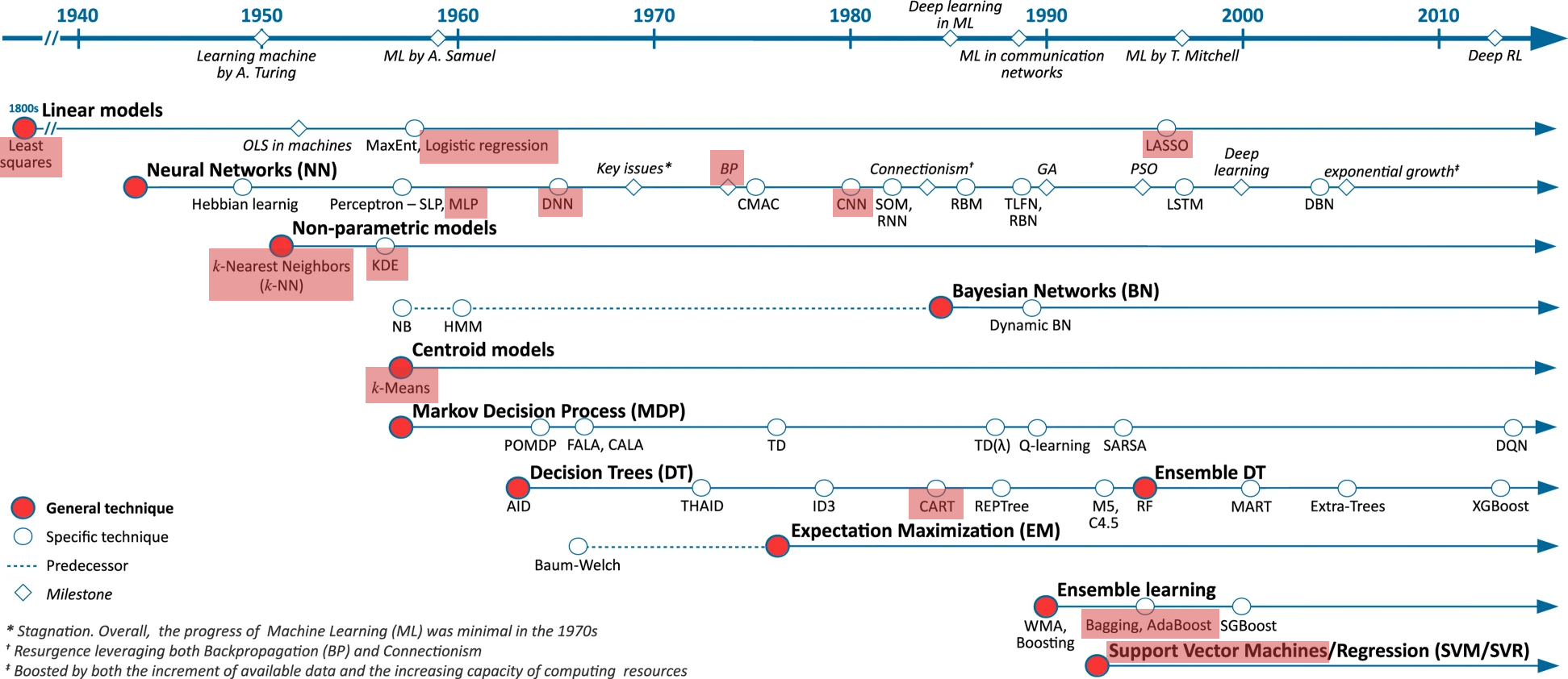

מעבר על האלגוריתמים שנלמדו בקורס

נעבור במהירות על האלגוריתמים שאותם ראינו בקורס ונבחן את המאפיינים שלהם.

Timeline

Empirical Risk Minimization

- Problem type: Regression (Classifcation)

- Approach: Discriminative

- Optimization problem: θ∗=θargmin N1∑il(h(x(i);θ),y(i))

Linear Least Squares (LLS)

(also known as ordinary least squares-OLS)

- Problem type: Regression with MSE risk

- Approach: Discriminative

- Model: h(x;θ)=θ⊤x

- Optimization problem: θ∗=θargmin N1∑i(θ⊤x(i)−y(i))2

- How to solve: Closed-form solution: θ=(X⊤X)−1X⊤y.

Ridge Regression

(LLS with Tikhonov Regularization (l2))

- Problem type: Regression with MSE risk

- Approach: Discriminative

- Model: h(x;θ)=θ⊤x

- Hyper-parameter: Regularization coefficient λ

- Optimization: θ∗=θargmin N1∑i(θ⊤x(i)−y(i))2+λ∥θ∥22

- Question: what is the motivation for the regularization?

- How to solve: θ=(X⊤X+λI)−1X⊤y, or using Gradient Descent methods.

Least Absolute Shrinkage and Selection Operator (LASSO)

(LLS with l1 Regularization)

- Problem type: Regression with MSE risk

- Approach: Discriminative

- Model: h(x;θ)=θ⊤x

- Hyper-parameter: Regularization coefficient λ

- Optimization: θ∗=θargmin N1∑i(θ⊤x(i)−y(i))2+λ∑j∣θj∣

- How to solve: Variants of gradient descent (were not presented in the course).

K-Nearest Neighbors (K-NN)

- Problem type: Classification (and also regression)

- Approach: Discriminative

- Hyper-parameter: Number of neighbors K.

- Properties: Required amount of data that is exponential in the dimension. Good for low dimensions with a lot of data. Slow runtime.

-

Questions:

- What is the training process?

- What is the main difference between this method and other parametric methods we have learned?

Decision Trees

- Problem type: Classification or regression

- Approach: Discriminative

- Model: A tree with nodes that threshold a single feature.

- Hyper-parameter: Number of nodes.

-

Optimization:

- Classification: Minimize entropy or the Gini index.

- Regression: Minimize RMSE.

- How to solve: Add nodes in a greedy manner + pruning.

Decision Trees - Cont.

-

Properties:

- Very efficient runtime.

- Usually overfits but can efficiently be combined with bagging or boosting.

- Can work with categorical features.

- More interptable (without ensembles).

Hard SVM

- Problem type: Binary classification

- Approach: Discriminative

- Model: h(x)=sign(wTx+b)

-

Optimization:

w∗,b∗=w,bargmins.t.21∥w∥2(w⊤x(i)+b)y(i)≥1∀i - How to solve: Numerical convex optimization solvers.

- Property: Requires the data to be linearly seperable.

Soft SVM

- Problem type: Binary classification

- Approach: Discriminative

- Model: h(x)=sign(wTx+b)

- Hyper-parameter: The slack penalty term C.

-

Optimization:

w∗,b∗,{ξi}∗=w,b,{ξi}argmins.t.21∥w∥2+Ci=1∑Nξiy(i)(w⊤x(i)+b)≥1−ξi∀iξi≥0∀i

Soft SVM - Cont.

- How to solve: Numerical convex optimization solvers.

- Property: Can be very efficient when combined with the right kernal using the kernal-trick.

Histogram

- Approach: Generative

- Model: Piecewise constant probability function.

- Hyper-parameter: Bin edges.

- How to solve: Count relative number of samples in each bin.

-

Properties:

- Not very useful for supervised learning.

- Required amount of data is exponential in the dimension.

- Great for quick visualization.

KDE

- Approach: Generative

- Model: Linear combination of N shifted kernel functions.

- Hyper-parameter: The kernel function

-

Properties:

- Required amount of data is exponential in the dimension. Good for low dimensions with a lot of data.

Linear Discriminant Analysis (LDA)

- Problem type: Classification

- Approach: Generative

- Model: px∣y(x∣y)=(2π)d∣Σ∣1e−21(x−μy)TΣ−1(x−μy)

- Optimization: MLE (or MAP)

- How to solve: Has a closed-form solution.

-

Properties:

- Linear separation lines.

- Good when each class is concentrated in a different area of the feature space.

- Can deal with classes with very few examples (even 1).

Quadric Discriminant Analysis (QDA)

- Problem type: Classification

- Approach: Generative

- Model: px∣y(x∣y)=(2π)d∣Σy∣1e−21(x−μy)TΣy−1(x−μy)

- Optimization: MLE (or MAP)

- How to solve: Has a closed-form solution.

-

Properties:

- Quadric separetion lines.

- Good when each class is concentrated in a different area of the feature space.

Logistic Regression

- Problem type: Classification

- Approach: Probabilistic Discriminative

- Model: py∣x(y∣x)=softmax(F(x;θ))y=∑cefc(x;θc)efy(x;θy)

- Hyper-parameter: The functions fy(x;θy).

- Optimization: MLE (or MAP)

- How to solve: Gradient descent.

Linear Logistic Regression

- Problem type: Classification

- Approach: Probabilistic Discriminative

- Model: py∣x(y∣x)=softmax(Θx)y=∑ceθc⊤xeθy⊤x

- Hyper-parameter: The matrix Θ.

- Optimization: MLE (or MAP)

- How to solve: Gradient descent.

Multi-Layer Perceptron (MLP)

- Problem type: Either

- Approach: Probabilistic Discriminative / Discriminative

- Model: A neural network of fully connected layers.

- Hyper-parameter: The number of layers and their width + activation functions.

-

Optimization:

- Classification: MLE (or MAP)

- Regression: ERM

- How to solve: Stochastic Gradient descent (and variants) + backpropogation.

- Property: Requires large amounts of data in order to avoid overfiting.

Convolutional Neural Network (CNN)

- Problem type: Either

- Approach: Probabilistic Discriminative / Discriminative

- Model: A NN of convolutional + fully connected layers.

- Hyper-parameter: The architecture.

-

Optimization:

- Classification: MLE (or MAP)

- Regression: ERM

- How to solve: Gradient descent + backpropogation.

- Property: Very efficient when x has some spatial structure (e.g. images).

Bagging and Boosting

בנוסף לכל השיטות הנ"ל ראינו גם כיצד ניתן לשלב מספר חזאים באופן הבא:

- בעזרת Bagging בכדי להקטין את ה variance (overfitting) של החזאים.

- בעזרת AdaBoost בכדי להקטין את ה bias (underfitting) של החזאים.

מה הלאה - קורסים?

קורסים נוספים בפקולטה בתחום:

- 046202 - עיבוד וניתוח מידע (unsupervised).

- 046211 - למידה עמוקה.

- 046203 - תכנון ולמידה מחיזוקים (reinforcment).

- 046746 - אלגוריתמים ויישומים בראיה ממוחשבת.

- 046853 - .ארכיטקטורות מחשבים מתקדמות

מה הלאה - Deep learning?

הכרת טכניקות ספציפיות ברשתות נוירונים (ארכיטקטורות, אופטימיזציות, רגולריזציה וכו'):

- מאד דינמי ומשתנה בקצב גבוה.

- משתנה מבעיה לבעיה.

- הכי טוב זה לקחת בעיה ולראות מה השיטות בהם משתמשים כיום בכדי לפתור אותה.

- Google is your friend ...

מה הלאה - צבירת נסיון?

התחום של מערכות לומדות דורש המון נסיון ואינטואיציה שנרכשים עם הזמן.

- פרוייקט בתחום.

- Kaggle.

חברי סגל בתחום

- אביב תמר

- איילת טל

- גיא גלבוע

- דניאל סודרי

- יואב שכנר

- יניב רומנו

- כפיר לוי

- ליהי צלניק-מנור

- נחום שימקין

- ענת לוין

- רון מאיר

- שי מנור

- תומר מיכאלי