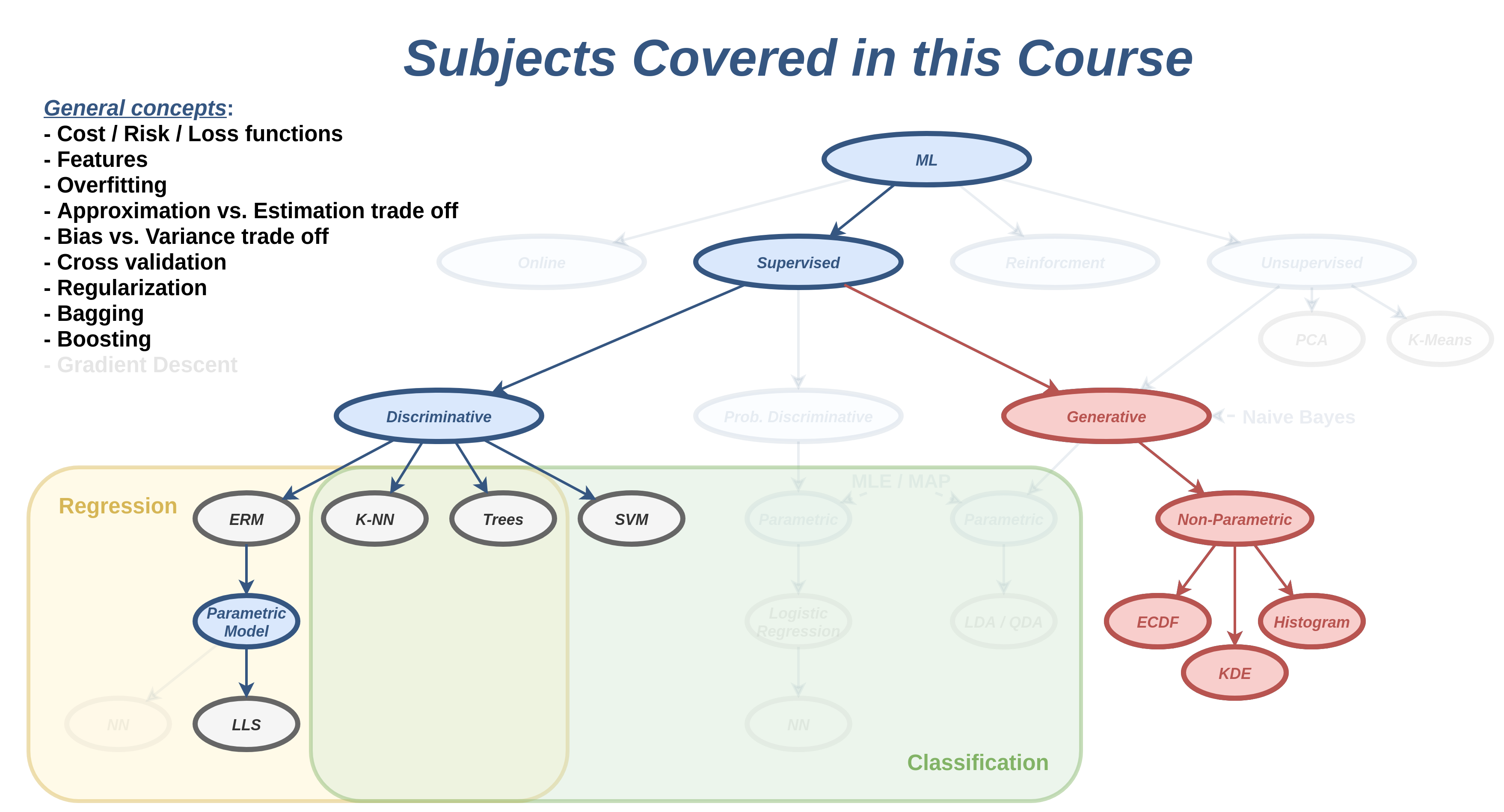

הרצאה 7 - שיערוך פילוג בשיטות לא פרמטריות

מה נלמד היום

דיסקרימינטיבי vs. גנרטיבי

הגישה הדיסקרימינטיבית

מדגם

️▼

חזאי בעל ביצועים טובים על המדגם

הגישה הגנרטיבית

מדגם

▼

פילוג על סמך המדגם

▼

חזאי אופטימאלי בהינתן הפילוג

הקשר לבעיות unsupervised learning

- בקורס זה לא נעסוק כמעט בבעיות unsupervised learning.

- בבעיות unsupervised learning המדגם מכיל סוג אחד של משתנים x.

- ננסה ללמוד מהם התכונות שמאפיינות את הדגימות במדגם.

- אחת הדרכים הטובות ביותר לעשות זאת היא על ידי שיערוך הפילוג שלהם.

שיערוך הפילוג

הבעיה של בניית מודל הסתברותי של משתנים אקראיים מתוך מדגם מכונה בעיית שיערוך (estimation). את המודל ההסתברותי אנו נבטא בעזרת אחת מהפונקציות הבאות:

- פונקציית ההסתברות (probablity mass function - PMF)

- פונקציית צפיפות ההסתברות (probability density function - PDF)

- פונקציית הפילוג המצרפית (cumulative distribution function CDF).

חיזוי (prediction) ושיערוך (estimation)

- בבעיות חיזוי אנו מועניינים לחזות את ערכו של משתנה אקראי, לרוב על סמך משתנה / וקטור אקראי בודד (דגימה יחידה).

- בבעיות שיערוך אנו מעוניינים לבנות מודל הסתברותי של משתנה / משתנים אקראיים לרוב על סמך הרבה דגימות.

דוגמא

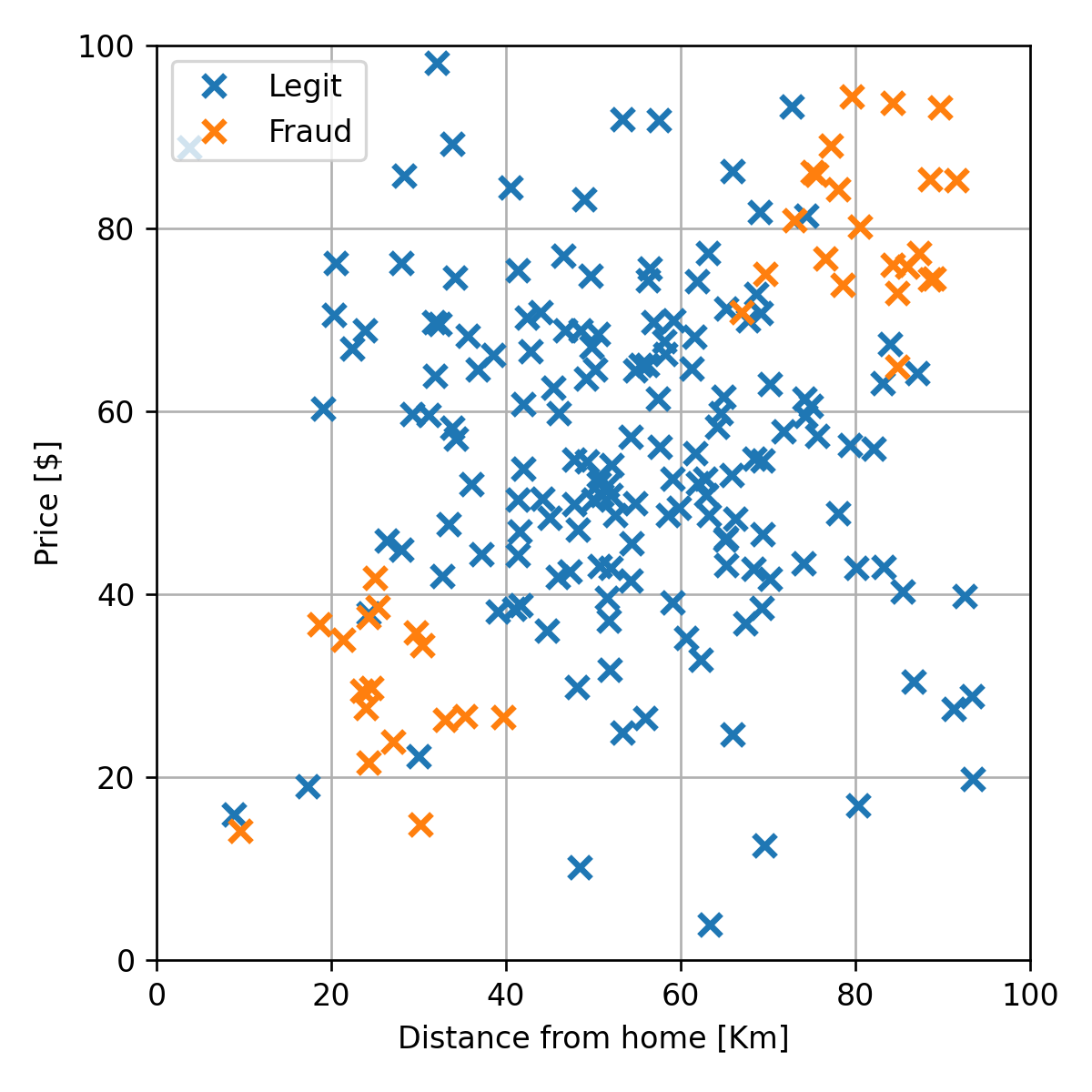

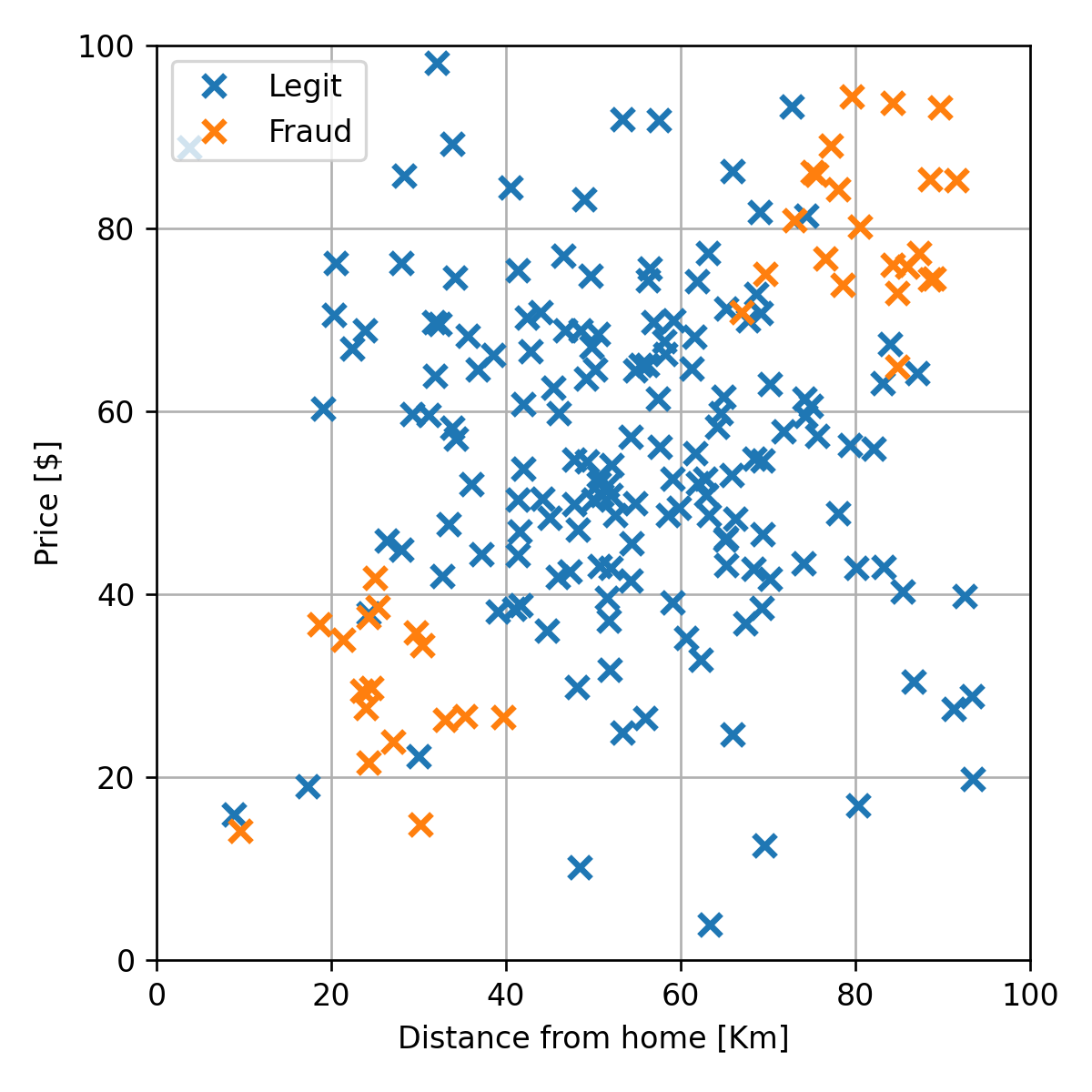

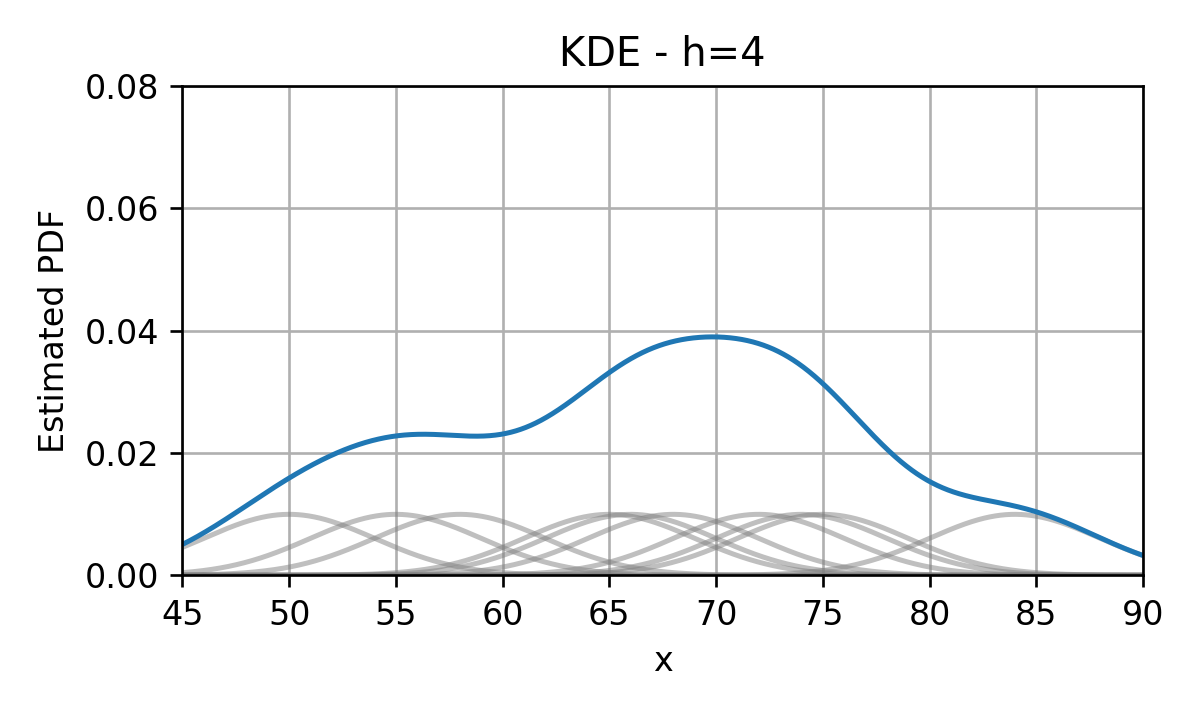

נסתכל לדוגמא על המדגם של הונאות אשראי מהרצאה הקודמת:

נרצה לשערך את הפילוג של המשתנים על פי מדגם זה

דוגמא

לדוגמא היינו רוצים למצוא פונקציות אשר יתארו את הפילוג של הדגימות החוקיות ושל ההונאות:

שיערוך א-פרמטריות

בהרצאה הקרובה נעסוק בשיטות שיערוך אשר מכונות שיטות לא פרמטריות או א-פרמטריות, מהות השם תהיה ברורה יותר אחרי שנציג בהרצאה הבאה את הנושא של שיטות פרמטריות.

שיערוך ההסתברות של מאורע

דוגמא

נניח שיש בידינו את המדגם הבא של מדידות של זמני נסיעה (בדקות) מחיפה לתל אביב על כביש החוף:

D={x(i)}={55,68,75,50,72,84,65,58,74,66}ברצונינו לשערך את ההסתברות של המאורע שנסיעה מסויימת תיקח פחות משעה, A={x<60}.

שיערוך ההסתברות של מאורע

דוגמא

D={x(i)}={55,68,75,50,72,84,65,58,74,66}נשערך שהסתברות זו שווה למספר הפעמים היחסי שמאורע זה קרה במדגם הנתון:

Pr(A)≈p^A,D=0.3- נשתמש בסימון "כובע" לציון גודל שאותו אנו חוזים / משערכים באופן אמפירי.

- נציין את העובדה שמשערך תלוי במדגם שבו השתמשנו על ידי הוספת D מתחת למשערך.

מדידה אמפירית (empirical measure)

/ משערך הצבה

בהינתן מדגם מסויים D={x(i)}i=0N, המדידה האמפירית, p^A,D, הינה שיערוך של הההסתברות, Pr(A), והיא מחושבת באופן הבא:

p^A,D=N1i=1∑NI{x(i)∈A}נוכל כעת להשתמש בשיטה זו על מנת לנסות ולשערך את הפילוג של משתנים אקראיים.

משתנה אקראי דיסקרטי

דוגמא 1 - משתנה בינארי

- x תוצאת הטלה של מטבע לא הוגן.

- הטלנו את המטבע 10 פעמים וקיבלנו:

מה ה PMF של x?

משתנה אקראי דיסקרטי

דוגמא 1 - משתנה בינארי

D={x(i)}={0,0,0,0,1,0,0,1,0,0}גם כאן נשערך את ההסתברויות של הערכים ש x מקבל על פי השכיחות שלהם במדגם:

px(x)≈p^x,D(x)={0.80.201- זו למעשה מדידה אמפירית של המאורע ש {x=x}.

משתנה אקראי דיסקרטי

דוגמא 2 - משתנה לא בינארי

- x תוצאת הטלה של קוביה לא הוגנת.

- הטלנו את הקוביה 10 פעמים וקיבלנו:

מה ה PMF של x?

משתנה אקראי דיסקרטי

דוגמא 2 - משתנה לא בינארי

D={x(i)}={3,2,5,1,2,6,2,5,5,3}בדיוק כמו קודם, נשערך את ההסתברות לקבל כל ערך לפי השכיחות שלו במדגם:

px(x)≈p^x,D(x)=⎩⎪⎪⎪⎪⎪⎪⎪⎪⎪⎨⎪⎪⎪⎪⎪⎪⎪⎪⎪⎧0.10.30.200.30.1123456ניסוח פורמאלי

בהינתן מדגם מסויים D={x(i)}i=0N, נוכל לשערך את ה PMF של משתנה / וקטור אקראי דיסקרטי באופן הבא:

p^x,D(x)=N1i=1∑NI{x(i)=x}שימו לב שמובטח לנו שנקבל פונקציית הסתברות חוקית (חיובית שהסכום עליה שווה ל1).

שיערוך הפילוג המצרפי

נזכור כי פונקציית הפילוג המצרפי (ה CDF) מוגדרת באופן הבא:

Fx(x)=Pr({xj≤xj ∀j})נוכל אם כן לשערך גודל זה על ידי שימוש במדידה האמפירית בעבור המאורע של A={xj≤xj∀j} באופן הבא:

F^x,D(x)=p^A,D=N1i=1∑NI{xj≤xj∀j}משערך זה נקרא empirical cumulative distribtuion function (ECDF).

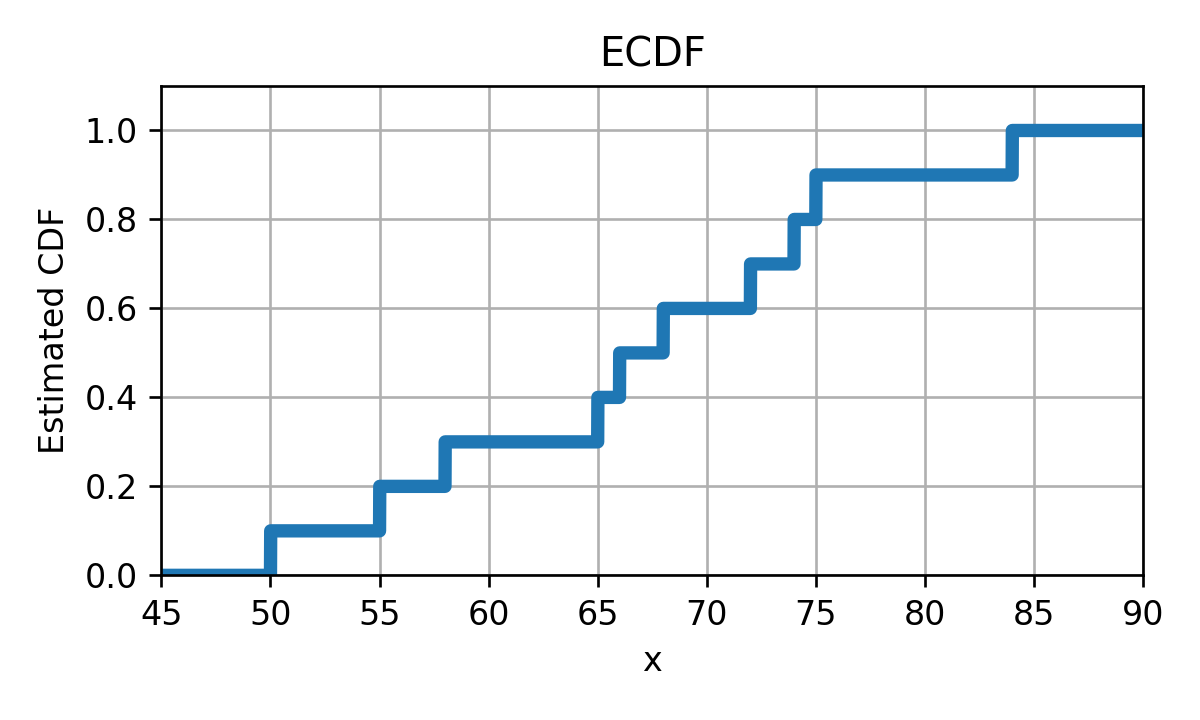

ECDF - דוגמא

נשערך את הפילוג המצרפי של זמני הנסיעה בכביש החוף

D={x(i)}={55,68,75,50,72,84,65,58,74,66} F^x,D(x)=⎩⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎨⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎧00.10.20.30.40.50.60.70.80.91x<5050≤x<5555≤x<5858≤x<6565≤x<6666≤x<6868≤x<7272≤x<7474≤x<7575≤x<8484≤xECDF - דוגמא

זוהי למעשה פונקציה קבועה למקוטעין אשר נראית כך:

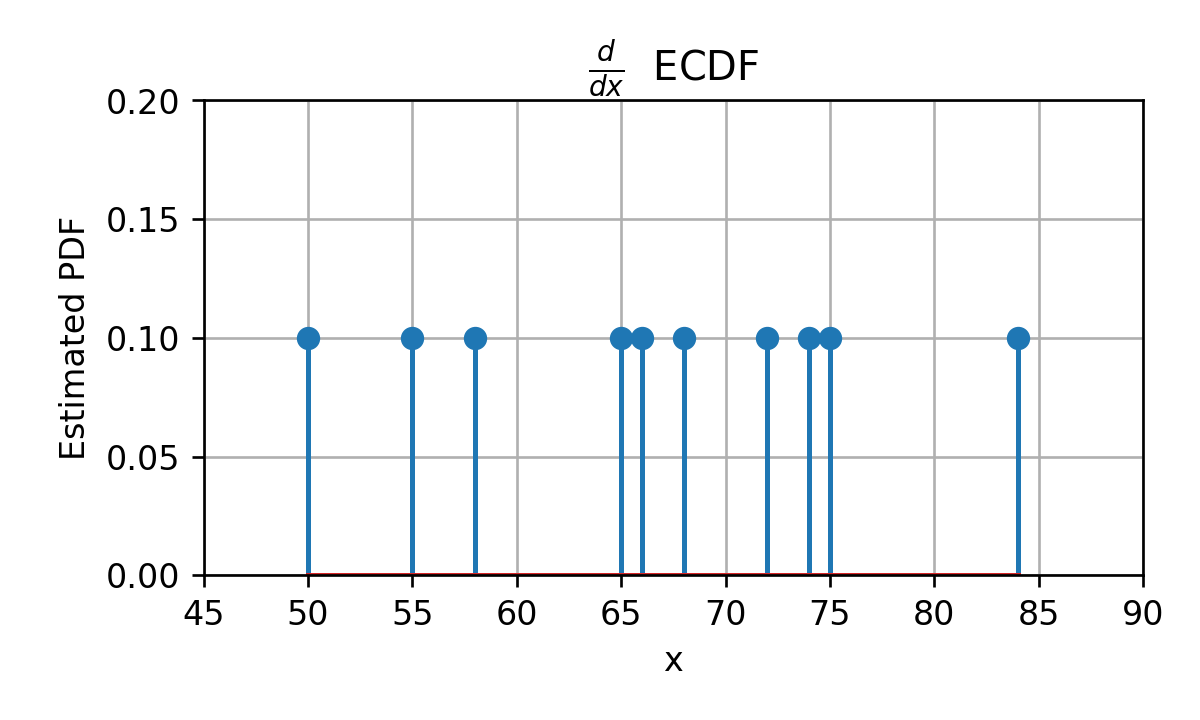

בעיה: איך נראה ה PDF?

ECDF - דוגמא

ככה:

פונקציה כזו היא לא מאד שימושית.

היסטוגרמה

נסיון לשערך PDF על ידי קוונטיזציה של משתנה רציף.

- נחלק את טווח הערכים למספר סופי של חלקים המכוונים bins (תאים).

- נשתמש במדידה אמפירת על מנת לשערך את ההסתברות להימצא בכל תא.

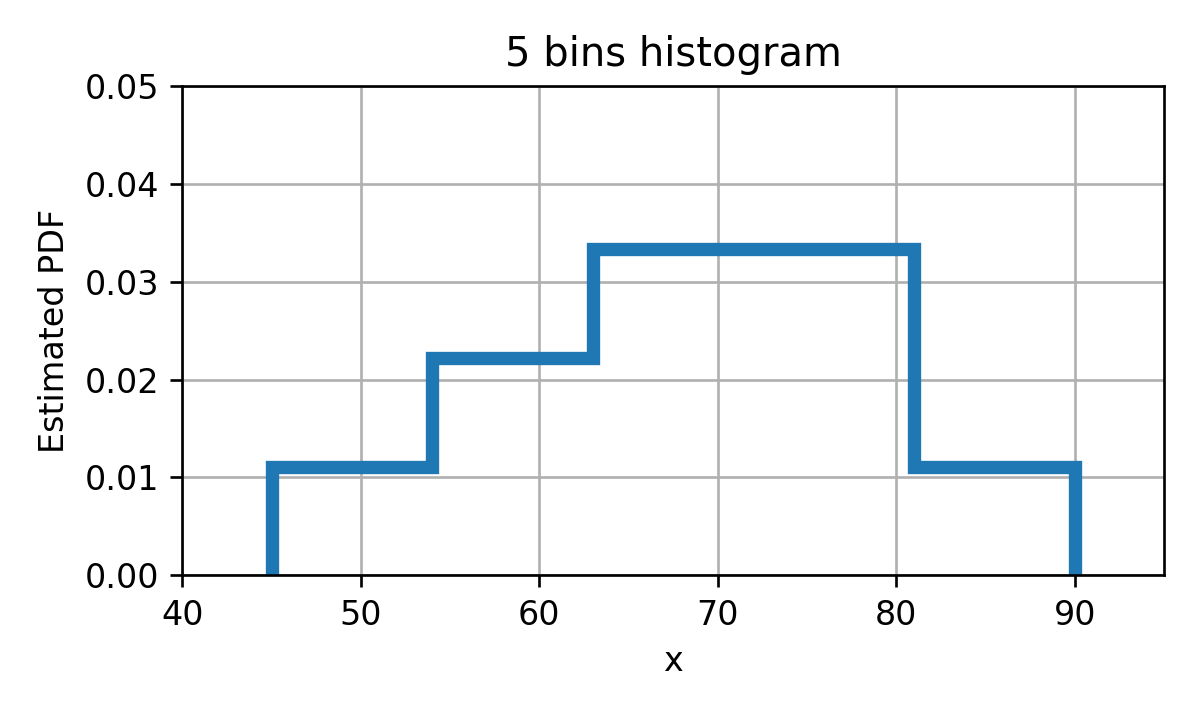

היסטוגרמה - דוגמא

D={x(i)}={55,68,75,50,72,84,65,58,74,66}נחלק את התחום ל 5 קטעים:

[45,54),[54,63),[63,72),[72,81),[81,90]ההסתברות להיות בכל bin הינה:

p^{45≤x<54},Dp^{54≤x<63},Dp^{63≤x<72},Dp^{72≤x<81},Dp^{81≤x≤90},D=0.1=0.2=0.3=0.3=0.1יש לבחור את ה bins כך שיכסו את התחום ולא יחפפו.

היסטוגרמה

בכדי להפוך את ההסתברויות לצפיפות הסתברות נרצה "למרוח" את ההסתברות שקיבלנו באופן אחיד על פני ה bin.

p^x,D(x)=⎩⎪⎪⎪⎨⎪⎪⎪⎧size of bin 11p^{x in bin 1},D⋮size of bin B1p^{x in bin B},Dx in bin 1x in bin Bהיסטוגרמה - דוגמא

p^{45≤x<54},Dp^{54≤x<63},Dp^{63≤x<72},Dp^{72≤x<81},Dp^{81≤x≤90},D=0.1=0.2=0.3=0.3=0.1

היסטוגרמה - ניסוח פורמאלי

בהינתן מדגם מסויים D={x(i)}i=0N, ההיסטוגרמה הינה שיערוך של ה PDF של משתנה / וקטור אקראי והיא מחושבת באופן הבא:

- מחלקים את תחום הערכים ש x יכול לקבל ל bins (תאים) לא חופפים אשר מכסים את כל התחום.

- לכל bin משערכים את ההסתברות של המאורע שבו x יהיה בתוך התא.

- הערך של פונקציית הצפיפות בכל תא תהיה ההסתברות המשוערכת להיות בתא חלקי גודל התא.

לבחירת ה bins יש השפעה גדולה על איכות השיערוך שנקבל. ננסה להבין את השיקולים בבחירת ה bins.

היסטוגרמה - המקרה הסקלרי

- B מספר התאים.

- lb ו rb את הגבול השמאלי והימני התא ה b.

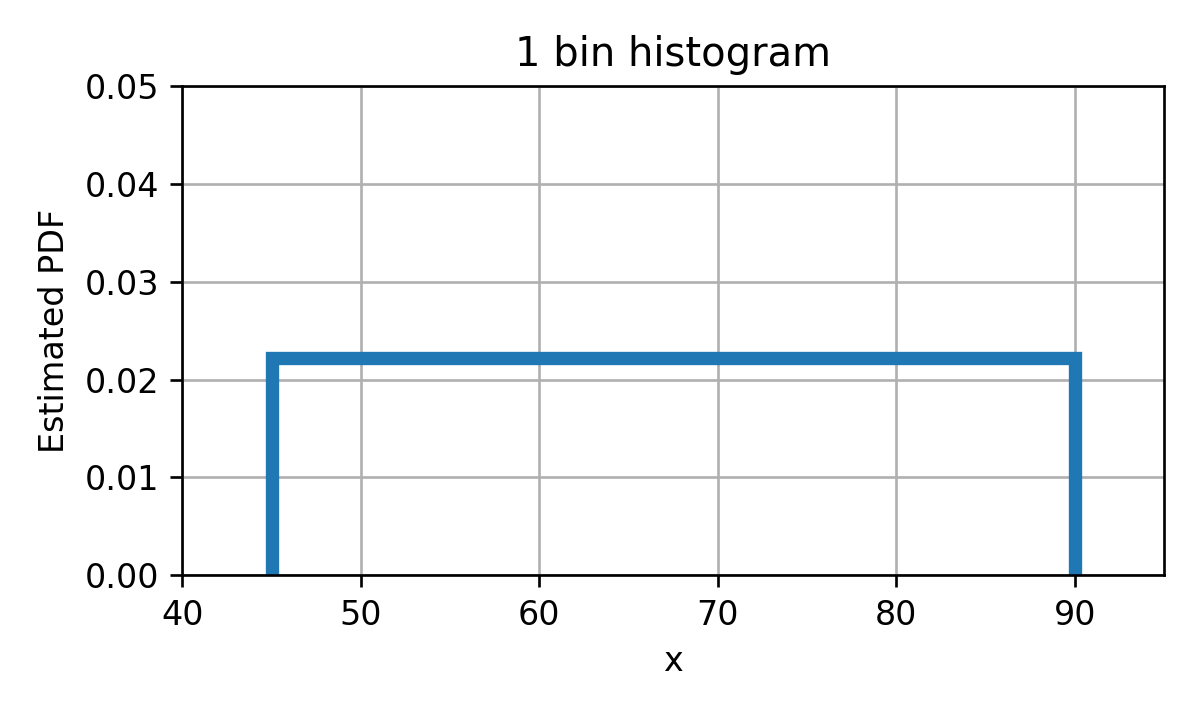

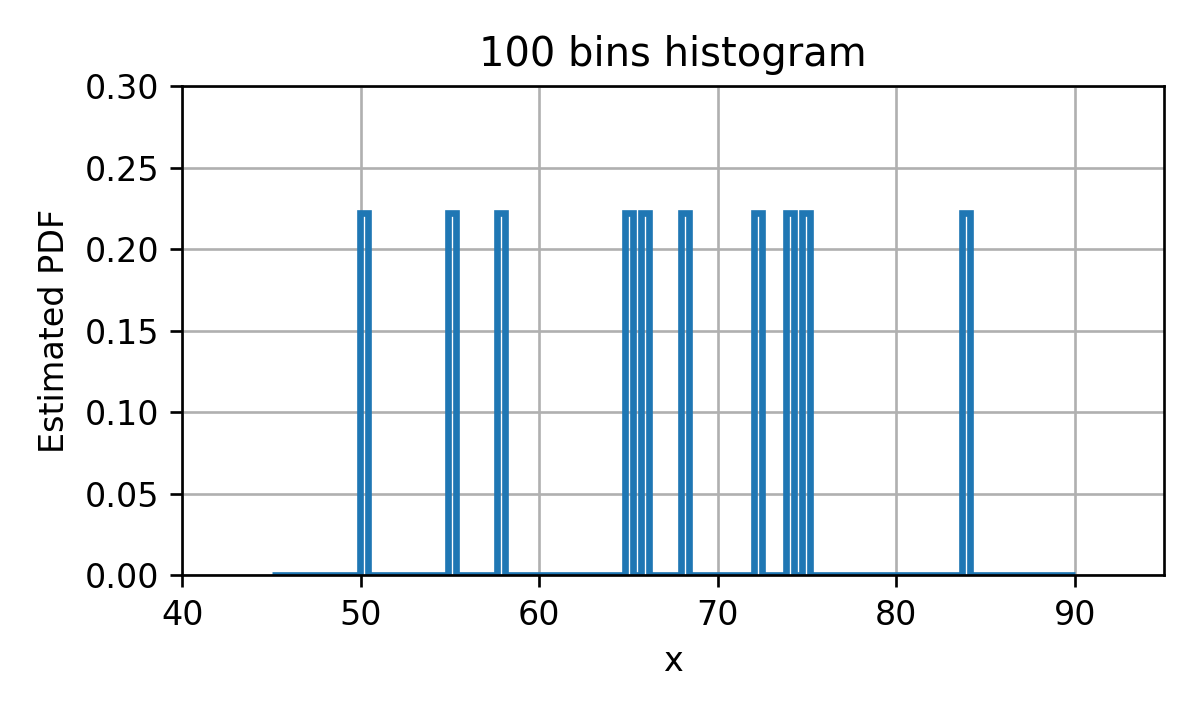

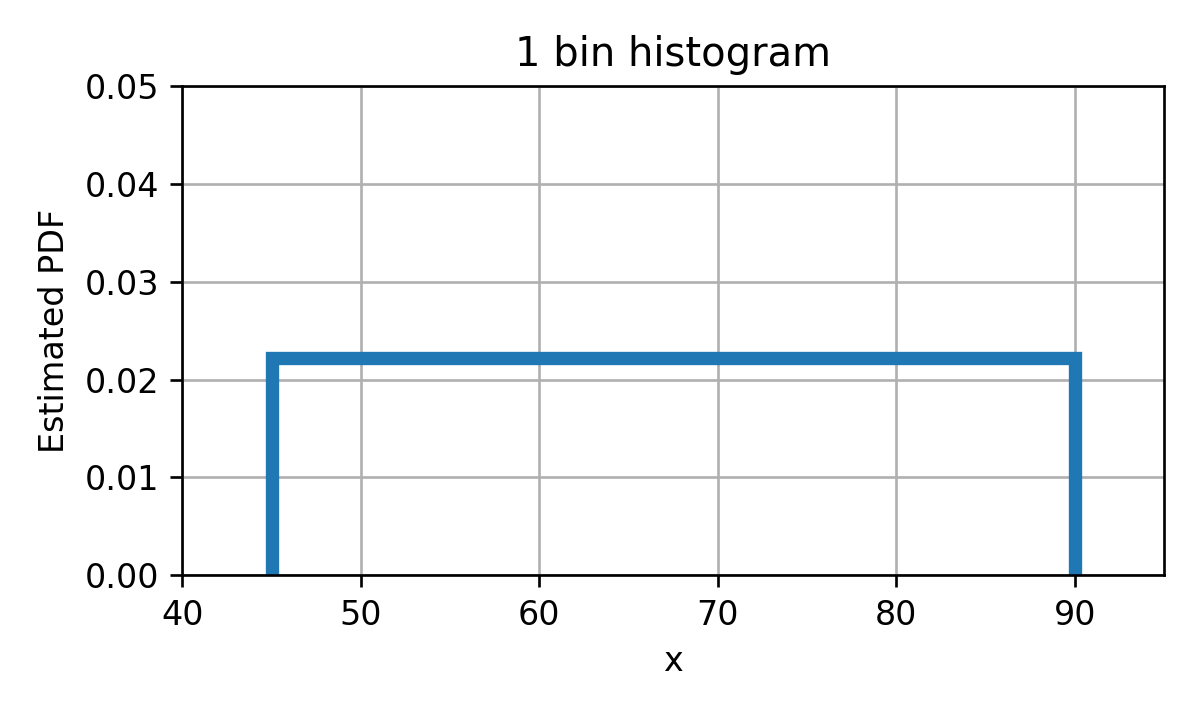

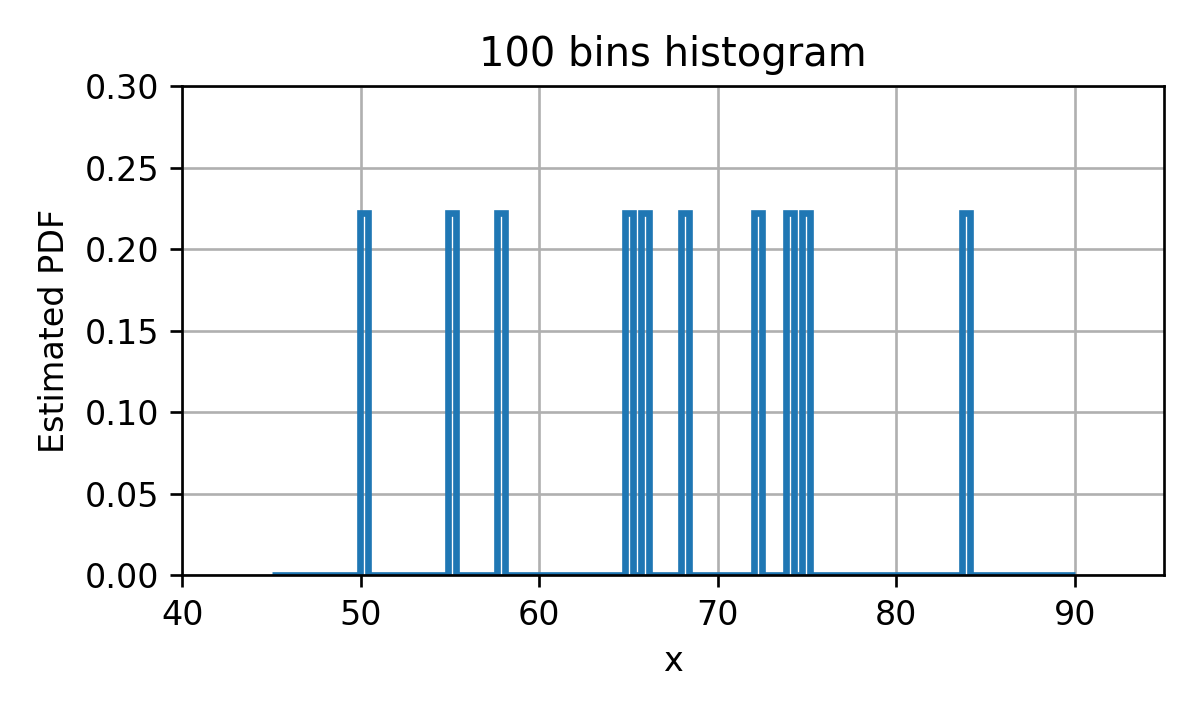

Overfitting ו underfitting של היסטוגרמה

דוגמא - שני מקרים קיצוניים

Overfitting ו underfitting של היסטוגרמה

מספר תאים קטן

Underfitting: יכולת מוגבלת לקרב את ה PDF האמיתי.

מספר תאים גדול

Overfitting: ההיסטוגרמה תתאר בצורה טובה את הדגימות אך לא את הפילוג האמיתי.

בחירת התאים

- מקובל לחלק ל k תאים אחידים בגודלם.

- מכיוון שה k האופטימאלי ישתנה מבעיה לבעיה, נאלץ לרוב לבחור אותו בעזרת ניסוי וטעיה.

- ישנם מספר כללי אצבע אשר במרבית המקרים יתנו תוצאה לא רעה.

- הכלל הנפוץ ביותר הינו לבחור את k להיות שורש מספר הדגימות במדגם (מעוגל כלפי מעלה): k=⌈N⌉

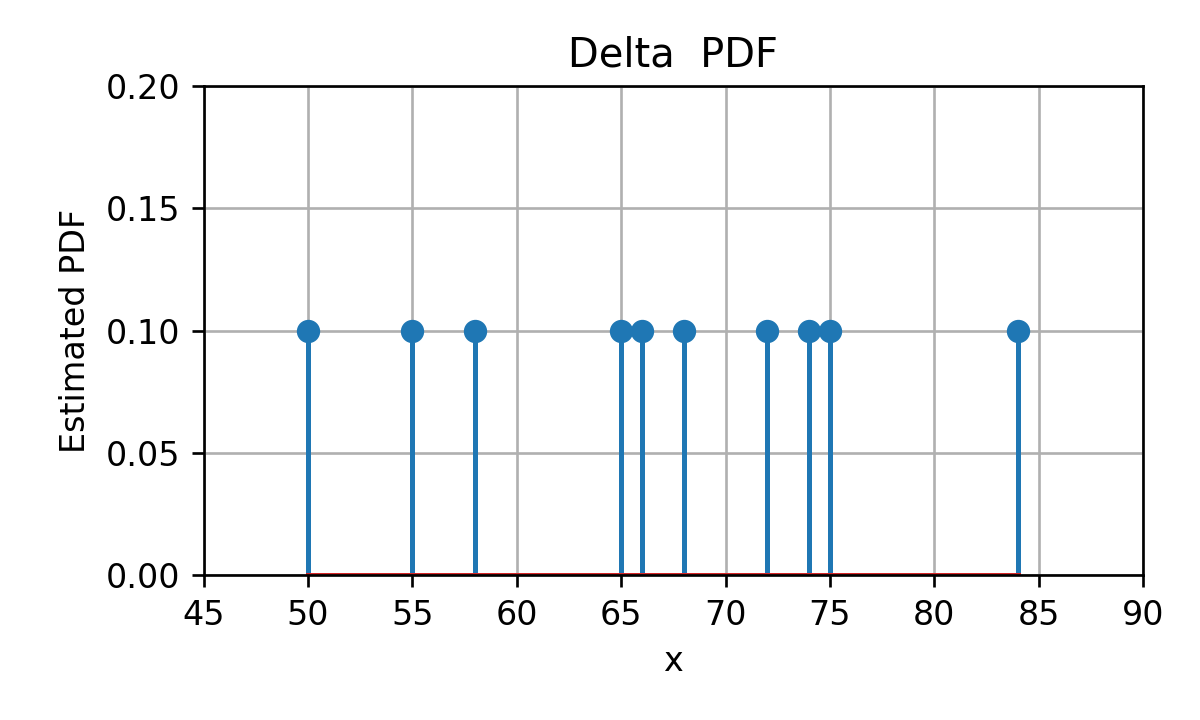

Kernel Density Estimation (KDE)

נתחיל מ PDF שבו אנו ממקמים פונקציית דלתא בגובה N1 בכל נקודה אשר מופיעה במדגם.

לדוגמא, בעבור זמני הנסיעה בכביש החוף נקבל:

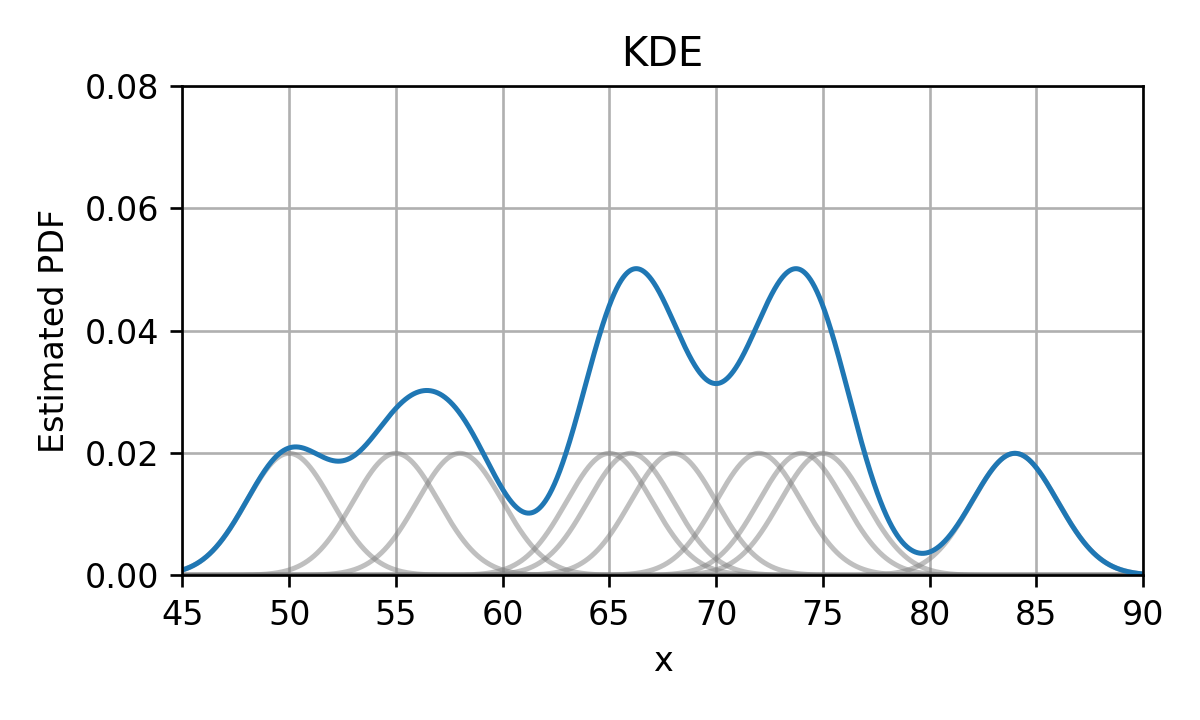

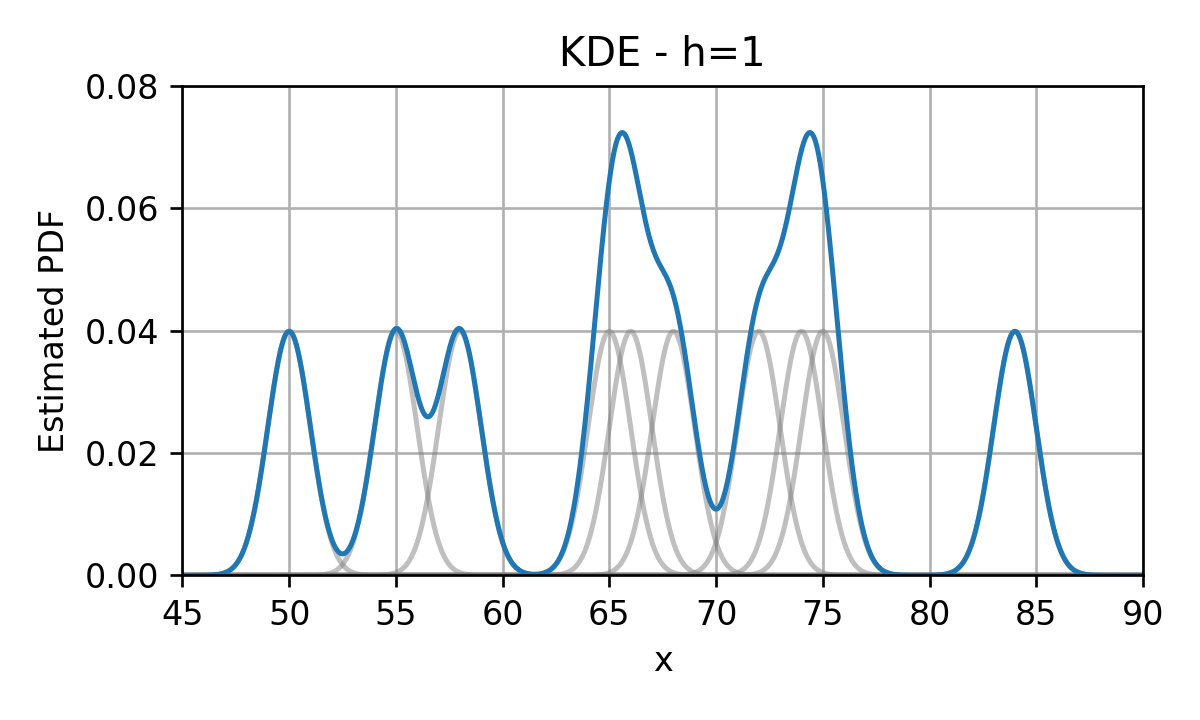

Kernel Density Estimation (KDE)

נחליף כל דלתא בפונקציית גרעין בעלת רוחב גדול מ-0.

לדוגמא גאוסיאנים:

Kernel Density Estimation (KDE)

נסכום את כל פונקציות הגרעין לקבלת ה PDF המשוערך:

Kernel Density Estimation (KDE)

- פונקציות הגרעין (kernel) מכונות גם Parzen window.

- ומקובל לסמנם ב ϕ(x).

אם כן, משערך ה KDE נתון על ידי:

p^x,ϕ,D(x)=N1i=1∑Nϕ(x−x(i))הערה: תנאי מספיק והכרחי בכדי שנקבל PDF חוקי, הינו שפונקציית הגרעיון תהיה בעצמה PDF חוקי.

בהקשר של עיבוד אותות: למעשה אנו מבצעים קונבולוציה בין פונקציית הדלתאות לבין פונקציית הגרעין. נרצה שהגרעין ישמש כמעיין low pass filter.

הוספת פרמטר רוחב

מקובל להוסיף פרמטר h אשר שולט ברוחב של הגרעין:

ϕh(x)=hD1ϕ(hx)בתוספת פרמטר זה המשערך יהיה:

p^x,ϕ,h,D(x)=NhD1i=1∑Nϕ(hx−x(i))

פונקציות גרעין נפוצות

שתי הבחירות הנפוצות ביותר לפונקציית הגרעין הינן:

-

חלון מרובע:

ϕh(x)=hD1I{∣xj∣≤2h∀j}

כלל אצבע עבור חלון ריבועי: נבחר את גודל החלון אדפטיבית כך שיכלול N דגימות מסביב לנקודה הנחקרת.

-

גאוסיאן:

ϕσ(x)=2πσD1exp(−2σ2∥x∥22)

כלל אצבע לבחירת רוחב הגרעין במקרה הגאוסי הסקלרי:

σ=(3N4⋅std(x)5)51≈1.06 std(x)N−51

שיערוך של פילוגים מעורבים

- נניח שאנו רוצים לשערך את הפילוג המשותף של x ו y כאשר x הוא משתנה רציף ו y הוא משתנה בדיד.

- במקרים כאלה נוח לפרק את פונקציית הפילוג המשותף באופן הבא:

ולהפריד את בעיית השיערוך לשני חלקים:

- השיערוך של py(y)

- השיערוך של px∣y(x∣y) - כאן נשערך את הפילוג בנפרד לכל ערך של y.

שיערוך של פילוגים מעורבים - דוגמא

נחזור לדוגמא של הונאות האשראי:

שיערוך של פילוגים מעורבים - דוגמא

נתחיל בשיערוך של y.

- y בדיד ולכן נוכל לשערך את ה PMF שלו על פי השכיחות של הערכים במדגם.

- מתוך ה 200 עסקאות ישנם 160 עסקאות חוקיות ו 40 עסקאות שחשודות כהונאה. לכן:

שיערוך של פילוגים מעורבים - דוגמא

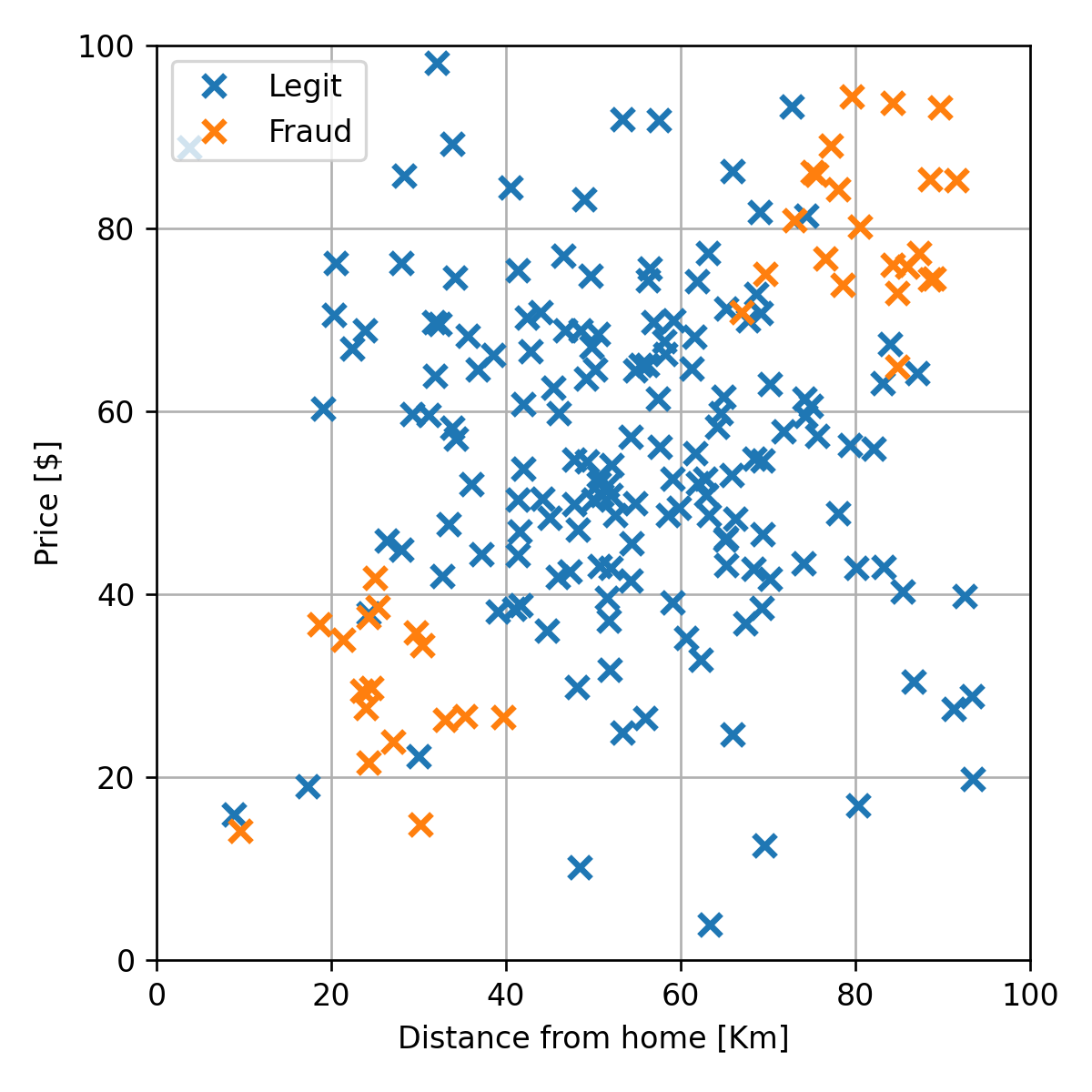

נמשיך לשיערוך של px∣y(x∣y).

- נשערך בנפרד את px∣y(x∣0) ואת px∣y(x∣1).

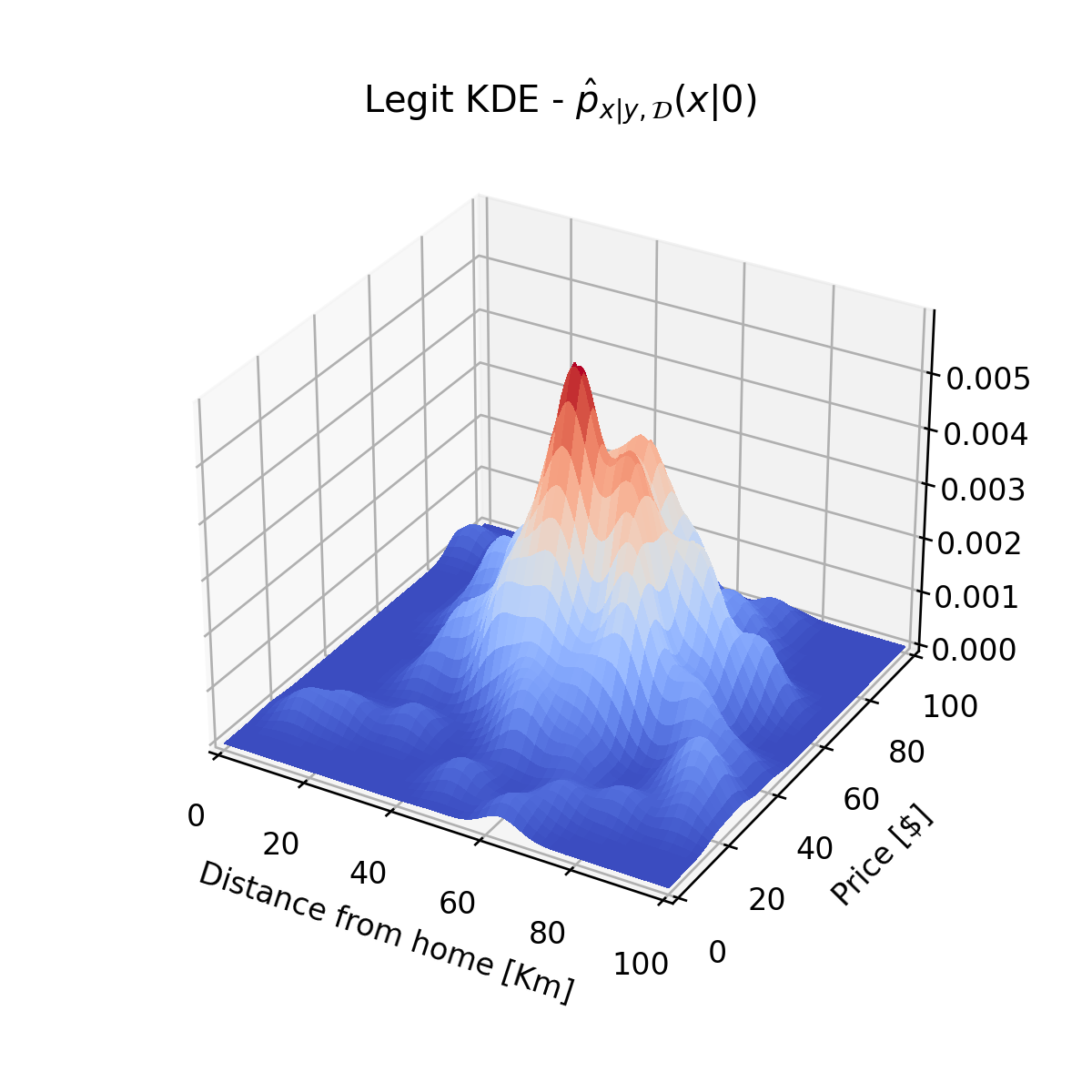

נתחיל מ px∣y(x∣0). בשביל לשערך פילוג זה נסתכל רק על הדגימות השייכות של y=0:

שיערוך של פילוגים מעורבים - דוגמא

נשתמש ב KDE על מנת לשערך את px∣y(x∣0):

שיערוך של פילוגים מעורבים - דוגמא

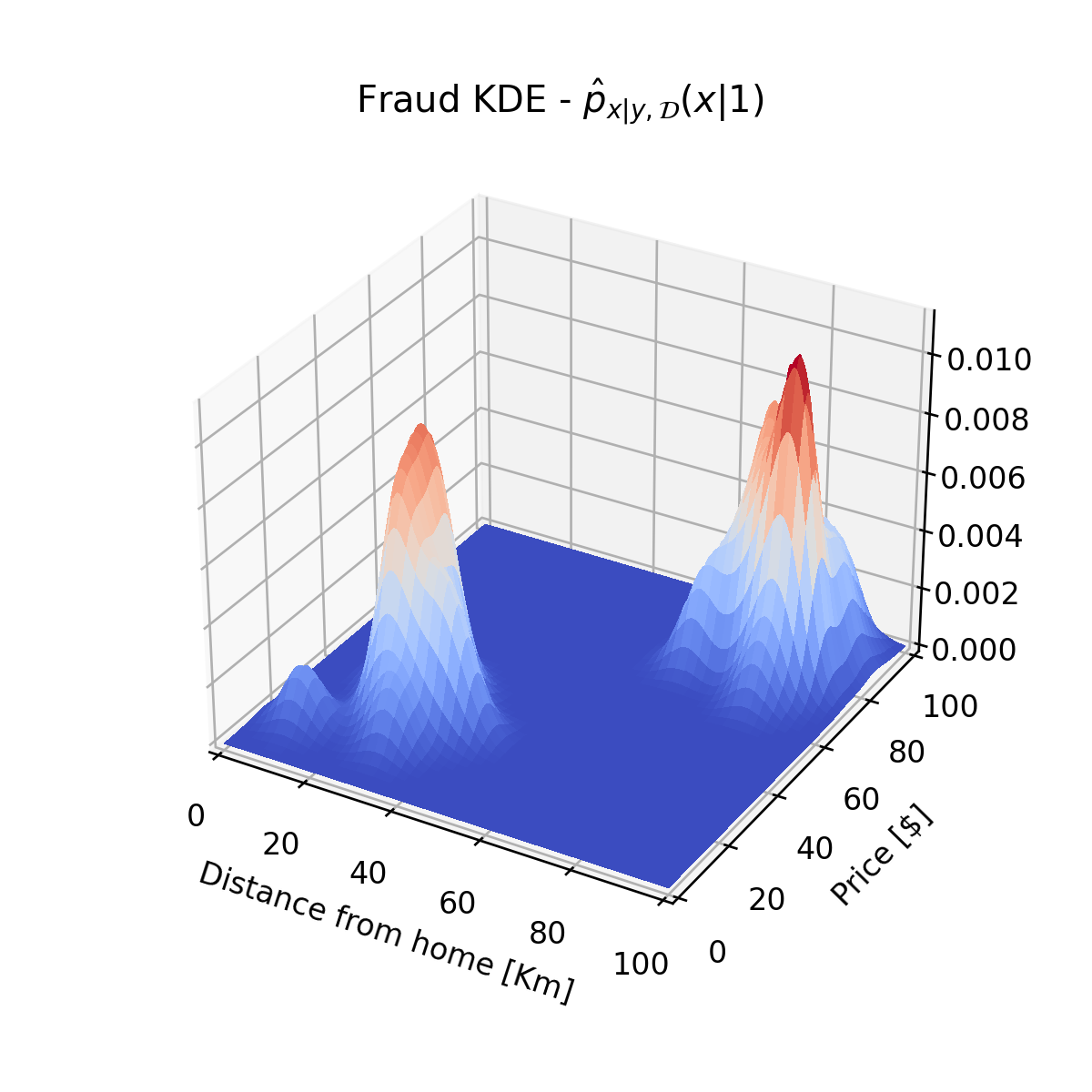

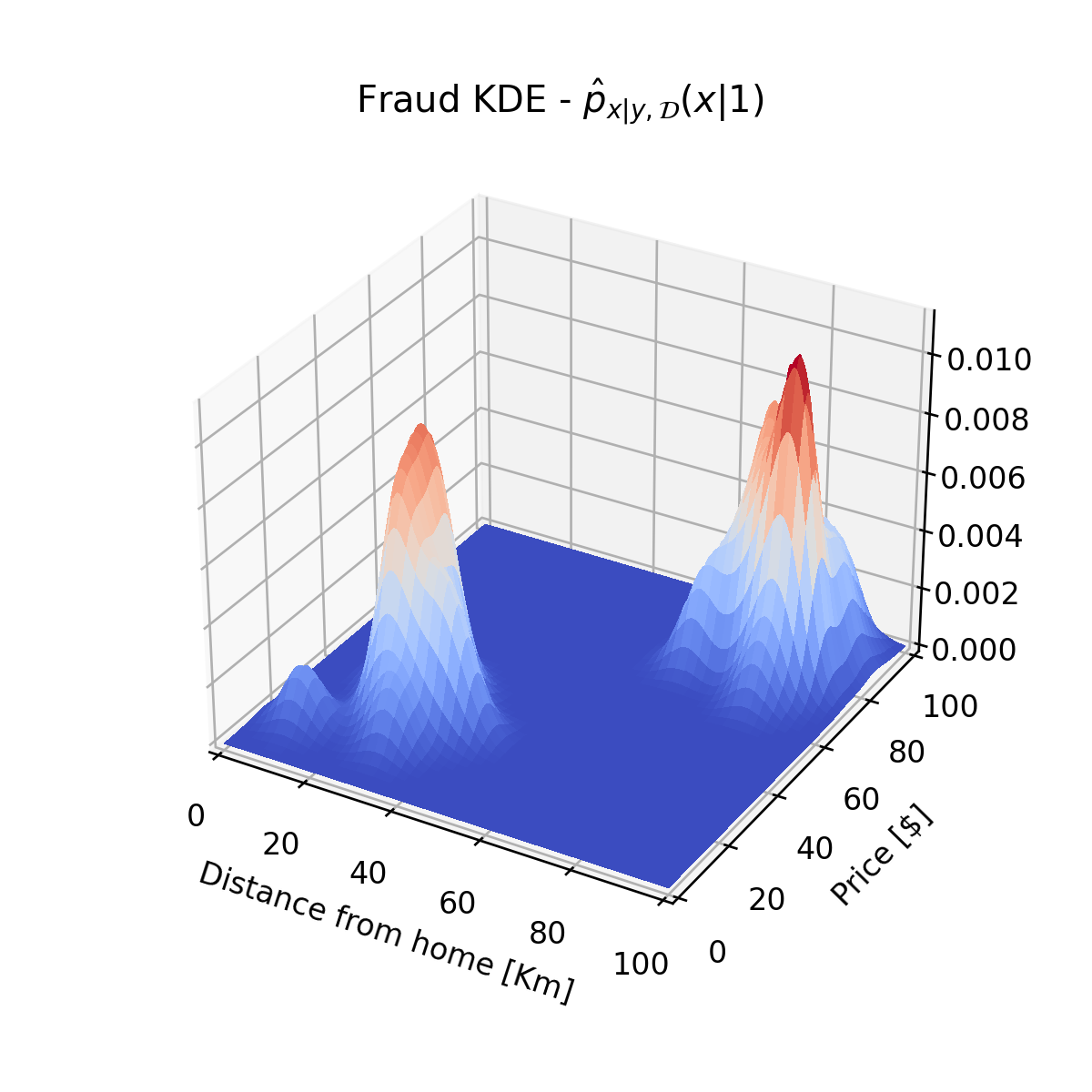

באופן דומה נשערך גם את px∣y(x∣1):

שיערוך של פילוגים מעורבים - דוגמא

p^y,D(y)={0.80.201

שלושת הפילוגים ששיערכנו מרכיבים את הפילוג המשותף על פי:

px,y(x,y)=px∣y(x∣y)py(y)שימוש בפילוג המשוערך לפתרון בעיות supervised learning

הגישה הגנרטיבית

מדגם

️▼

פילוג על סמך המדגם

️▼

חזאי אופטימאלי בהינתן הפילוג

עשינו את השלב הראשון, נעשה כעת את השלב השני.

חזאים אופטימאליים של פונקציות מחיר מוכרות - תזכורת

-

MSE: התוחלת המותנית:

h∗(x)=E[y∣x] -

MAE: החציון של הפילוג המותנה:

h∗(x)=ymedians.t. Fy∣x(ymedian∣x)=0.5(כאשר Fy∣x היא פונקציית הפילוג המצרפי של y בהינתן x).

-

Misclassification rate: הערך הכי סביר (ה mode):

h∗(x)=yargmax py∣x(y∣x)

דוגמא

בעבור הפילוג שמצאנו נחפש את החזאי אשר ממזער את ה misclassification rate.

h(x)=yargmax py∣x(y∣x)במקרה הבנארי חזאי זה שווה ל:

h(x)={10py∣x(1∣x)>py∣x(0∣x)elseאת py∣x(y∣x) נוכל לחשב מתוך הפילוג המשותף באופן הבא:

py∣x(y∣x)=px(x)px,y(x,y)=px(x)px∣y(x∣y)py(y)דוגמא

אם כן, בכדי לבדוק האם עסקה מסויימת הינה הונאה או לא, עלינו לבדוק האם:

py∣x(1∣x)⇔px(x)px∣y(x∣1)py(1)⇔px∣y(x∣1)py(1)>py∣x(0∣x)>px(x)px∣y(x∣0)py(0)>px∣y(x∣0)py(0)דוגמא

px∣y(x∣1)py(1)>px∣y(x∣0)py(0)נציב את פונקציות הפילוג ששיערכנו קודם לכן ונקבל את החזאי הבא:

ה misclassification rate של חזאי זה על ה test set הינו 0.12.

ה bias וה variance של משערך

- המשערכים תלויים בצורה חזקה במדגם שאיתו אנו עובדים.

- נסתכל על האקראיות של השיערוך הנובעת מהאקראיות של המדגם.

- נשתמש בסימון ED בכדי לסמן תוחלת על פני הפילוג של המדגם.

- נגדיר bias ו variance של משערך

ה bias וה variance של משערך

Bias

בעבור שיערוך של גודל כל שהוא z בעזרת משערך z^D, ה bias (היסט) של השיערוך מוגדר כ:

Bias(z^)=ED[z^D]−zכאשר ההטיה שווה ל-0, אנו אומרים שהמשערך אינו מוטה (Unbiased).

Variance

ה variance (שונות) של המשערך יהיה:

Var(z^)=ED[(z^D−ED[z^D])2]=ED[z^D2]−ED[z^D]2מספר ה bins במונחים של bias ו variance

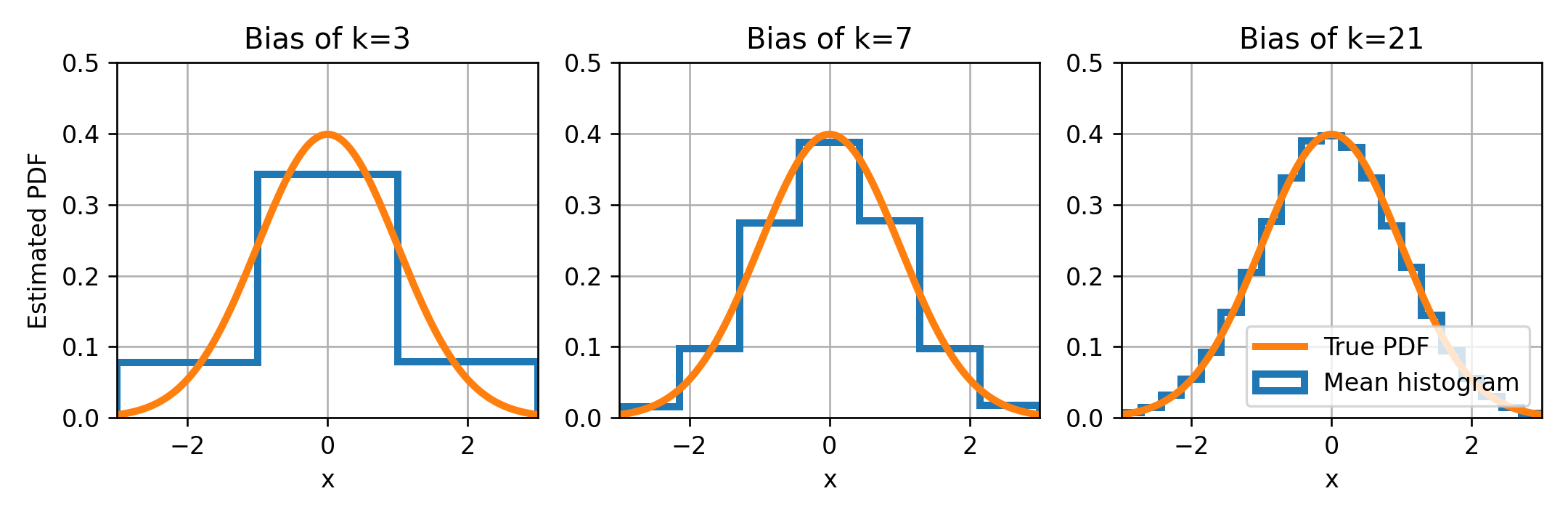

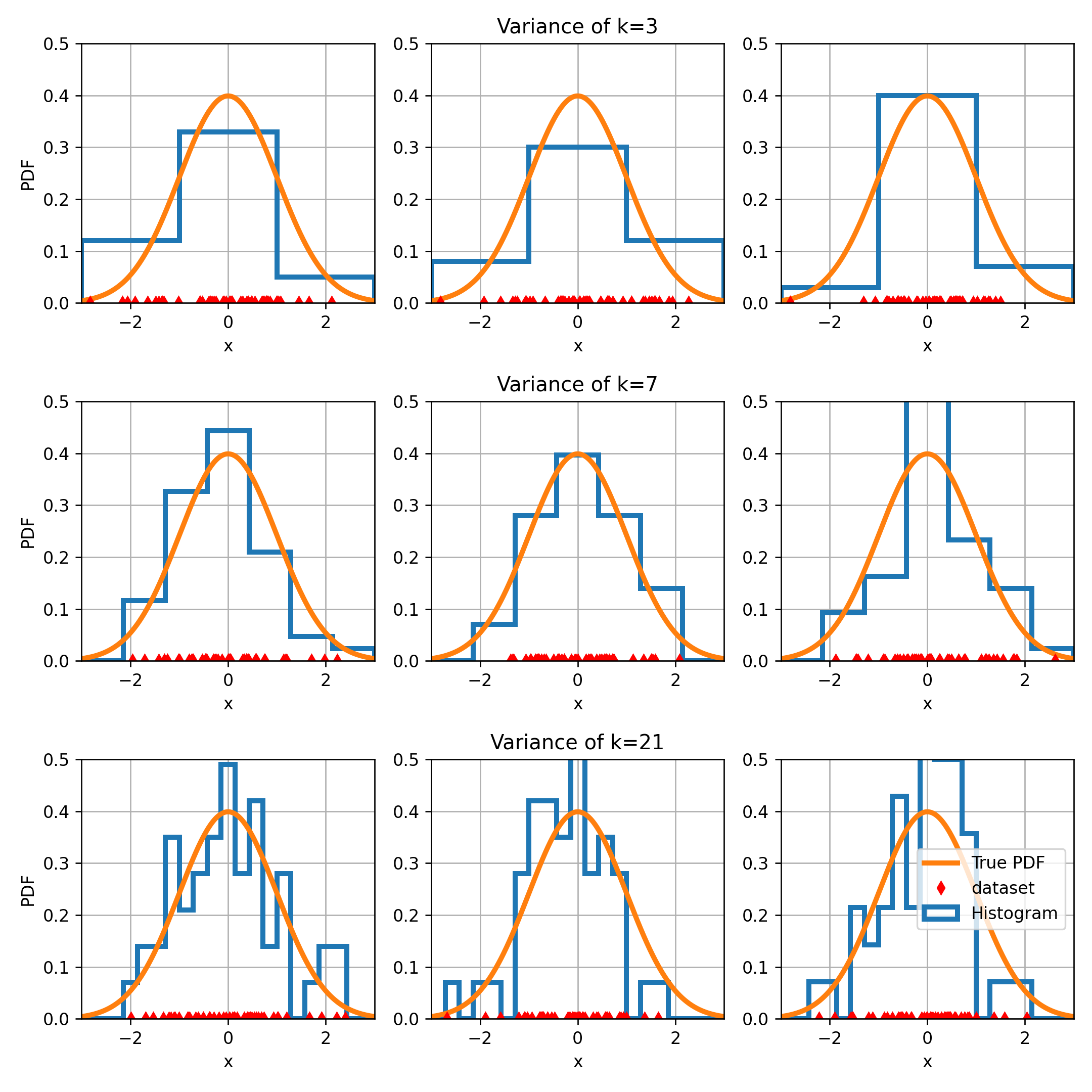

- ננסה לשערך את ה PDF של משתנה אקראי נורמאלי בעזרת היסטוגרמות בעלות 3, 7 ו 21 bins.

ה bias

נשרטט את ההיסטוגרמה הממוצעת לצד ה PDF האמיתי.

ה bias הוא ההפרש בין ההיסטוגרמה הממוצעת ל PDF האמיתי. ה bias קטן ככל שמספר ה bins גדל.

מספר ה bins במונחים של bias ו variance

מספר ה bins במונחים של bias ו variance

ה variance

- בכל שורה בגרף הקודם מגרילים שלושה מדגמים ומחשבים להם את ההיסטוגרמה.

- אנו מצפים שבעבור מקרים שבהם ה variance נמוך השינויים יהיו קטנים ובעבור variance גבוה השינויים יהיו גדולים.

- ה variance גדל ככל שאנו מגדילים את כמות ה bins.

בדומה לחזאים בגישה הדיסקרימינטיבית, גם בהיסטוגרמה ישנו bias-variance tradeoff.